- NVIDIA Vera CPU y Rubin GPU forman un sistema de seis chips integrado para IA, con foco en memoria, red y cómputo extremo.

- La GPU Rubin ofrece hasta 50 PFLOPS NVFP4 de inferencia, mientras que la CPU Vera aporta 88 núcleos Olympus y 1,5 TB de memoria LPDDR5X.

- NVLink 6, ConnectX-9, BlueField-4 y Spectrum-X permiten escalar desde un rack NVL72 hasta clústeres con miles de GPU Rubin.

- La plataforma reduce drásticamente el coste por token y habilita IA agéntica y modelos gigantes en entornos de producción.

La llegada de la plataforma NVIDIA Vera CPU y Rubin GPU marca un salto enorme en cómo se diseña el hardware para inteligencia artificial y computación de alto rendimiento. Ya no hablamos solo de una GPU más rápida o una CPU con más núcleos, sino de un ecosistema completo de seis chips que funcionan como una unidad pensada desde cero para IA generativa, IA agéntica y modelos gigantes de varios billones de parámetros.

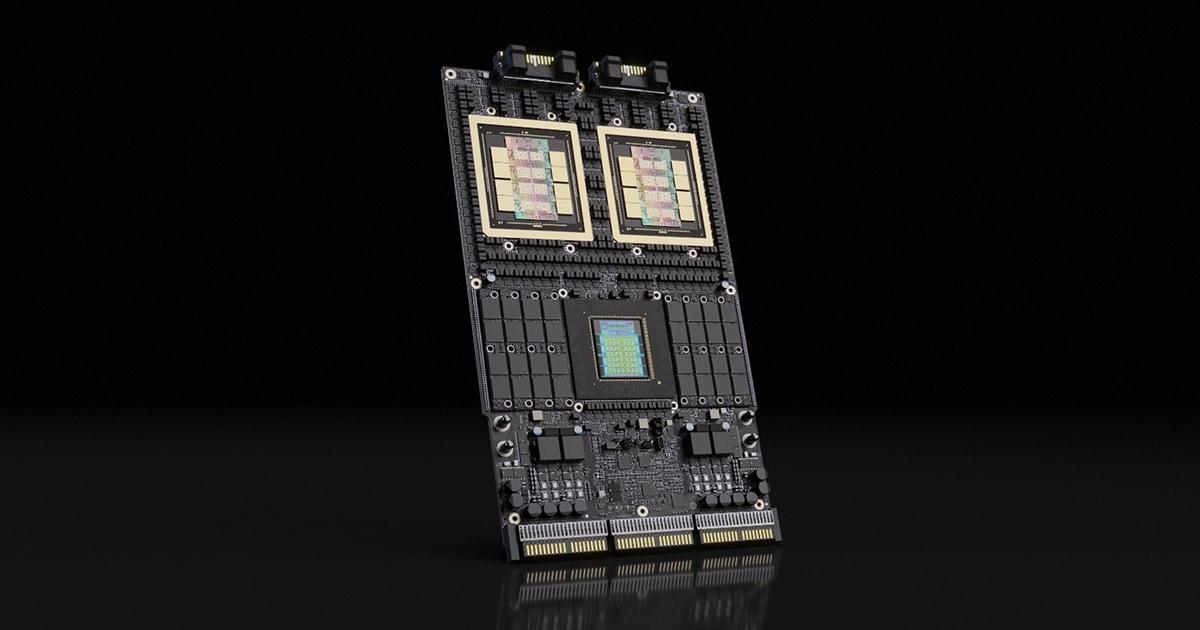

Este conjunto incluye la CPU NVIDIA Vera, la GPU Rubin, el conmutador NVLink 6, la DPU BlueField-4, la SuperNIC ConnectX-9 y la red Spectrum-X Ethernet. Todos ellos se integran en sistemas a escala de bastidor como NVIDIA Vera Rubin NVL72, capaces de ofrecer una potencia de cálculo descomunal con un foco muy claro: reducir el coste por token, aumentar la eficiencia energética y permitir que la IA con razonamiento complejo y memoria a largo plazo sea viable en producción.

Arquitectura global de NVIDIA Vera Rubin: seis chips, una sola plataforma

La arquitectura Vera Rubin se concibe como un sistema coordinado de seis componentes principales, no como piezas aisladas. El objetivo es que CPU, GPU, red y almacenamiento de contexto trabajen tan estrechamente integrados que, de cara al desarrollador o al operador del centro de datos, se perciban como una única entidad de cómputo.

En el corazón del diseño está la idea de co-diseño extremo: se han optimizado simultáneamente los chips, las interconexiones, el software y la topología de rack. Frente a generaciones donde el avance venía sobre todo del nodo de fabricación, aquí el salto se apoya en la integración profunda entre cómputo, memoria y red, y en la especialización hacia cargas de IA modernas como la inferencia de LLM con contextos enormes y agentes que requieren cadenas de pensamiento largas.

La plataforma se despliega en configuraciones DGX, HGX y MGX, y su pieza central es el Vera Rubin Superchip, que combina la CPU Vera con una o varias GPU Rubin mediante enlaces NVLink de altísimo ancho de banda. A partir de este bloque se construyen racks completos como el NVL72 y, a mayor escala, clústeres de decenas de bastidores interconectados con Spectrum-X.

CPU NVIDIA Vera: arquitectura Olympus con foco en memoria y razonamiento

La CPU NVIDIA Vera es el pilar de computación general de la plataforma, diseñada sobre una arquitectura Arm personalizada conocida como Olympus. No es una CPU genérica reaprovechada: está optimizada para tareas críticas en IA moderna como la gestión de datos, la orquestación de agentes y la preparación de grandes flujos de información para las GPU Rubin.

Vera integra 88 núcleos Olympus con soporte de dos hilos por núcleo, lo que se traduce en 176 hilos de ejecución simultánea gracias a la tecnología NVIDIA Spatial Multi-Threading. Esta configuración le permite duplicar el rendimiento frente a la anterior generación Grace en trabajos de procesamiento de datos, compresión, pipelines CI/CD y otras cargas auxiliares pero esenciales para el ciclo de vida de modelos de IA.

Uno de los puntos fuertes de Vera es su sub-sistema de memoria. Soporta hasta 1,5 TB de memoria LPDDR5X, triplicando la capacidad disponible en Grace, y ofrece un ancho de banda de hasta 1,2 TB/s. Este incremento resulta clave para workloads limitadas por memoria como la gestión de caché KV en LLM, la preparación de grandes datasets o las simulaciones HPC intensivas en datos.

Para la comunicación con el resto de chips, la CPU Vera incorpora una interconexión coherente NVLink-C2C con un ancho de banda de 1,8 TB/s. Esto permite que el tráfico entre CPU y GPU, o entre CPU y DPU, se gestione como si fuera parte de un mismo espacio de memoria coherente, reduciendo drásticamente la latencia y los cuellos de botella típicos de los sistemas heterogéneos.

Además, Vera extiende a escala de bastidor las capacidades de Confidential Computing, permitiendo que datos y modelos sensibles permanezcan cifrados y protegidos incluso mientras se procesan, algo decisivo para sectores regulados como sanidad, finanzas o administración pública.

GPU NVIDIA Rubin: motor de IA con hasta 50 PFLOPS en inferencia

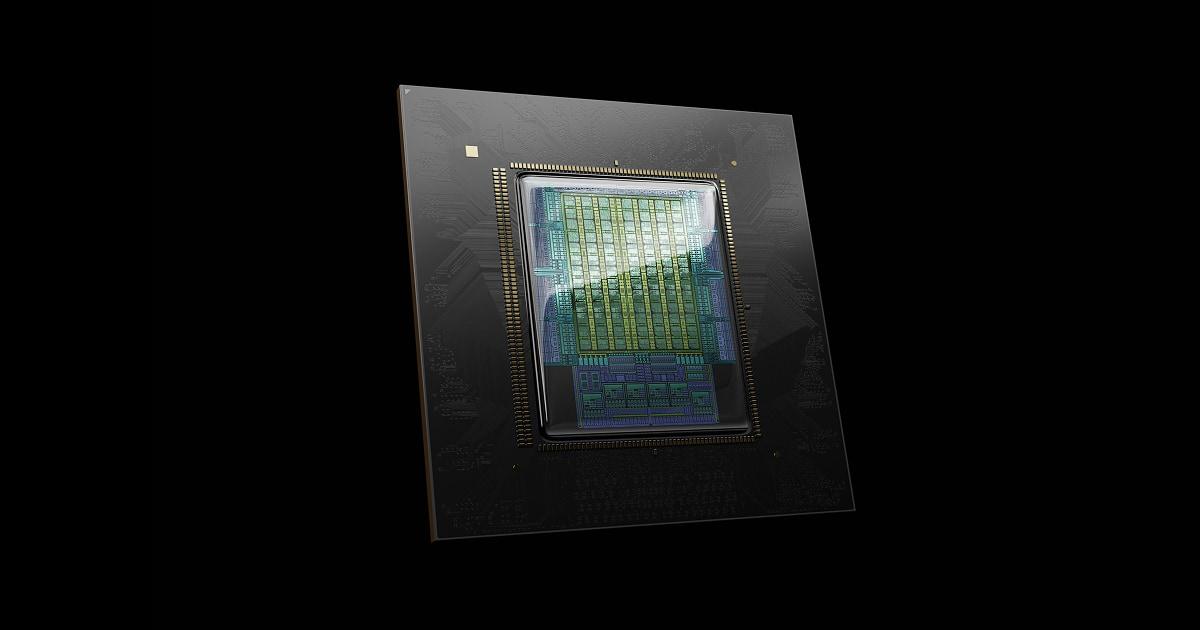

La pieza estrella para la mayoría de cargas de IA es la GPU NVIDIA Rubin, un procesador gráfico diseñado específicamente para entrenamiento e inferencia de modelos de inteligencia artificial de enorme tamaño. Rubin utiliza un diseño de doble die a nivel de retícula con aproximadamente 336.000 millones de transistores, lo que le permite alcanzar cifras de rendimiento espectaculares.

En tareas de inferencia con precisión NVFP4, la GPU Rubin llega hasta 50 PFLOPS, lo que supone aproximadamente 5 veces más rendimiento que una GPU Blackwell equivalente. En entrenamiento con la misma precisión NVFP4, se consigue alrededor de 3,5 veces más rendimiento, situándose en unos 35 PFLOPS declarados en algunas configuraciones de referencia.

Rubin no solo aumenta la potencia de cálculo, sino también la capacidad y el ancho de banda de memoria. Cada GPU integra memoria HBM4 con hasta 22 TB/s de ancho de banda, lo que supone doblar la generación anterior y proporciona un aumento de alrededor de 2,8 veces en throughput de memoria respecto a Blackwell. Para la comunicación con la CPU Veri y con otras GPU, Rubin dispone de 3,6 TB/s de ancho de banda NVLink por GPU, el doble que en la generación anterior.

Esta combinación de cómputo masivo y memoria ultrarrápida permite que Rubin se sitúe como referencia de facto para IA de centro de datos, especialmente en escenarios de inferencia de modelos gigantes, agentes con cadenas de razonamiento largas y simulaciones complejas donde el acceso rápido al contexto es tan importante como la potencia de cálculo.

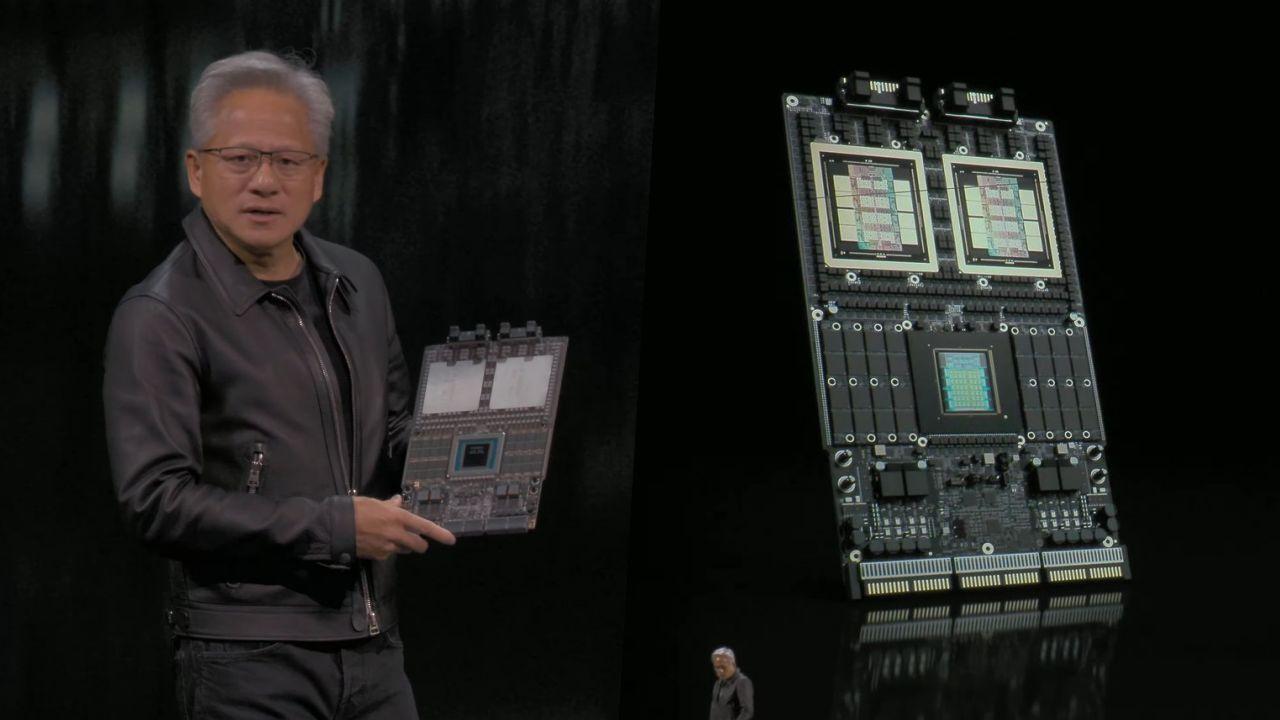

Cada módulo de cómputo Vera Rubin suele incorporar una CPU Vera y dos GPU Rubin, formando una unidad compacta con refrigeración líquida integrada. Estos módulos se agrupan luego en chasis y racks NVL72 para escalar la potencia a niveles de exaflops.

Red, almacenamiento de contexto y escalado: NVLink 6, ConnectX-9, BlueField-4 y Spectrum-X

Uno de los grandes cuellos de botella de la IA actual no está en el cálculo puro, sino en mover datos con la suficiente rapidez. Por ello, NVIDIA acompaña a Vera y Rubin con una infraestructura de red y almacenamiento diseñada específicamente para IA a gran escala, en la que destacan el NVLink 6 Switch, la SuperNIC ConnectX-9, la DPU BlueField-4 y la familia de switches Spectrum-X.

El conmutador NVLink 6 constituye la malla interna de interconexión entre GPUs y CPUs dentro de un rack o un pod. Ofrece enlaces 400G SerDes, un ancho de banda de hasta 3,6 TB/s all-to-all por CPU y un total agregado de 28,8 TB/s, además de unos 14,4 TFLOPS FP8 de cómputo en red para tareas de comunicación acelerada. Todo el sistema está refrigerado al 100% por líquido, lo que facilita densidades enormes en bastidor.

Para la conexión hacia el exterior del rack, la plataforma se apoya en la SuperNIC NVIDIA ConnectX-9 Spectrum-X, capaz de alcanzar hasta 800 Gb/s (1,6 Tb/s agregados) mediante Ethernet. Esta tarjeta de red incorpora capacidades avanzadas de RDMA programable, aceleración de la ruta de datos y un diseño con aproximadamente 23.000 millones de transistores, lo que la coloca en la élite de las NIC para centros de datos de IA.

La otra gran protagonista es la DPU NVIDIA BlueField-4, encargada de descargar de la CPU las tareas de red, almacenamiento y seguridad. Integra un CPU Grace de 64 núcleos y enlaces de hasta 800 Gb/s, ofreciendo aproximadamente 2 veces más rendimiento en gestión de red, 6 veces más capacidad de cómputo y 3 veces más ancho de banda de memoria que BlueField-3. BlueField-4 es también la base de la plataforma de almacenamiento de contexto para inferencia, conocida como Inference Context Memory Storage o NVIDIA Context Memory Storage Platform.

Completando el ecosistema de red está NVIDIA Spectrum-X Ethernet con óptica co-empaquetada (CPO) y fotónica de silicio a 200G. Esta solución ofrece hasta 102,4 Tb/s de capacidad de red scale-out, con 128 puertos de 800 Gb/s y 512 puertos de 200 Gb/s, gestionando alrededor de 352.000 millones de transistores en su conjunto y alcanzando hasta un 95% de ancho de banda efectivo a gran escala, con 5 veces más eficiencia, 10 veces más fiabilidad y 5 veces más rendimiento de aplicaciones que soluciones Ethernet tradicionales.

Rack NVIDIA Vera Rubin NVL72: superordenador de IA a escala de bastidor

Todo este hardware converge en el NVIDIA Vera Rubin NVL72, un rack de referencia que integra 72 GPU Rubin, 36 CPU Vera, múltiples SuperNIC ConnectX-9 y DPUs BlueField-4. Este sistema se basa en el diseño de bastidor NVIDIA MGX NVL72 de tercera generación, lo que garantiza compatibilidad con ecosistemas MGX anteriores y facilita una transición progresiva para los operadores de centros de datos.

Vera Rubin NVL72 destaca por su capacidad de entrenamiento e inferencia a un coste muy inferior respecto a la plataforma Blackwell. En concreto, NVIDIA habla de entrenar modelos con una cuarta parte del número de GPU necesario frente a Blackwell y de ofrecer una reducción de hasta 7 veces en el coste por millón de tokens en inferencia, y hasta 10 veces en algunos modelos de referencia como Kimi K2-Thinking.

El rack NVL72 proporciona, en conjunto, 3,6 EFLOPS NVFP4 de rendimiento en inferencia y alrededor de 2,5 EFLOPS en entrenamiento NVFP4, además de una capacidad de memoria LPDDR5X de 54 TB (2,5 veces más que en Blackwell) y aproximadamente 20,7 TB de HBM4 (1,5 veces más). El ancho de banda total de memoria HBM4 alcanza hasta 1,6 PB/s, con un incremento de 2,8 veces respecto a la generación previa, y el ancho de banda de escalado entre racks llega a unos 260 TB/s, duplicando el de Blackwell.

Uno de los aspectos más llamativos del NVL72 es su enfoque en la modularidad y la facilidad de mantenimiento. Los módulos se conectan entre sí sin cables y sin ventiladores en el propio rack, utilizando diseños de bandejas modulares refrigeradas por líquido. Este enfoque reduce la complejidad, mejora la fiabilidad, facilita el reemplazo de componentes y contribuye a que el sistema sea aproximadamente el doble de eficiente energéticamente que generaciones anteriores.

Escalado masivo: de un NVL72 a clústeres con miles de GPU Rubin

La arquitectura Vera Rubin está pensada para escalar más allá del rack individual. NVIDIA ha descrito configuraciones de hasta 16 racks NVL72 interconectados mediante NVLink 6 y Spectrum-X, dando lugar a sistemas con 1.152 GPU Rubin y 576 CPU Vera que pueden trabajar prácticamente como un superordenador unificado para entrenamiento de modelos extremos.

En estas configuraciones, la latencia de comunicación entre chips se reduce al mínimo gracias al uso de óptica de silicio integrada y a la eliminación de miles de cables y transceptores. Ese recorte de latencia es fundamental para modelos de billones de parámetros, donde cualquier retraso en la sincronización entre GPU puede prolongar los tiempos de entrenamiento semanas.

Para la inferencia a gran escala, la combinación de Inference Context Memory Storage (basado en BlueField-4) con Spectrum-X Ethernet permite multiplicar por cinco los tokens por segundo y por seis la eficiencia respecto al almacenamiento empresarial clásico. En la práctica, esto significa que los centros de datos pueden servir modelos de enorme tamaño a un coste por token mucho más bajo, haciéndolos viables para aplicaciones comerciales masivas.

La plataforma Rubin debutará en configuraciones como DGX SuperPOD con ocho racks Vera Rubin NVL72 y en sistemas DGX Rubin NVL8 orientados a centros de datos más convencionales, lo que abre el abanico tanto para grandes proveedores cloud como para empresas que quieren desplegar sus propios clústeres en local.

Contexto de mercado, IA agéntica y oportunidades para Big Data e IA

La presentación de Vera Rubin en el CES de Las Vegas se ha interpretado como un momento clave en la industria, hasta el punto de que muchos analistas consideran que la Ley de Moore deja de ser el único referente para medir el progreso tecnológico. En lugar de centrarse exclusivamente en el escalado de transistores, NVIDIA apuesta por arquitecturas donde el diseño conjunto de hardware, red y software define los nuevos límites de lo posible.

Para estudiantes y profesionales de Big Data e Inteligencia Artificial, la relevancia de Vera Rubin va mucho más allá de las especificaciones. Esta plataforma está orientada a la IA agéntica y el razonamiento complejo, permitiendo que modelos avanzados no solo generen texto o imágenes, sino que planifiquen, descompongan tareas en múltiples pasos y mantengan una memoria de contexto extensa a lo largo del tiempo.

La mejora de hasta 10 veces en coste por token tiene implicaciones directas en el acceso a la IA avanzada. Proyectos universitarios, startups y empresas medianas podrán aprovechar recursos de cómputo que antes solo estaban al alcance de gigantes tecnológicos. La reducción de barreras económicas, sumada a mejoras en rendimiento y eficiencia, augura una fase de hiper-aceleración en la adopción de IA en casi todos los sectores.

A la vez, el ecosistema Rubin se acompaña de iniciativas como el Frontier AI Model Builder, una plataforma de modelos abiertos de NVIDIA entrenados con sus superordenadores, orientada a seis áreas principales: conducción autónoma (Alpamayo), robótica y simulación (Cosmos), robots con modelos VLA (GR00T), IA multimodal y de razonamiento (Nemotron), ciencia y clima (Earth-2) y atención médica (Clara). Este catálogo facilita que las organizaciones se centren en el despliegue y la personalización, en lugar de arrancar desde cero.

Todo se enmarca en un contexto de inversiones millonarias en infraestructura de IA para los próximos años, con estimaciones que sitúan el esfuerzo global entre 3 y 4 billones de dólares. En este escenario, los perfiles capaces de entender tanto los algoritmos como la infraestructura subyacente (NVLink, BlueField, Spectrum-X, gestión de memoria, etc.) serán especialmente demandados.

La combinación de CPU NVIDIA Vera, GPU Rubin, NVLink 6, BlueField-4, ConnectX-9 y Spectrum-X da lugar a una arquitectura que no solo incrementa de manera brutal el rendimiento frente a Blackwell, sino que además redefine la economía de entrenar e inferir con modelos de IA gigantes. Con racks NVL72 listos para producción, una integración profunda a nivel de rack y pod y una orientación clara hacia la IA agéntica y el razonamiento complejo, Vera Rubin se posiciona como la base sobre la que se construirá buena parte de la infraestructura de IA de la segunda mitad de la década.