- La eDRAM es DRAM integrada en el propio chip que ofrece alto ancho de banda y menor latencia a costa de un proceso de fabricación más caro.

- Combina una gran densidad por área, cercana a la DRAM externa, con un rendimiento superior gracias a buses internos muy anchos y cortos.

- Se usa como gran caché o buffer en CPUs, GPUs y consolas, encajando entre la SRAM de caché y la RAM DDR/HBM del sistema.

- El auge de la IA y los centros de datos dispara la demanda de todas las variantes de DRAM, incluida la memoria embebida en chips avanzados.

La memoria eDRAM se ha convertido en una de esas tecnologías de las que se habla mucho cuando salen nuevos procesadores, consolas o chips para centros de datos, pero casi nunca se explica con calma qué es exactamente ni en qué se diferencia de la RAM «normal». Si te pierdes entre siglas como DRAM, SRAM, HBM o DDR5 y quieres saber qué memoria es más rápida, la RAM o la caché, no te preocupes: vamos a ordenar todas las piezas y a conectarlas con el auge actual de la Inteligencia Artificial.

En las siguientes líneas vas a encontrar una explicación en profundidad, pero en lenguaje claro, sobre qué es la eDRAM, cómo funciona, por qué es más cara, en qué se parece y en qué no a la RAM tradicional y cómo encaja todo eso en el ecosistema de memorias (DDR, GDDR, VRAM, etc.) y en el boom de IA y centros de datos que está disparando la demanda de chips de memoria en bolsa.

Qué es exactamente la memoria eDRAM

La sigla eDRAM viene de embedded Dynamic Random Access Memory, es decir, memoria DRAM “embebida” o integrada dentro de otro circuito. En lugar de tener los chips de RAM en módulos aparte (DIMM, SO‑DIMM, etc.), la eDRAM se fabrica en el mismo troquel o en el mismo módulo de matriz (MCM) que un microprocesador, una GPU o un ASIC específico.

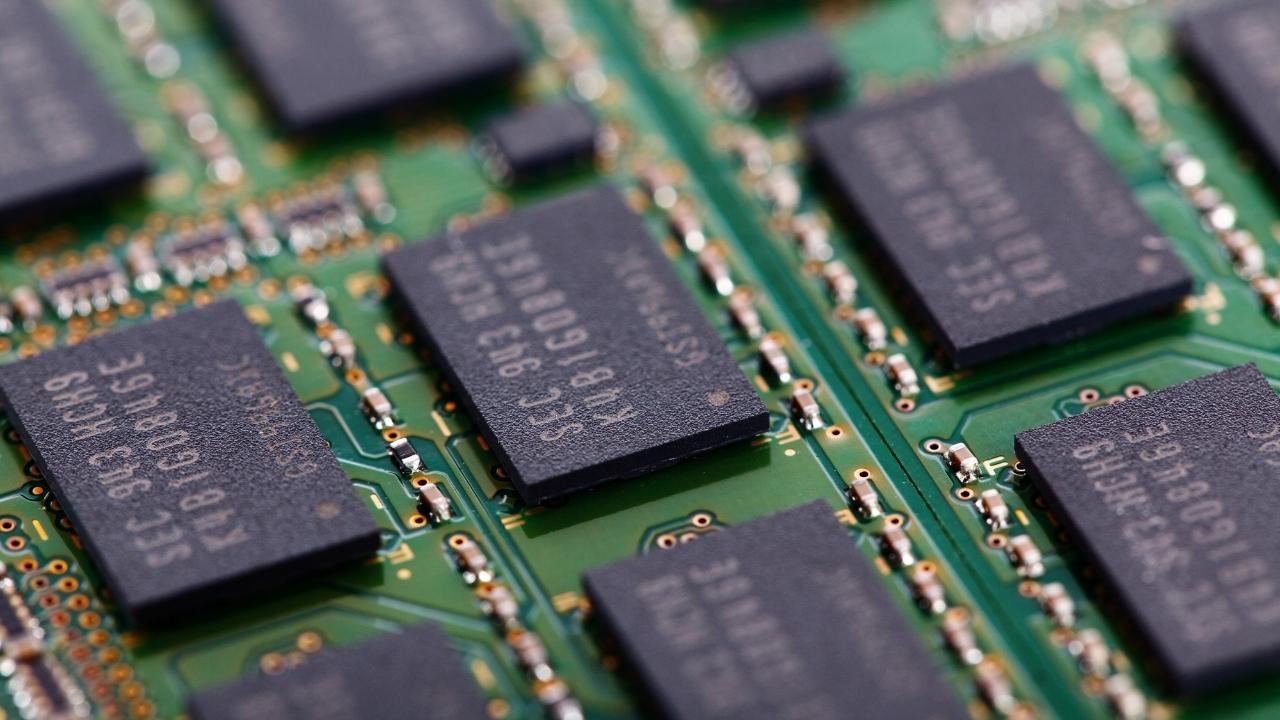

En esencia, una celda de eDRAM es la misma DRAM de toda la vida: cada bit se almacena en un condensador que debe refrescarse de forma periódica para que no pierda la carga eléctrica. Lo que cambia no es la física del bit, sino dónde se coloca esa memoria y qué consecuencias tiene eso para el rendimiento, el coste y la complejidad del chip.

Al estar pegada al procesador, la eDRAM permite buses de datos mucho más anchos y frecuencias de operación bastante más altas que las de un módulo DRAM externo, donde hay que pasar por pistas largas de la placa base, zócalos, conectores y todas sus inductancias y capacitancias asociadas. Ese acceso más directo se traduce en menos latencia y mucho más ancho de banda.

En comparación con la SRAM (la que se usa para las cachés L1, L2, L3), la eDRAM tiene una ventaja clave: densidad superior. Una celda de SRAM necesita varios transistores; una celda de DRAM se suele implementar con un transistor y un condensador. Eso significa que, para un área de silicio determinada, cabe bastante más eDRAM que SRAM, lo que permite diseñar cachés y buffers de tamaño muy grande sin que el chip se dispare en superficie.

Ventajas clave de la eDRAM frente a otras memorias

La primera ventaja de la eDRAM es el salto de rendimiento que ofrece frente a una DRAM convencional situada fuera del chip. Las distancias eléctricas son mínimas, los buses internos pueden ser ridículamente anchos (cientos o miles de bits en paralelo) y se puede sincronizar todo con el mismo reloj del procesador o de la GPU.

Además, al ser DRAM y no SRAM, se consigue una densidad por área muy superior. En muchos procesos de fabricación, el uso de eDRAM reduce el área de silicio ocupada por la memoria en un factor aproximado de 3x respecto a una SRAM equivalente. Esa reducción no es trivial: un chip grande cuesta mucho más de fabricar y tiene más probabilidad de defectos, así que cada milímetro cuadrado que se ahorra puede marcar la diferencia económica.

Este compromiso entre densidad y rendimiento convierte a la eDRAM en una especie de punto intermedio muy interesante entre la SRAM ultrarrápida pero muy cara en área y la DRAM externa, mucho más lenta porque viaja por la placa base. Ideal, por ejemplo, para implementar grandes cachés de último nivel o memoria de vídeo integrada que sirva a la GPU o al procesador gráfico del sistema.

Otro aspecto importante es que, si el controlador de refresco se integra en el propio bloque de eDRAM, el resto del chip puede tratar esa memoria prácticamente como si fuera SRAM “sencilla”: se eliminan muchos detalles feos de gestión interna, de modo similar a lo que se hace en arquitecturas comerciales como 1T‑SRAM. Desde el punto de vista del diseñador del procesador, eso simplifica bastante la lógica de acceso.

Por último, se pueden aplicar trucos arquitectónicos para mitigar la sobrecarga del refresco cuando la eDRAM se usa como nivel de caché. Por ejemplo, técnicas que reorganizan las líneas de caché, distribuyen el refresco en periodos de baja actividad o agrupan accesos para minimizar conflictos con los ciclos de mantenimiento de células.

Costes y limitaciones de la memoria eDRAM

No todo son ventajas, claro. El gran “pero” de la eDRAM es que sube el coste de fabricación del chip. Para integrar DRAM en el mismo troquel que una CPU o una GPU hay que añadir pasos tecnológicos adicionales al proceso de fabricación estándar de lógica (más máscaras, más deposiciones, más litografías), y cada paso extra significa dinero y posibles defectos.

Por eso, el coste por bit de eDRAM es sensiblemente mayor que el de un chip DRAM discreto (los típicos integrados que ves soldados en un módulo DIMM). Aun así, en muchos diseños de gama alta, el beneficio en rendimiento y eficiencia compensa con creces ese sobrecoste, sobre todo cuando se necesitan grandes volúmenes de memoria muy rápida dentro del propio encapsulado.

Otro inconveniente es la complejidad añadida en el diseño del chip: hay que integrar bancos de DRAM, controladores de refresco, buses internos de gran ancho y toda la lógica de coherencia con las cachés SRAM. Esa mezcla de bloques lógicos y de memoria densa complica el enrutado físico y el cierre de tiempos, especialmente en procesos avanzados.

A nivel de funcionamiento, el refresco periódico de las celdas de DRAM (parámetros como TRFC y TFAW) supone una sobrecarga inevitable. Aunque se minimice con arquitecturas inteligentes, ese refresco consume energía y puede causar pequeños parones o reducción de ancho de banda efectivo si coincide con ráfagas intensas de acceso.

Por todo esto, la eDRAM no es una solución universal que sustituya a toda la RAM del sistema. Suele emplearse como memoria intermedia muy rápida y de gran capacidad (por ejemplo, como caché de último nivel o como buffer gráfico), mientras que la memoria principal del sistema sigue siendo DRAM convencional en módulos externos más baratos y fácilmente ampliables.

Ejemplos reales de uso de eDRAM

Muchas arquitecturas comerciales han apostado en algún momento por la eDRAM. Un ejemplo muy conocido es el procesador POWER7 de IBM, que integraba grandes cantidades de eDRAM en el propio chip para implementar sus enormes cachés L3, clave en entornos de servidores de alto rendimiento.

Intel también coqueteó con esta tecnología en algunas generaciones de sus procesadores Core, en especial en la familia Haswell con gráficos GT3e. Estos modelos añadían un bloque de eDRAM que actuaba como una caché de alta velocidad para la GPU integrada y, en algunos casos, para la CPU, mejorando notablemente el rendimiento gráfico sin recurrir a memoria GDDR externa.

El mundo de las consolas de videojuegos es otro terreno donde la eDRAM ha brillado. Muchas máquinas han recurrido a memoria integrada de alta velocidad para aliviar el cuello de botella entre la GPU y la RAM del sistema. Ejemplos históricos incluyen PlayStation 2, PlayStation Portable, Nintendo GameCube, Wii, Wii U o la Xbox 360, donde bloques de eDRAM se usaban como framebuffer y como caché gráfica.

Más allá de consolas y CPUs de escritorio, se han utilizado variantes de DRAM embebida en dispositivos móviles y reproductores multimedia, como ciertos modelos de iPhone, el Zune HD de Microsoft y otros gadgets en los que era crítico exprimir cada milímetro de silicio para obtener una buena experiencia gráfica y de usuario.

Todo esto muestra que la eDRAM es especialmente atractiva cuando se necesita mucho ancho de banda de memoria en un espacio reducido: gráficos integrados potentes, consolas, servidores de gama alta y, cada vez más, aceleradores para IA.

Dónde encaja la eDRAM en el ecosistema de memorias

Para situar la eDRAM en contexto, conviene repasar rápidamente el “árbol genealógico” de la memoria RAM. A grandes rasgos, en ordenadores y dispositivos actuales conviven tres grandes familias: SRAM, DRAM y VRAM, con un buen montón de variantes en cada una.

La SRAM (Static RAM) es la memoria más rápida y cara en términos de área. No necesita refresco, lo que simplifica el controlador y reduce latencias, pero sus celdas utilizan varios transistores, así que la densidad es baja. Es la que se usa en las cachés L1, L2 y buena parte de las L3 dentro de la CPU y la GPU.

La DRAM (Dynamic RAM) es la que tradicionalmente conocemos como RAM principal: cada bit es un condensador que hay que refrescar, pero en compensación se puede empaquetar muchísima memoria en poco espacio. Dentro de la DRAM tenemos:

- DRAM asíncrona clásica, hoy casi desaparecida.

- SDRAM (Synchronous DRAM), que se sincroniza con el reloj del sistema.

- Variantes como FPM, EDO, BEDO, que fueron mejorando poco a poco el rendimiento antes de la revolución síncrona.

Sobre la SDRAM síncrona se construyó la familia DDR SDRAM (Double Data Rate), que es la que montan los PCs y servidores modernos en forma de módulos DIMM:

- DDR, DDR2, DDR3, DDR4 y DDR5, cada una con más velocidad, más ancho de banda y mejor eficiencia que la anterior.

- También hay variantes específicas como LPDDR para móviles y portátiles de bajo consumo.

La VRAM o memoria de vídeo engloba a varios tipos de memoria optimizados para uso gráfico. Históricamente incluía memorias de doble puerto (dual‑ported) y hoy en día se asocia sobre todo a GDDR y HBM, memorias especializadas en ofrecer muchísimo ancho de banda a GPUs y aceleradores.

La eDRAM entra aquí como una subvariante de la DRAM que se fabrica integrada dentro del chip. Puede actuar como caché para la DRAM externa, como buffer gráfico o como memoria local ultrarrápida en chips específicos. En algunos productos ha convivido con VRAM externa (como GDDR) y en otros la ha sustituido parcialmente.

Tipos de módulos y formatos de memoria RAM en PCs

Cuando hablamos de RAM “normal” en un PC de sobremesa, en realidad nos referimos a módulos de memoria que agrupan muchos chips DRAM en un pequeño circuito impreso. Existen varios formatos históricos que ayudan a entender cómo hemos llegado a los DIMM actuales.

Los primeros en popularizarse fueron los SIMM (Single In‑line Memory Module), módulos antiguos que se montaban en ordenadores de hace décadas. Empezaron con versiones de 30 pines y bus de 8 bits, y luego se estandarizaron en formatos de 72 pines y 32 bits. Estos módulos podían ser sin paridad, con paridad, de página rápida o EDO, cada uno con pequeñas mejoras en fiabilidad o rendimiento.

La velocidad de los SIMM se medía en nanosegundos (ns), con valores típicos de 70, 60 o 15 ns. A medida que los procesadores y los buses del sistema aceleraban, esos tiempos se quedaban cortos, y la industria tuvo que dar el salto a un nuevo factor de forma.

Esa evolución dio lugar a los DIMM (Dual In‑line Memory Module), inicialmente con 168 contactos y bus de 64 bits. Esta anchura permitía alimentar directamente a procesadores Pentium sin necesidad de instalar módulos en pares, algo que con los SIMM era bastante habitual.

Sobre los DIMM se asentó la SDRAM síncrona, que llegó en variantes PC66, PC100 y PC133, haciendo referencia a las frecuencias de 66, 100 y 133 MHz del bus. Desde entonces, el formato DIMM ha ido evolucionando en número de pines y en las memorias que monta:

- 184 pines para DDR.

- 240 pines para DDR2 y DDR3 (no compatibles entre sí por la posición de la muesca).

- 288 pines para DDR4 y DDR5.

En portátiles y equipos compactos se utilizan versiones reducidas como los SO‑DIMM (de 144, 200, 204 o 260 contactos según la generación) y los Micro‑DIMM en algunos diseños ultra compactos. También han existido módulos propietarios como los RIMM (Rambus Inline Memory Module) o formatos específicos para servidores como los FB‑DIMM con búfer completo.

La eDRAM, en cambio, no viaja en módulos intercambiables. Va soldada dentro del propio chip, dentro del encapsulado del procesador o la GPU, de modo que el usuario final no puede ampliarla ni sustituirla: forma parte de la arquitectura fija del dispositivo.

Memoria RAM, rendimiento del sistema y papel de la eDRAM

En un ordenador o un móvil típico, la RAM principal es la encargada de almacenar temporalmente los datos de los programas que se están ejecutando. Esa es la memoria a la que se refiere la gente cuando habla de tener 8, 16 o 32 GB de RAM. Es volátil: se borra al apagar el equipo, pero su velocidad es muy superior a la de un disco duro o incluso a muchos SSD.

Cuanta más RAM tengas, más aplicaciones y más datos simultáneos puede manejar el sistema sin recurrir a la memoria de intercambio del disco, que es mucho más lenta. Por eso añadir RAM convencional es una forma muy simple y rentable de mejorar el rendimiento percibido de un PC que va justo de memoria.

La eDRAM no sustituye a esta RAM general, pero sí puede hacer de “turbo” local para ciertos componentes. Por ejemplo, una GPU integrada con un bloque de eDRAM puede mantener texturas, framebuffers y datos intermedios en una memoria muchísimo más rápida que la DDR del sistema, aliviando el cuello de botella del bus de memoria.

En procesadores de servidor o de escritorio avanzados, grandes cachés L3 o L4 implementadas en eDRAM reducen drásticamente la frecuencia con la que la CPU tiene que ir a buscar datos a la RAM externa. Eso se traduce en menos latencia y más rendimiento efectivo por ciclo de reloj, algo especialmente crítico en cargas de trabajo de bases de datos, big data o IA.

En resumen, la combinación típica que vemos hoy en día es: SRAM para las cachés más rápidas, eDRAM para memoria intermedia muy densa y DRAM externa como memoria principal. Cada nivel tiene su función dentro de la jerarquía de memoria.

IA, centros de datos y la explosión de la demanda de DRAM

El auge de la Inteligencia Artificial generativa y los grandes centros de datos ha cambiado totalmente el panorama del mercado de memorias. Entrenar y desplegar modelos masivos requiere servidores llenos de DRAM, HBM y distintos tipos de memoria rápida, y los inversores se han lanzado de cabeza a cualquier empresa que fabrique estos componentes.

Fabricantes de memorias como Micron, Samsung, SK Hynix, Nanya o Sandisk están viviendo un rally bursátil precisamente por esa expectativa de demanda brutal para 2025 y 2026. La previsión es que segmentos como la DRAM para centros de datos, la HBM (High Bandwidth Memory) y las NAND de alta densidad estén prácticamente comprometidos por adelantado.

En ese contexto, compañías como Micron han decidido volcarse en la memoria para IA, reduciendo su presencia en memorias de consumo para PCs domésticos, y enfocándose en soluciones de alto rendimiento con márgenes mucho más jugosos. Los analistas esperan que su beneficio se multiplique varias veces en pocos años si se cumplen las previsiones de ventas de DRAM de nueva generación.

Samsung, por su parte, mantiene un papel de gigante diversificado: fuerte en memorias DRAM, en NAND y también en productos de consumo. El repunte en los precios de DRAM y NAND, que en algunos trimestres se ha cifrado en subidas de en torno al 40% intertrimestral, está empujando con fuerza sus resultados financieros.

Esta presión de demanda tiene una consecuencia directa para el usuario final: subida de precios y posible escasez en memorias DDR5, LPDDR para móviles, chips de SSD y, en general, cualquier componente que compita por las mismas líneas de fabricación que las memorias de alto ancho de banda para IA. Se ha visto ya un aumento de entre el 30 % y el 60 % en los precios de ciertos tipos de RAM y NAND, y se espera que parte de ese efecto continúe.

En este ecosistema, la eDRAM no suele venderse como producto separado, pero forma parte de muchos de esos chips avanzados para IA, centros de datos y gráficos de alto nivel. A medida que los diseños apuestan por acercar la memoria al cálculo para reducir consumos y latencias, el uso de memorias embebidas densas cobra cada vez más sentido.

Fiabilidad, ECC y memoria registrada en sistemas críticos

Cuando hablamos de servidores, estaciones de trabajo o equipos que no se pueden permitir errores silenciosos en la memoria, entran en juego soluciones como la RAM con paridad y la RAM con ECC (Error Correcting Code). Estas variantes añaden bits extra por cada palabra de datos para poder detectar e incluso corregir errores provocados por fenómenos como partículas cósmicas o pequeñas perturbaciones eléctricas.

La RAM con paridad se limita a detectar errores: si los bits no cuadran con la paridad esperada, se avisa y normalmente el sistema genera una parada o una excepción. La RAM ECC, en cambio, puede corregir errores de un solo bit y detectar errores de varios bits, permitiendo que el sistema continúe funcionando mientras registra el incidente.

En servidores también se utilizan módulos llamados registrados (registered) o con búfer. Estos módulos incorporan chips adicionales que repiten y acondicionan las señales de dirección y control, de modo que el controlador de memoria no tiene que “cargar” directamente con muchos módulos en paralelo. Eso permite montar más memoria total y de mayor capacidad sin degradar tanto la señal.

La contrapartida es que la memoria registrada introduce un ciclo de latencia extra y encarece los módulos, por lo que no se suele usar en PCs domésticos. Para aprovechar estas funciones, tanto la placa base como el controlador de memoria deben ser compatibles, y en muchos equipos de consumo ese soporte simplemente no existe.

La eDRAM, al estar integrada en el propio chip, suele gestionarse con mecanismos internos de fiabilidad y corrección, y en sistemas de misión crítica se combina con memoria externa ECC y módulos registrados para tener una cadena completa de protección desde los registros de la CPU hasta la DRAM off‑chip.

Jerarquía de memoria y papel de la eDRAM hoy

Si visualizamos la jerarquía de memoria de un sistema moderno desde la CPU hacia fuera, tenemos algo así: registros del procesador, cachés SRAM (L1, L2, L3), posibles caches o buffers en eDRAM, RAM externa (DDR, HBM…) y, finalmente, almacenamiento persistente (SSD, disco duro, etc.). Cada nivel es más lento y más grande que el anterior.

La eDRAM ocupa ese hueco intermedio en el que se necesita mucha capacidad y un rendimiento muy alto, pero sin llegar al coste por bit de la SRAM. Aunque no la veas ni puedas comprarla suelta, está ahí dentro ayudando a que tu consola dibuje escenas complejas, a que un procesador de servidor gestione enormes bases de datos o a que una GPU especializada en IA mueva montañas de tensores por segundo.

El futuro inmediato apunta a combinar cada vez más memorias embebidas, HBM apilada en 3D y DRAM externa de alta velocidad para satisfacer esa sed de ancho de banda de la IA, los gráficos y el cómputo científico. En ese puzzle, la eDRAM seguirá siendo una de las piezas discretas pero fundamentales que permiten acercar la memoria al cálculo sin arruinar el presupuesto de silicio.

Entender qué es la eDRAM y cómo se relaciona con el resto de la familia RAM ayuda a poner en perspectiva por qué no todo se soluciona “poniendo más gigas”, y por qué los fabricantes se dejan tanto dinero y esfuerzo en integrar memoria cada vez más cerca del procesador para exprimir el rendimiento donde de verdad importa.