- Trainium3 y sus UltraServers ofrecen hasta 4,4 veces más rendimiento, cuatro veces más memoria y un 40 % más eficiencia energética que la generación anterior, con capacidad de escalar hasta un millón de chips.

- AWS integra Trainium3 en su ecosistema de IA con Amazon Bedrock y AgentCore, combinando aceleradores propios, modelos open weight y agentes corporativos con control, memoria y evaluación avanzada.

- La hoja de ruta con Trainium4, compatible con NVLink Fusion de Nvidia y el ecosistema CUDA, busca atraer cargas de trabajo ya estandarizadas en GPU Nvidia hacia una nube híbrida y más competitiva en costes.

La irrupción de Amazon Trainium3 en la carrera de chips de inteligencia artificial marca un punto de inflexión en la estrategia de AWS para dominar la nube de próxima generación. No se trata solo de más potencia bruta: Amazon está moviendo ficha con silicio propio, acuerdos estratégicos y una plataforma de agentes de IA pensada para empresas que quieren ir muy en serio con la automatización.

Mientras Nvidia sigue liderando el mercado de GPU y gigantes como Google o Microsoft apuestan por sus propios aceleradores, AWS ha decidido redoblar la apuesta con Trainium3, su sistema UltraServer asociado y la hoja de ruta de Trainium4. Todo ello encaja con una visión clara: ofrecer cómputo de IA más rápido, más barato y con menor consumo energético, sin obligar a renunciar al ecosistema CUDA ni a las herramientas más extendidas de la industria.

Amazon Trainium: del primer chip a la tercera generación

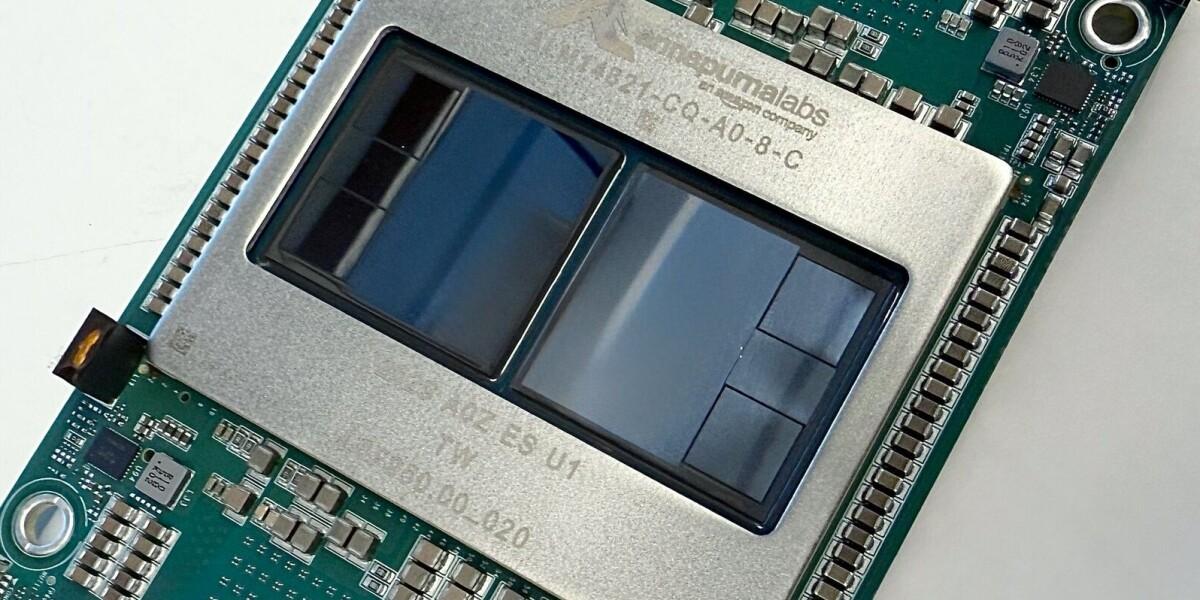

Antes de entender qué aporta Trainium3 dentro del ecosistema de AWS, merece la pena repasar de dónde viene esta familia de chips. AWS lleva años diseñando aceleradores específicos para IA con un objetivo muy concreto: recortar costes frente a las GPU tradicionales y controlar mejor su propia cadena de suministro.

El primer chip AWS Trainium impulsó las instancias Trn1 de Amazon EC2, centradas en entrenamiento de modelos. Estas instancias prometían hasta un 50 % de ahorro frente a alternativas equivalentes, y compañías como Databricks, Ricoh, NinjaTech AI o Arcee AI empezaron a aprovechar esa combinación de precio y rendimiento para entrenar modelos de lenguaje, sistemas de recomendación o aplicaciones de IA generativa.

La segunda generación llegó con AWS Trainium2, base de las instancias Trn2 de EC2. Aquí el salto fue mucho más agresivo: hasta cuatro veces más rendimiento que el Trainium original y una mejora de precio-rendimiento de entre el 30 % y el 40 % respecto a instancias GPU de la gama P5e y P5en. Estas Trn2 se diseñaron con la IA generativa como prioridad, abarcando modelos de lenguaje de gran tamaño, redes multimodales y arquitecturas de difusión para imágenes y vídeos.

Un elemento clave de Trainium2 fue la interconexión NeuronLink, el sistema propietario de AWS para unir chips dentro de un mismo nodo. Gracias a esta tecnología, los UltraServers Trn2 (una oferta nueva de EC2, inicialmente en vista previa) podían juntar 64 chips Trainium2 repartidos en cuatro instancias Trn2, ofreciendo más memoria y ancho de banda para los modelos más exigentes.

Esta arquitectura permitía mejorar tanto la inferencia como el entrenamiento: en inferencia, tiempos de respuesta muy ajustados para experiencias en tiempo real; en entrenamiento, comunicación colectiva más rápida para paralelizar modelos gigantes sin sufrir tanto los cuellos de botella habituales de red.

Todo este camino ha desembocado en Trainium3, la tercera generación de aceleradores de IA de Amazon, diseñada ya no solo para competir, sino para escalar a cifras de cómputo que hace unos años sonarían a ciencia ficción.

Trainium3 y UltraServers: arquitectura de 3 nm y salto masivo de rendimiento

En el evento AWS re:Invent 2025, la compañía presentó oficialmente el chip Trainium3 y los nuevos sistemas Trainium3 UltraServer (también llamados Trn3 UltraServers en algunas comunicaciones). Es la primera generación fabricada con tecnología de proceso de 3 nanómetros, lo que permite más densidad de transistores, mejor consumo y mayor rendimiento por vatio.

Estos UltraServers se han construido alrededor de Trainium3 y de la red interna de alta velocidad propia de Amazon. Esta combinación hace posible mover datos entre chips y servidores con una latencia muy baja, algo fundamental cuando se entrenan modelos gigantescos o se sirven millones de peticiones de inferencia simultáneamente.

AWS asegura que, respecto a la generación anterior basada en Trainium2, los servidores con Trainium3 ofrecen más de cuatro veces el rendimiento de cómputo y cuatro veces la memoria disponible. En algunos comunicados se habla incluso de hasta 4,4 veces más rendimiento de cómputo y casi cuatro veces más ancho de banda de memoria, lo que encaja con las necesidades de los modelos de lenguaje de gran tamaño (LLM) actuales, que son cada vez más hambrientos de memoria.

Cada sistema UltraServer integra 144 chips Trainium3 en un único chasis. Esta densidad de aceleradores por servidor permite alcanzar cientos de petaFLOPS en precisión FP8, ideal para entrenamiento de IA generativa a gran escala y despliegues de inferencia de alto volumen. Menos servidores para la misma potencia implica también simplificar la gestión de racks, alimentación y refrigeración en los centros de datos.

Además, estos UltraServers se pueden conectar entre sí a gran escala. AWS afirma que es posible agrupar miles de unidades hasta llegar a configuraciones con un máximo de un millón de chips Trainium3 trabajando en paralelo, multiplicando por diez la capacidad máxima que ofrecía la generación previa de Trainium2. Con esta escala, se abren las puertas a proyectos de IA empresarial de una magnitud enorme, desde asistentes multimodales globales hasta simulaciones científicas masivas.

Eficiencia energética, costes y contexto de la guerra de chips de IA

El rendimiento no es el único argumento de Trainium3. AWS insiste en que esta generación es un 40 % más eficiente en consumo energético que la anterior. En un momento en el que los centros de datos de IA están tensando las redes eléctricas en varios países, esta mejora es cualquier cosa menos un detalle.

Los centros de datos de AWS ya estaban inmersos en una expansión gigantesca: la compañía había hecho pública una inversión de 50.000 millones de dólares para aumentar su capacidad de cómputo, incluyendo la construcción de unos 1,3 gigavatios adicionales en centros de datos federales dedicados a IA y servicios de alto rendimiento. Reducir el consumo por unidad de cómputo ayuda directamente a contener la factura energética y la huella ambiental.

En paralelo, Amazon mantiene su reputación de obsesión por la reducción de costes. La compañía destaca que los clientes que ya están utilizando Trainium3 han logrado recortar de forma notable los gastos asociados tanto al entrenamiento como a la inferencia. Se mencionan casos donde la reducción de costes de entrenamiento llega a ser de hasta un 50 % frente a determinadas alternativas basadas en GPU.

El lanzamiento de Trainium3 se produce, además, en un contexto de competencia feroz en el hardware de IA. Alphabet y Microsoft también han avanzado en la creación de chips propios, mientras Nvidia mantiene un dominio muy sólido gracias a su gama de GPU y al ecosistema CUDA que las rodea. Amazon quiere jugar en esa misma liga, pero con un ángulo diferencial: combinar chips propios con una infraestructura de nube madura, acuerdos con grandes socios y compatibilidad con las herramientas ya consolidadas del sector.

El mercado bursátil observa esta carrera con cierta cautela, con analistas advirtiendo sobre una posible burbuja en torno a la IA. Aun así, AWS ve en Trainium3 y en sus futuras generaciones una palanca clave para consolidar su liderazgo en servicios de IA en la nube y reducir su dependencia de proveedores externos como Nvidia.

Primeros clientes, uso real y casos de éxito

Los nuevos sistemas de Amazon no se han quedado en papel: clientes reales ya están sacando partido a Trainium3. Entre los primeros usuarios destacan nombres como Anthropic, la firma japonesa de modelos de lenguaje Karakuri, SplashMusic y Decart, además de otras empresas tecnológicas, startups de IA y laboratorios de investigación.

Estas organizaciones han usado Trainium3 para abaratar la inferencia y acelerar el entrenamiento de sus modelos. En servicios que procesan millones de consultas diarias (chatbots, asistentes virtuales, motores de recomendación o sistemas de análisis on-chain), cada céntimo de reducción en el coste por petición puede marcar la diferencia entre un negocio viable y uno insostenible.

En sectores como criptoactivos, blockchain o trading algorítmico, donde se requieren modelos capaces de analizar enormes volúmenes de datos en tiempo real, la combinación de mayor potencia y menor coste operativo es especialmente atractiva. Trainium3 promete entrenar modelos de predicción, gestión de riesgo o análisis de sentimiento de mercado más rápido y con una factura energética menor.

Además, Amazon Bedrock, el servicio gestionado de modelos fundacionales de AWS, ya está sirviendo cargas de trabajo en producción sobre Trainium3. Este detalle es importante porque demuestra que la nueva generación de chips no es solo una apuesta a futuro, sino una pieza lista para usos empresariales críticos, con soporte de la propia plataforma de AWS.

Clientes como Anthropic, Metagenomi, NetoAI, Ricoh o Splash Music han reportado reducciones en los costes de entrenamiento de hasta un 50 % al migrar determinadas cargas de trabajo de GPU tradicionales a instancias basadas en Trainium, reforzando la narrativa de que el silicio de Amazon es una alternativa real, y no solo un experimento interno.

Bedrock, modelos abiertos y el papel de Trainium3 como acelerador nativo

El anuncio de Trainium3 llegó acompañado de una gran ampliación del catálogo de modelos open weight totalmente gestionados en Amazon Bedrock. La plataforma sumó 18 modelos abiertos adicionales, el mayor salto de su historia, incluyendo Mistral Large 3 y la familia Ministral 3 (3B, 8B y 14B parámetros), junto con propuestas de Google, Moonshot AI, MiniMax AI, Nvidia, OpenAI y Qwen, entre otros.

Con esta estrategia, AWS quiere posicionarse como un auténtico hub de modelos de IA, donde las empresas puedan probar diferentes opciones, compararlas y cambiarlas sin tener que reconstruir sus aplicaciones cada vez. Trainium3 actúa como acelerador nativo más potente de Bedrock, con hasta tres veces más rendimiento que la generación anterior en la ejecución de estos modelos.

Esta integración entre hardware optimizado y plataforma de modelos gestionados resulta atractiva para compañías que no quieren pelearse con la complejidad de desplegar y orquestar modelos por su cuenta. La idea es clara: que los clientes se centren en el negocio mientras AWS se encarga de la infraestructura subyacente, aprovechando la eficiencia de Trainium3 para mejorar tiempos de respuesta y costes.

En este contexto, el lanzamiento de Trainium3 encaja también con la estrategia de AWS de reducir la dependencia de GPU externas manteniendo, al mismo tiempo, una puerta abierta a integrarse con el hardware de Nvidia en futuras generaciones de chips.

AgentCore y los nuevos agentes corporativos de AWS

La apuesta de Amazon por la IA no se limita al hardware. Paralelamente, la compañía ha potenciado Amazon Bedrock AgentCore, su plataforma para construir agentes de IA con comportamiento autónomo orientados a entornos empresariales.

AgentCore incorpora una función llamada Policy, pensada para definir límites de actuación usando lenguaje natural. Estas políticas marcan qué puede hacer un agente, a qué datos tiene acceso, cuándo debe solicitar intervención humana o qué acciones están vetadas por completo. Se integran con AgentCore Gateway para bloquear automáticamente acciones que incumplan las directrices, incluyendo interacciones con herramientas externas como Salesforce, Slack u otros servicios críticos.

La segunda pieza clave es AgentCore Memory, una capa de memoria contextual que permite a los agentes almacenar información relevante de cada usuario: preferencias, historial de uso, hábitos de compra o criterios de viaje, por ejemplo. Con ello, las decisiones futuras del agente se adaptan mejor a cada contexto, aumentando la sensación de personalización y la autonomía en tareas repetitivas.

El tercer componente, AgentCore Evaluations, añade 13 sistemas de evaluación preconfigurados que permiten auditar aspectos como la seguridad, la precisión de las respuestas, el uso correcto de herramientas externas o el cumplimiento de políticas internas. De esta forma, los equipos técnicos pueden monitorizar de manera continua la calidad de los agentes sin necesidad de desarrollar desde cero sus propios frameworks de evaluación.

Según David Richardson, vicepresidente de AgentCore, esta capa de evaluaciones ayuda a abordar los mayores miedos de las empresas a la hora de desplegar agentes autónomos, especialmente en sectores regulados o que manejan información muy sensible. Todo esto se apoya, evidentemente, en la infraestructura de cómputo que chips como Trainium3 hacen posible.

Alianzas estratégicas y refuerzo del ecosistema de IA de AWS

Al mismo tiempo que presentaba Trainium3, AWS aprovechó para anunciar acuerdos relevantes con grandes compañías que refuerzan su posición en el mercado de la nube y la IA. Uno de los más llamativos es el de BlackRock, que alojará su plataforma de gestión de inversiones Aladdin en AWS, consolidando a la nube de Amazon como pilar para aplicaciones financieras de misión crítica.

Nissan, por su parte, adoptará una nueva infraestructura en la nube de AWS para acelerar el desarrollo de vehículos definidos por software, un campo donde la IA y el análisis de datos son fundamentales para funciones avanzadas de conducción, mantenimiento predictivo o experiencia personalizada a bordo.

Además, Visa colaborará con Amazon para desarrollar soluciones de pago más seguras basadas en agentes de IA, integrando capacidades de detección de fraude, análisis de patrones de gasto y autenticación inteligente dentro de flujos de pago globales.

En el plano más horizontal, AWS ha ampliado su programa AWS AI Competency Partners con tres nuevas categorías centradas en IA agéntica. De este modo, reconoce a socios especializados en el desarrollo de aplicaciones autónomas para empresas, reforzando un ecosistema donde integradores y desarrolladores pueden construir soluciones complejas sobre la base de Trainium, AgentCore y Bedrock.

También se han introducido novedades en AWS Marketplace, que ahora incorpora herramientas impulsadas por IA para mejorar la búsqueda de productos, crear ofertas adaptadas y desplegar soluciones modulares. Y Amazon Connect, el servicio de contact center en la nube, ha sumado 29 nuevas funciones centradas en agentes autónomos, asistencia en tiempo real y analítica predictiva, apuntalando la visión de automatizar gran parte de la experiencia de atención al cliente.

Trainium4: interoperabilidad con Nvidia y NVLink Fusion

Aunque Trainium3 es el protagonista del momento, AWS no ha perdido la oportunidad de avanzar detalles de Trainium4, la siguiente generación de su chip de IA. Aún sin fecha concreta de lanzamiento, la compañía ha confirmado que este futuro procesador ofrecerá un nuevo salto de rendimiento y, lo más llamativo, será compatible con NVLink Fusion, la tecnología de interconexión de alta velocidad de Nvidia.

NVLink Fusion es clave para el ecosistema Nvidia porque permite conectar múltiples GPU con altísimo ancho de banda y latencias muy reducidas. Al incorporar compatibilidad con esta tecnología, AWS prepara el terreno para racks donde chips Trainium4 y GPU Nvidia puedan trabajar juntos dentro de la misma infraestructura.

Esta interoperabilidad tiene un objetivo muy claro: atraer a desarrolladores y empresas que ya se han estandarizado en CUDA, el estándar de facto de la computación de IA moderna. En lugar de obligarlos a reescribir todo su software para adaptarse a Trainium, la idea es ofrecer una arquitectura híbrida donde las cargas de trabajo puedan repartirse entre aceleradores de Amazon y GPU Nvidia sin perder acceso a bibliotecas y herramientas conocidas.

En la práctica, esto permitirá que aplicaciones diseñadas inicialmente para GPU Nvidia puedan migrar o extenderse con mayor facilidad a la nube de AWS, combinando el ecosistema CUDA con la infraestructura de menor coste desarrollada por Amazon. Para la propia AWS, es también una manera de seguir recortando dependencia de terceros, al tiempo que mantiene una relación de colaboración selectiva con Nvidia.

Siguiendo los patrones de lanzamientos anteriores, es razonable pensar que se conocerán más detalles de Trainium4 en futuras ediciones de re:Invent, aunque Amazon se guarda margen para ajustar especificaciones y calendario según evolucione el mercado y la competencia.

Todo este movimiento en torno a Trainium3, los UltraServers, AgentCore y la hoja de ruta de Trainium4 dibuja un escenario en el que AWS quiere ser mucho más que un proveedor de infraestructura básica. Su apuesta combina chips diseñados a medida, un ecosistema de modelos y agentes gestionados, alianzas con grandes nombres de la industria y una estrategia clara para convivir —y competir— con Nvidia y otros gigantes. Para empresas de cualquier tamaño, desde startups de IA hasta bancos globales o actores del mundo cripto, esto se traduce en más opciones para acceder a cómputo de IA de alta gama, con mejor equilibrio entre rendimiento, coste y eficiencia energética en una industria que no deja de acelerar.