- Raspberry Pi 5 aporta potencia, conectividad y ecosistema para asistentes de voz y visión con baja latencia.

- El AI Kit con Hailo‑8L (13 TOPS) y M.2 HAT+ acelera inferencias e integra software vía apt en Raspberry Pi OS.

- Arquitectura típica: wake word, STT (Vosk/faster‑whisper), NLP local o remoto y TTS; control total de privacidad.

- Casos reales: ASRAI en Pi 4 con array de micrófonos económico y agente 100% local en Pi 5 con modelos compactos.

Convertir una Raspberry Pi en el cerebro de un asistente de voz es ya un planazo realista y asequible: con una pequeña placa, unos cuantos sensores y el software adecuado puedes tener un sistema que te entienda, responda y automatice tu casa sin depender de la nube. En los últimos años han surgido proyectos y kits que facilitan muchísimo este proceso, y con la Raspberry Pi 5 el salto de potencia se nota tanto que apetece meterse de lleno. En este artículo vas a encontrar una guía amplia que une el hardware, el software, ejemplos prácticos y consideraciones de seguridad para que no se te escape nada y puedas crear un asistente funcional de principio a fin, con información contrastada de varios proyectos reales y del ecosistema oficial.

Además de explicarte las opciones que tienes para ejecutar IA en local —incluyendo aceleradores dedicados—, vas a conocer cómo estructurar un asistente: desde la detección por voz, al reconocimiento del habla y la generación de respuestas, pasando por la conexión con otros dispositivos y la ejecución de acciones. También repasaremos un par de casos muy inspiradores: uno que usa una Raspberry Pi 4 con un sistema de micrófonos integrado en una cámara económica, y otro que exprime una Raspberry Pi 5 de 16 GB para correr modelos pequeños completamente en local. Todo ello con un toque práctico y sin perder de vista la privacidad, el consumo y la seguridad.

¿Por qué construir un asistente de IA con Raspberry Pi?

La Raspberry Pi es una placa diminuta pero matona que te permite crear desde centros multimedia hasta robots autónomos, y un asistente de voz es uno de los proyectos más agradecidos. En su quinta generación, la Raspberry Pi 5 ofrece un salto de rendimiento significativo, con un procesador ARM Cortex-A76 a 2,4 GHz y opciones de memoria que llegan hasta 8 GB de RAM LPDDR4X. Esta combinación abre la puerta a tareas exigentes, como el reconocimiento de voz, la visión por computador o la ejecución de modelos de lenguaje compactos, todo ello con un consumo bajo y sin necesidad de hardware de sobremesa ni servidores externos.

La conectividad también viene muy bien servida: Wi‑Fi 5, Bluetooth 5.0/BLE y un montón de pines GPIO para integrar sensores. En el apartado multimedia, los dos puertos micro‑HDMI capaces de 4K a 60 Hz permiten conectar pantallas para depurar, mostrar paneles de control o diseñar interfaces visuales de tu asistente. En resumen, se trata de una plataforma flexible para aprender y crear: puedes programar en Python, Java o C++, trastear con bases de datos y redes, y jugar con bibliotecas de IA y audio, todo ello con una comunidad enorme detrás y una curva de entrada amistosa para experimentar desde el primer día.

Si te atrae la idea de construir un asistente a tu medida, no estás solo: hay aficionados que han montado soluciones totalmente funcionales con micrófonos de array, pantallas pequeñas para feedback visual, y software que trabaja offline o se conecta a un modelo mayor en otra máquina. La gracia de hacerlo en Raspberry Pi es que tienes un control fino sobre la privacidad, la personalización y la integración con tu casa conectada, en lugar de depender de una caja negra. Y si te preocupa la complejidad, verás que con unas cuantas piezas bien elegidas y guías claras puedes lograr resultados sorprendentes con muy poca inversión y un aprendizaje enorme por el camino.

Raspberry Pi 5: la base de hardware y lo que puedes esperar

A nivel de especificaciones, la Raspberry Pi 5 es una microcomputadora completa que adelgaza el concepto PC al mínimo: CPU ARM Cortex‑A76 de cuatro núcleos a 2,4 GHz, hasta 8 GB de RAM LPDDR4X, conectividad Wi‑Fi 5 y Bluetooth 5.0/BLE, y dos salidas micro‑HDMI con soporte 4K@60. Esto se nota cuando ejecutas varias tareas de audio y visión a la vez: puedes escuchar al usuario, transcribir, interpretar la intención y lanzar acciones sin desfallecer. Y si prefieres usarla con pantalla, tienes potencia para mostrar interfaces ricas, con gráficos o dashboards, manteniendo la latencia del asistente en márgenes cómodos.

La placa brilla también por su ecosistema: sistemas operativos completos basados en Linux, herramientas de desarrollo bien empaquetadas y documentación abundante. Puedes arrancar con Raspberry Pi OS (incluida su variante Lite si quieres ahorrar recursos) y sumar bibliotecas específicas de audio, IA y control de periféricos. Al no estar atado a un proveedor, decides qué se ejecuta en local, qué se externaliza y cómo se guardan los datos. Eso, para un asistente que escucha y habla, es clave: privacidad y control total sobre el flujo de información.

En cuanto a expansión, los pines GPIO y las interfaces de la Pi 5 (como PCIe) te permiten conectar desde micrófonos y cámaras hasta aceleradores de IA. Con la placa adecuada, puedes añadir una unidad de procesamiento neuronal (NPU) que descargue la parte pesada del cálculo, liberando la CPU para el resto de tareas. Esto se traduce en asistentes que sienten y responden más rápido, consumen menos y funcionan bien incluso con modelos de visión y audio más ambiciosos, manteniendo un equilibrio de rendimiento y eficiencia muy difícil de conseguir con hardware genérico.

Aceleración con AI Kit de Raspberry Pi: Hailo-8L y M.2 HAT+

Si quieres darle un empujón serio a la inteligencia artificial en la Pi 5, existe un kit oficial que simplifica la integración: una M.2 HAT+ con una tarjeta M.2 2242 que incorpora el procesador Hailo‑8L. Esta NPU alcanza hasta 13 TOPS, lo que significa que puedes ejecutar inferencias exigentes (especialmente visión y modelos optimizados) directamente en la placa, con latencias muy contenidas. La tarjeta viene con su disipación adecuada y un pequeño cable plano para enlazar con la interfaz PCI Express de la Raspberry Pi 5, de modo que el montaje es limpio y la experiencia, casi plug‑and‑play para un proyecto de IA doméstico.

El paquete incluye todo lo necesario para instalarlo: M.2 HAT+, la placa M.2 2242 con el chip Hailo‑8L, almohadilla térmica preinstalada, kit de montaje con espaciadores y tornillos, y un conector GPIO apilable de 16 mm por si necesitas mantener otros accesorios. A nivel de software también está muy cuidado: el dispositivo Hailo se integra con el entorno de Raspberry Pi OS y herramientas como libcamera, rpicam‑apps y picamera2. Los controladores y SDK (Hailo drivers, HailoRT y HailoTappas) se instalan desde apt, por lo que no tienes que compilar nada raro ni pelearte con dependencias crípticas, lo que acorta muchísimo el tiempo entre “abrir la caja” y “ver el modelo funcionando”.

Este AI Kit es el primero de una familia de accesorios orientados a IA dentro del ecosistema oficial de la Raspberry Pi. Su objetivo es ofrecer una vía eficiente y de bajo consumo para llevar IA de alto rendimiento al borde, justo donde están tus sensores. Hay tiendas que lo ofertan con variaciones de disponibilidad (por ejemplo, “producto disponible con otras opciones”) y con secciones de consultas para clientes. Más allá del detalle comercial, lo relevante es que la solución te da una base sólida para ejecutar tareas como detección de objetos, clasificación o seguimiento con cámaras compatibles, integrando la inferencia acelerada con la captura nativa de la Pi y los marcos de cámara más populares.

Cómo funciona un asistente inteligente: piezas y flujo de datos

Un asistente de voz moderno en Raspberry Pi suele organizarse en varios bloques que colaboran. Primero, el hardware: una Pi 5 (o una 4 si ajustas expectativas), micrófonos —idealmente en arreglo para mejorar la captación—, y una cámara si quieres capacidades de visión. Segundo, la conectividad: Wi‑Fi y Bluetooth para hablar con otros dispositivos de tu hogar o de tu red. Y por último, el software: desde la detección de palabra de activación hasta la comprensión del lenguaje y la síntesis de voz. Todos estos componentes deben coordinarse con baja latencia y fiabilidad, para que la experiencia sea natural, rápida y sin “lag” incómodo.

En el reconocimiento de voz tienes varias rutas. Bibliotecas como Google Speech Recognition o PocketSphinx llevan años siendo populares; también puedes optar por motores que funcionen completamente en local como Vosk, que es una opción muy valorada cuando priorizas privacidad y no quieres depender de internet. Para la transcripción más precisa o rápida en la Pi 5 se está usando mucho faster‑whisper (una implementación optimizada de Whisper), que rinde mejor en dispositivos modestos y ofrece resultados competitivos. Combinando estas piezas, puedes escuchar, transcribir y entender al usuario con tiempos de respuesta muy decentes.

Después llega el análisis semántico o NLP: el sistema interpreta la intención (“enciende la luz del salón”, “¿qué tiempo hace?”, “toca música”) y decide qué acción ejecutar. Puedes resolverlo con reglas simples en Python o apoyarte en un modelo de lenguaje mayor, ya sea en la propia Raspberry Pi (si es pequeño) o alojado en otro equipo accesible por API. Para hablar de vuelta, motores TTS como pyttsx3 resuelven la síntesis de voz sin depender de servicios externos, manteniendo todo el flujo on‑device si así lo prefieres.

Finalmente, la ejecución de comandos: el asistente traduce la intención en acciones reales. Puede encender enchufes, enviar mensajes, consultar servicios web o mover un robot conectado por GPIO. Esa capa es donde más se personaliza: al fin y al cabo, tu asistente es tuyo y se tiene que llevar bien con tu ecosistema (Home Assistant, MQTT, dispositivos Bluetooth, etc.). La clave es orquestar el pipeline de manera robusta: detección de activación, escucha, transcripción, comprensión, respuesta y acción, incluyendo reintentos y gestión de errores para no romper la interacción.

Proyectos reales que inspiran: de ASRAI en Pi 4 a un agente completo en Pi 5

Entre los proyectos DIY más curiosos destaca ASRAI, construido sobre una Raspberry Pi 4 Modelo B con una cámara Sony PlayStation Eye y una pequeña pantalla GPIO de 3,5 pulgadas. La gracia de la PlayStation Eye es que incorpora un array de cuatro micrófonos fácil de extraer e integrar en la Pi, y además es baratísima en el mercado de segunda mano (ronda los 4 dólares). Este montaje crea un asistente de voz con una interfaz visual mínima y una captación de audio muy apañada, ideal cuando quieres escuchar bien desde distintos puntos de la habitación sin gastar un dineral.

En cuanto al software, ASRAI sigue un enfoque parecido al de otros sistemas de éxito como Rhasspy: usa Vosk localmente para reconocimiento de voz y se conecta a un modelo de lenguaje alojado en otro ordenador mediante una API compatible con OpenAI, utilizando Ollama como capa de servicio. Gracias a Meshnet de NordVPN, el creador puede acceder a esa API desde cualquier sitio y mantener la comunicación segura. Para rematar, añadió imágenes de “durmiendo” y “escuchando” para la pantalla, y dejó el proyecto abierto para que cualquiera pueda ajustar esos detalles, con la advertencia de que conviene tener una impresora 3D y un soldador a mano para el montaje, lo cual aporta un acabado más pulido al conjunto.

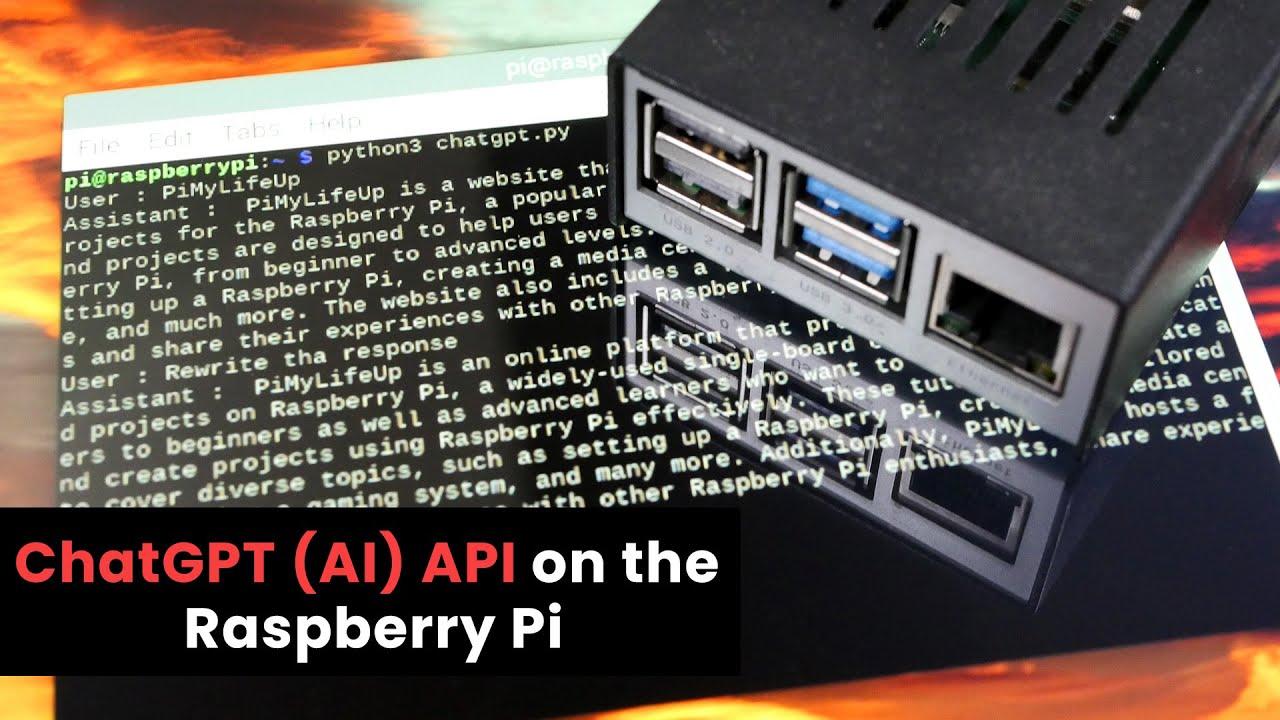

En la otra orilla, ya en Raspberry Pi 5 con 16 GB, hay quien ha ido a por todas y ha logrado que todo el pipeline corra en la propia placa: detección de palabra clave con Vosk, transcripción con faster‑whisper y la inferencia de LLM con modelos compactos como Qwen3:1.7b y Gemma3:1b. Es un reto técnico por las limitaciones de memoria y cómputo, pero demuestran que, con ingeniería cuidadosa y modelos bien elegidos, se puede tener un asistente completo 100% local. Ese tipo de configuraciones brillan en privacidad —nada sale de tu red— y en control, ya que puedes ajustar tiempos de espera, vocabularios y hasta “personalidades” del asistente con facilidad.

Otros creadores han ido documentando sus aventuras convirtiendo una Raspberry Pi en asistente de IA y probando la potencia de la Pi 5 con diferentes modelos y cargas. La conclusión más repetida es que la Pi 5 expande el margen para ejecutar en local sin sacrificar demasiado la fluidez, y que, si necesitas más músculo para ciertos modelos, siempre puedes externalizar parte de la inferencia a un equipo más grande mediante una API compatible con OpenAI (por ejemplo, sirviendo modelos con Ollama), manteniendo en la Pi la orquestación y el I/O con micrófonos y altavoces, que es donde marca la diferencia tener latencias mínimas.

Puesta en marcha básica: del sistema operativo al “hola” por voz

Para una primera versión que te permita hablar con tu Raspberry Pi y recibir respuestas, el camino más directo es arrancar con Raspberry Pi OS (la edición Lite ayuda a guardar recursos si no necesitas entorno gráfico). Tras la instalación y la configuración inicial, asegúrate de actualizar paquetes y habilitar el audio. En esta fase conviene verificar el micrófono y el altavoz, ya que una buena captura y reproducción son la base de un asistente que se entienda bien contigo; una vez que suena y graba, tienes el 50% ganado y podrás centrarte en el pipeline de voz e IA sin tropiezos de hardware.

En reconocimiento de voz, instalar SpeechRecognition te permitirá prototipar rápidamente, y si quieres TTS en local, pyttsx3 es una opción sencilla y estable. Para un enfoque completamente offline, Vosk ofrece modelos para varios idiomas con buen desempeño en dispositivos modestos. En transcripción más exigente o precisa, faster‑whisper es la alternativa que mejor aprovecha la Pi 5, y con algo de optimización podrás mantener latencias bajas. Reserva un rato para afinar niveles de micrófono, supresión de ruido y palabra clave de activación para evitar falsos positivos.

La lógica del asistente en Python suele organizararse en módulos: un listener que captura audio y detecta la wake word, un transcriptor que convierte voz a texto, un intérprete que obtiene la intención (reglas o LLM) y un ejecutor que realiza la acción y genera la respuesta TTS. Empieza con casos simples (consultas de hora o control de luces), y añade manejo de errores y confirmaciones (“¿Quieres que apague el salón?”). Si optas por usar un modelo de lenguaje externo, exponerlo por una API compatible con OpenAI (como hace Ollama) hace que el código del asistente no cambie mucho, y te permite mover la parte pesada a otra máquina cuando lo veas necesario, sin renunciar a la inmediatez del I/O local.

Cuando la cámara entra en juego, la cosa se pone interesante: con picamera2 y libcamera puedes capturar vídeo y fotos de forma nativa en la Pi y, con la NPU Hailo‑8L, ejecutar inferencias de visión (detección de personas, reconocimiento de objetos, etc.) con un uso de CPU mínimo. Esto habilita funciones como mostrar quién ha llamado a la puerta o ejecutar acciones según lo que “vea” el asistente. La ventaja del AI Kit oficial es que todo se integra con el stack de Raspberry Pi OS y se instala con apt, de modo que la compatibilidad con librerías y aplicaciones es muy alta y los ejemplos se adaptan con poco esfuerzo.

Recuerda que la interfaz también cuenta: una pequeña pantalla GPIO de 3,5 pulgadas puede mostrar estados (“escuchando”, “durmiendo”, “pensando”) o resultados rápidos, y una mini “cara” en pantalla mejora la sensación de agente presente. Si te animas con la impresora 3D, las carcasas personalizadas dan un acabado profesional y ayudan a orientar los micrófonos, mientras que el soldador te permitirá dimensionar cables y asegurar conexiones limpias, lo que redunda en menos ruido eléctrico y mejor captación de voz.

Eficiencia, costes y dónde aporta valor un asistente DIY

Montar tu propio asistente no es solo un proyecto chulo: también impacta en tu día a día. Por un lado, automatizar tareas repetitivas (luces, climatización, recordatorios) ahorra tiempo y mejora la eficiencia del hogar. Por otro, las decisiones locales reducen dependencia de la nube, con el consiguiente ahorro energético y menos latencia. Además, el hardware accesible de la Raspberry Pi te permite ajustar el presupuesto sin renunciar a prestaciones: puedes empezar con una Pi 4 que tengas en el cajón y, si lo pides el cuerpo, dar el salto a Pi 5 y/o añadir una NPU más adelante, con la satisfacción de que cada euro se traduce en capacidad tangible justo donde te hace falta.

En empresas pequeñas y proyectos educativos, el combo coste‑prestaciones es difícil de igualar: licencias cero, desarrollo en lenguajes conocidos y un ecosistema con foros, tutoriales y ejemplos para aburrir. La modularidad también ayuda a “aprender haciendo”: hoy añades wake word, mañana TTS, pasado integración con una cámara y después una regla inteligente para gestionar el consumo eléctrico. Esa iteración, propia del mundo maker, hace que tu asistente evolucione con tus necesidades y te dé control absoluto sobre su comportamiento y sus datos.

Seguridad: buenas prácticas y vulnerabilidades a vigilar

Al conectar un asistente a tu red y a internet, la seguridad no es opcional. Empieza por mantener actualizado el sistema operativo y todas las librerías que uses; los parches evitan exploits conocidos y te ahorran sustos. Si expones APIs, hazlo detrás de HTTPS y con autenticación robusta, y limita el acceso a las redes estrictamente necesarias. En entornos domésticos, segmentar los dispositivos IoT en una red separada (VLAN o red de invitados) reduce el impacto si algo queda comprometido, manteniendo tu red principal a salvo de travesuras.

En el ámbito IoT, conviene estar al día de vulnerabilidades reportadas; por ejemplo, CVE‑2021‑22945 y CVE‑2021‑22946 aparecen documentadas en el contexto de dispositivos conectados y sirven de recordatorio de que la superficie de ataque existe, incluso en soluciones aparentemente sencillas. Monitoriza los registros de tu asistente, revisa los puertos abiertos y evita exponer servicios innecesarios al exterior. Y, si recurres a conexiones remotas tipo Meshnet para comunicar la Pi con otro equipo, configura claves y permisos con cabeza, porque la comodidad no debe ir en contra de la confidencialidad de tus datos y comandos.

Una última línea roja: el audio. Como tu asistente escucha, aplica políticas de retención estrictas (o directamente no guardes audio si no lo necesitas), encripta cualquier almacenamiento y evita que terceros accedan a grabaciones. La transparencia contigo mismo y con quienes conviven contigo es esencial: deja claro cuándo el dispositivo está “escuchando” y cuándo no, y documenta cómo y dónde se procesan los datos. Con estas pautas, un asistente casero puede ser tan seguro o más que uno comercial, con la ventaja de que tú controlas cada bit que entra y sale, reforzando la confianza en la tecnología que pones en tu salón.

Pequeños extras, tiendas y comunidad

Buena parte del encanto de este ecosistema es la comunidad: repositorios abiertos, guías paso a paso y foros donde resolver dudas. Muchos vendedores del AI Kit y accesorios afines incluyen secciones de preguntas de clientes para ayudarte antes y después de comprar, y es habitual encontrar opciones de producto alternativas según stock y necesidades (“disponible con otras opciones”). Echa un ojo a los hilos y proyectos publicados por creadores: ver cómo otros resolvieron el montaje de micrófonos, el diseño de carcasas o la integración con APIs te ahorra horas y te da ideas frescas para personalizar tu asistente sin reinventar la rueda.

Si te quedas con ganas de profundizar, hay artículos que exploran desde el funcionamiento de un asistente sobre Raspberry Pi 5 hasta pruebas de rendimiento con modelos y librerías distintas. Merece la pena contrastar configuraciones (por ejemplo, Vosk local frente a servicios remotos, o faster‑whisper frente a otras alternativas) y, sobre todo, valorar qué equilibrio te compensa entre latencia, precisión y consumo. Con esa visión global, decidir qué pones en local y qué dejas fuera es mucho más fácil y realista para tu caso concreto.

Montar tu propio asistente de IA con Raspberry Pi es un proyecto redondo: empiezas con un “hola” tímido y terminas con un sistema que te entiende, te ayuda y automatiza tareas del día a día; con una Pi 5 tienes músculo para procesar voz e incluso correr modelos compactos en local, y con el AI Kit de Hailo disparas las capacidades de visión y aceleras inferencias; si miras a la comunidad verás soluciones ingeniosas como ASRAI en Pi 4 con micrófonos de la PlayStation Eye, y agentes totalmente en local en Pi 5 con Vosk, faster‑whisper y modelos como Qwen3:1.7b o Gemma3:1b. Rematando con buenas prácticas de seguridad y una pizca de 3D y soldadura, acabas con un asistente a tu medida, privado y ágil, que te da control, aprendizaje y resultados prácticos por muy poco.