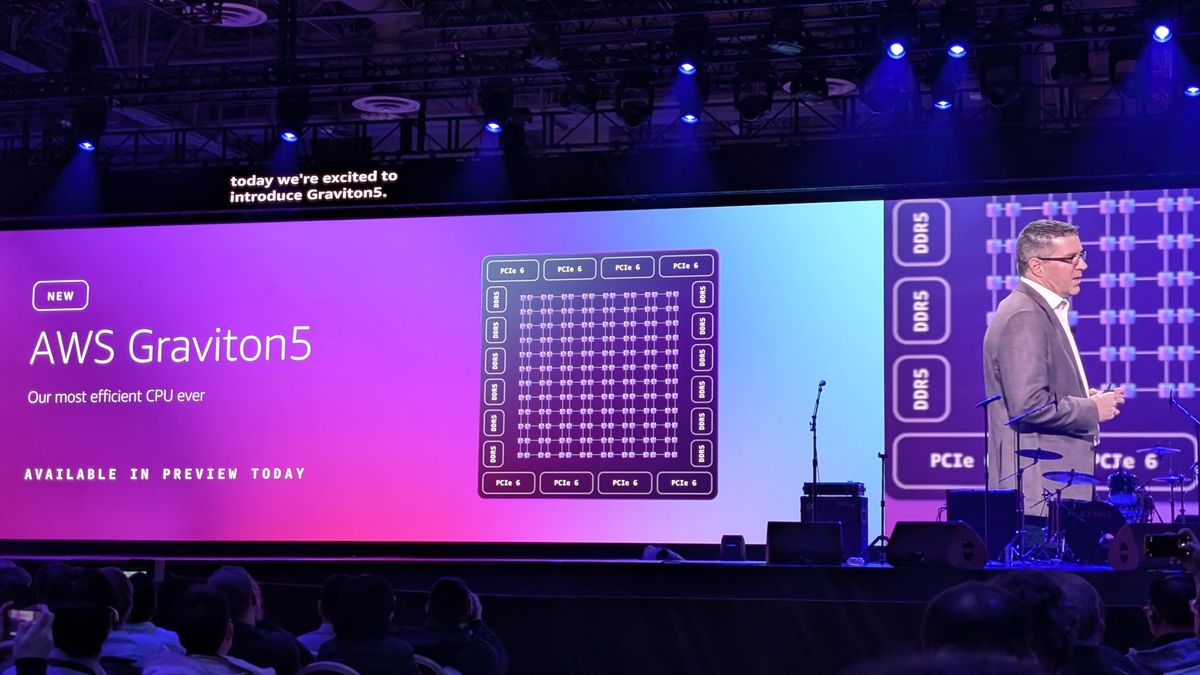

- AWS Graviton5 impulsa las instancias M9g con hasta un 25 % más de rendimiento, 192 núcleos y caché muy ampliada.

- La familia Graviton (1,2,3,4,5) ofrece chips Arm optimizados para la nube, con fuerte foco en eficiencia y coste.

- Existen instancias especializadas como G5g (GPU + Arm) y X8g (memoria intensiva), cubriendo un amplio abanico de cargas.

- La adopción masiva de Graviton y su ecosistema software consolidan estos procesadores como opción principal en AWS.

Los procesadores AWS Graviton se han convertido en la piedra angular de la estrategia de cómputo de Amazon Web Services. Con la llegada de AWS Graviton5 y las nuevas instancias EC2 M9g, la apuesta por esta línea de chips basados en arquitectura Arm se refuerza y marca un salto importante tanto en rendimiento como en eficiencia y costes para cargas de trabajo en la nube.

En los últimos años, AWS ha ido hilando una historia muy clara: construir su propia capa de hardware optimizado para la nube, desde Graviton hasta Trainium, y apoyarse en ella para todo, desde bases de datos hasta agentes de IA masivos. Más de la mitad de la nueva capacidad de CPU que entra en AWS cada año ya está impulsada por Graviton, y el 98 % de los 1.000 mayores clientes de EC2 lo utiliza de una forma u otra, lo que deja bastante claro que no es una tecnología “experimental”, sino el estándar sobre el que AWS quiere que se ejecute la próxima generación de aplicaciones.

De Graviton a Graviton5: evolución y contexto

AWS Graviton nació en 2018 durante AWS re:Invent como la primera apuesta seria de un gran hyperscaler por procesadores Arm propios para la nube. Diseñados por Annapurna Labs (división de AWS), estos chips se construyen sobre núcleos Arm Neoverse de 64 bits y están pensados específicamente para las exigencias de los centros de datos a hiperescala: alta concurrencia, gran ancho de banda de memoria y eficiencia energética muy por encima de los tradicionales x86.

Desde aquel primer chip basado en núcleos Cortex-A72, AWS ha ido lanzando nuevas generaciones: Graviton2 a finales de 2019, Graviton3 a mediados de 2022, Graviton4 para cargas de trabajo de memoria extrema y, ahora, la familia Graviton5, que impulsa las nuevas instancias Amazon EC2 M9g. En cada salto se ha reforzado la misma idea: más rendimiento por vCPU, más capacidad de memoria, mejor soporte para vectorización e IA y, sobre todo, mejor relación precio-rendimiento que las alternativas x86 equivalentes.

El procesador Graviton original ya destacaba por su enfoque en eficiencia energética, lo que ayuda a reducir la factura de infraestructura y a mejorar la sostenibilidad. Era un chip de 16 núcleos a 2,3 GHz, con unos 5.000 millones de transistores y soporte para extensiones Neon, crc y crypto, integrando aceleración hardware para AES, SHA y CRC, y un diseño de memoria NUMA pensado para escalar dentro de la infraestructura de AWS.

Con Graviton2, AWS dio un salto de gigante: más de 30.000 millones de transistores, 64 núcleos personalizados basados en Arm Neoverse N1 a 2,5 GHz, nueva ISA ARMv8.2-A con Neon mejorado, extensiones LSE, FP16, dotprod y cripto reforzada, manteniendo el enfoque NUMA. Este cambio a núcleos personalizados permitió a Annapurna Labs ajustar la microarquitectura al detalle para cargas de trabajo de la nube.

Graviton3 fue un punto de inflexión aún mayor. Con unos 55.000 millones de transistores, frecuencia de 2,6 GHz y 64 núcleos basados en Arm Neoverse-V1, introdujo ISA ARMv8.4-A con SVE de 256 bits, extensiones BF16 e INT8 para machine learning y un rediseño profundo de la microarquitectura, alcanzando hasta un 25 % más rendimiento que Graviton2, el doble de performance en coma flotante y cifrado, y hasta 3 veces más velocidad en inferencia de ML, con un 60 % más de eficiencia energética.

La generación Graviton4 se ha orientado a cargas con uso intensivo de memoria, como se ve en las instancias X8g, pensadas para bases de datos open source, cachés en memoria y EDA. Y sobre esta base evolutiva llega ahora Graviton5, que extiende la línea con más núcleos, cachés mucho más grandes y un foco claro en cargas de propósito general de alto rendimiento.

AWS Graviton5 y las nuevas instancias Amazon EC2 M9g

Las instancias Amazon EC2 M9g son la primera familia anunciada basada en AWS Graviton5. Están diseñadas como instancias de propósito general de alto rendimiento y mejor eficiencia, sustituyendo progresivamente a generaciones anteriores como M7g y M6g en muchos escenarios.

Según AWS, las M9g con Graviton5 ofrecen hasta un 25 % más de rendimiento que la generación previa para un amplio abanico de cargas de trabajo. Cada chip Graviton5 integra 192 núcleos y una caché hasta cinco veces mayor, lo que permite manejar más hilos concurrentes, mejorar la latencia de acceso a datos y aprovechar aún mejor aplicaciones con fuerte paralelismo.

Esta combinación de más núcleos y más caché se traduce en capacidad para escalar aplicaciones empresariales, microservicios, plataformas web, APIs de alta concurrencia o backends de datos sin necesidad de multiplicar el número de instancias, reduciendo tanto la complejidad operativa como los costes de infraestructura.

Además, al estar integradas en la familia M (propósito general), las M9g encajan muy bien en escenarios mixtos: servicios web, aplicaciones Java o .NET, microservicios en contenedores, servidores de aplicaciones, pequeñas bases de datos y cargas de analítica ligera que necesitan un equilibrio entre CPU, memoria y ancho de banda de red.

Otro punto relevante es que más de la mitad de la nueva capacidad de CPU que AWS incorpora en su nube cada año viene ya de procesadores Graviton por tercer año consecutivo. Y que el 98 % de los 1.000 mayores clientes de EC2 —nombres como Adobe, Airbnb, Atlassian, Epic Games, Formula 1, Pinterest, SAP, Siemens, Snowflake o Synopsys— ya están sacando partido de la relación precio-rendimiento de Graviton, lo que da bastante confianza a quienes se plantean migrar.

Otras familias de instancias basadas en Graviton

El ecosistema de instancias EC2 impulsadas por Graviton es ya muy amplio y cubre necesidades bastante distintas. No se trata solo de M9g o de las familias M6g/M7g anteriores, sino de un catálogo que va desde instancias de propósito general hasta opciones optimizadas para memoria, red, almacenamiento o GPU.

En la generación Graviton2, por ejemplo, encontramos familias como M6g y M6gd (propósito general), C6g y C6gd (cómputo optimizado), R6g y R6gd (memoria optimizada), T4g (instancias burstable de bajo coste), X2gd (memoria extrema), o las especializadas G5g, Im4gn e Is4gen para cargas de gráficos, almacenamiento y redes de alto rendimiento.

Las instancias G5g son un caso especialmente interesante: combinan procesadores AWS Graviton2 con GPU NVIDIA T4G Tensor Core. Son las primeras instancias basadas en Arm con aceleración de GPU en una nube de primer nivel, y están pensadas para ofrecer la mejor relación precio-rendimiento en cargas gráficas, especialmente para streaming de juegos Android.

Gracias a G5g, plataformas de juegos en la nube pueden ejecutar títulos Android de forma nativa en instancias Arm, renderizar los gráficos, codificar la señal y hacer streaming directo al dispositivo móvil del usuario, reduciendo el esfuerzo de desarrollo (sin emulación ni compilaciones cruzadas) y bajando el coste por hora de streaming hasta en un 30 %. Además, estas instancias son una opción muy atractiva para inferencias de machine learning que requieran GPU NVIDIA y sus librerías de IA.

Por su parte, las instancias X8g, basadas en AWS Graviton4, están orientadas a cargas con uso intensivo de memoria, como bases de datos open source (MySQL, MariaDB, PostgreSQL), cachés en memoria (Redis, KeyDB, Memcached), EDA, análisis en tiempo real y aplicaciones en contenedores con gran consumo de RAM. Son, dentro de la serie X de EC2, las que ofrecen la mejor relación precio-rendimiento para este tipo de escenarios.

Arquitectura técnica de Graviton: vista en profundidad

Aunque cada generación tiene sus particularidades, hay una serie de rasgos técnicos clave que definen la familia Graviton y que ayudan a entender por qué ofrece tanta ventaja en la nube.

En primer lugar, cada núcleo dispone de grandes cachés L1 y L2, de modo que una parte considerable de la carga de trabajo se resuelve sin salir a memoria principal, reduciendo la latencia y mejorando la respuesta de la CPU. Además, existe una separación física entre cada vCPU: no comparten recursos críticos excepto la caché de último nivel (L3) y el sistema de memoria, lo que se traduce en un mayor aislamiento entre hilos y en menos interferencias entre cargas de trabajo.

Cuando varios núcleos necesitan compartir datos y moverlos rápidamente entre sí, entra en juego una malla de interconexión de alta velocidad, con hasta 2 TB/s de ancho de banda de bisección. Esta red interna permite que los datos viajen entre núcleos con muy poca penalización, algo clave en aplicaciones con comunicación frecuente o en cargas de ML paralelizadas.

En Graviton3 se dio un salto arquitectónico importante pasando de un chip monolítico a un diseño MCM (multi-chip module) o de chiplets, con proceso de fabricación de 7 nm en TSMC, 55.000 millones de transistores y una microarquitectura basada en Arm Neoverse-V1 profundamente modificada por Annapurna Labs.

Su subsistema de memoria integra cachés L1 de 64 KB para datos e instrucciones por núcleo (con latencias del orden de 4 ciclos de reloj), L2 de 1 MB por núcleo y una L3 unificada de 32 MB para todos los núcleos, con un enfoque similar al de Intel Ice Lake (L3 compartida sin partición en bloques rígidos por clúster como en algunos diseños de AMD). Además, usa controladores de memoria DDR5 integrados en chips de E/S dentro del paquete, lo que penaliza ligeramente la latencia frente a un diseño monolítico, pero compensa con mayor ancho de banda efectivo.

En el Front-End, Graviton3 incorpora una caché de microoperaciones, colas de recuperación más largas y un ciclo de fetch agresivo, con un ancho de banda de hasta 6 instrucciones por ciclo en decodificación (similar a AMD Zen 3). El predictor de ramas se ha rediseñado tomando ideas de Intel Ice Lake, con un BTB principal de 4K entradas y un L2 BTB de hasta 10K entradas, capaz de manejar patrones de rama muy largos (hasta 512 ramas) y reducir el coste de las predicciones erróneas.

En el Back-End, Graviton3 cuenta con 4 ALUs enteras, pipelines de memoria ampliadas respecto a Neoverse N1, y unidades vectoriales y de coma flotante optimizadas para instrucciones SVE de 256 bits y Neon mejorado. Las latencias de operaciones FP son muy competitivas: suma en 2 ciclos, multiplicación en 3 ciclos y FMA en 4 ciclos, con un rendimiento que en muchos casos supera a Intel Ice Lake SP y compite de tú a tú con AMD Zen 3.

El diseño incorpora un gran archivo de registros vectoriales (alrededor de 125 registros de 256 bits) para soportar instrucciones SVE y múltiples registros Neon, y usa ejecución fuera de orden con un buffer de reordenamiento (ROB) que se estima en unas 512 entradas, por encima de muchos diseños x86. El planificador (scheduler) asigna recursos con colas específicas para operaciones frecuentes: sumas y multiplicaciones de enteros, ramas, FP escalar y vectorial, conversiones y operaciones de memoria (loads/stores).

En cuanto a ISA y extensiones, las distintas generaciones de Graviton han ido incorporando Neon, LSE, FP16, SVE, BF16, INT8, RNG y extensiones criptográficas, lo que permite acelerar desde algoritmos de cifrado hasta inferencia de redes neuronales, pasando por análisis vectoriales intensivos.

Compatibilidad de software y ecosistema alrededor de Graviton

Uno de los factores que han facilitado la adopción de Graviton es su amplia compatibilidad con sistemas operativos y servicios de AWS. Las instancias Graviton soportan distribuciones como Amazon Linux 2, Red Hat Enterprise Linux, Ubuntu, CentOS, Debian y otras, de manera que la mayoría de herramientas y stacks habituales se pueden ejecutar sin demasiadas sorpresas.

En el ecosistema de servicios de AWS, Graviton se integra de forma nativa con contenedores (Amazon EKS, ECS, ECR), monitorización (CloudWatch), seguridad (Amazon Inspector, AWS Systems Manager) y con la cadena de CI/CD de la propia plataforma (CodeCommit, CodeBuild, CodePipeline). Para bases de datos, las instancias Graviton son compatibles con motores como MySQL, MariaDB, PostgreSQL, MongoDB o Memcached, tanto en despliegues autogestionados en EC2 como en servicios gestionados que ya han incorporado variantes Arm.

A nivel de casos de uso, los procesadores Graviton brillan especialmente en servidores web y de aplicaciones, APIs de alto tráfico, microservicios basados en contenedores, análisis de datos, workloads de machine learning (sobre todo inferencia), IoT y en general para cualquier carga con muchas vCPU paralelizables y sensibilidad al coste por hora de cómputo.

Eso sí, hay ciertos aspectos prácticos a tener en cuenta. Si en tu equipo de desarrollo predominan todavía arquitecturas x86, es fácil que los artefactos que generáis (binarios, imágenes de contenedor, librerías nativas) no sean directamente compatibles con Arm. Esto obliga a prestar atención a la arquitectura objetivo en compilación, a construir imágenes multi-arch y a verificar que todas las dependencias están disponibles para Arm.

También es relativamente habitual encontrarse con librerías de terceros sin soporte Arm, especialmente en software legado o muy específico. En estos casos hay que valorar alternativas, compilar desde código fuente o incluso adaptar parte del stack. Para ayudar en estas migraciones, AWS lanzó en enero de 2023 la herramienta Porting Advisor, un proyecto de código abierto que analiza el código fuente de una aplicación, detecta librerías o construcciones problemáticas para Arm y genera un informe con recomendaciones concretas de adaptación.

Ahorro de costes y relación precio-rendimiento

El gran argumento de AWS Graviton —y la razón por la que muchos equipos están migrando— es el ahorro de costes sin tener que sacrificar rendimiento. En la nube, donde prácticamente todo es pago por uso, cualquier mejora de eficiencia se refleja de forma directa en la factura mensual.

Los procesadores Graviton suelen ofrecer un coste por hora más bajo que instancias x86 equivalentes y, al mismo tiempo, mejoras de rendimiento en muchos tipos de cargas. Hay ejemplos conocidos con instancias R6g (Graviton2) frente a R6a/R6i (x86) donde se han observado reducciones de coste significativas manteniendo el mismo throughput o incluso mejorándolo, sobre todo en bases de datos y aplicaciones de backend optimizadas para Arm.

En el caso concreto de las instancias M9g con Graviton5, el incremento de rendimiento de hasta un 25 % respecto a la generación anterior, unido a la mayor densidad de núcleos por chip y a la mejora de cachés, permite consolidar más carga en menos instancias o dar más servicio por el mismo coste. Para muchas empresas, eso se traduce en ahorros de doble dígito en su factura de EC2 al cabo del año.

Además, al ser chips muy eficientes energéticamente, contribuyen al objetivo de optimizar consumo eléctrico y huella de carbono de los centros de datos. No es un detalle menor: a escala de AWS, todas estas mejoras de eficiencia, sumadas a los chips Trainium para entrenamiento de IA y a clusters de GPU altamente optimizados, son parte de la narrativa de “infraestructura como política” con la que AWS se presenta como proveedor capaz de sostener el siguiente salto de la IA y los agentes sin desbordar costes energéticos.

Muchos equipos que tradicionalmente elegían x86 “por costumbre” están empezando a hacer números y a descubrir que, en workloads típicos de backend, pasar a instancias Graviton puede reducir la factura a la mitad si se acompaña de una mínima optimización del software y de una revisión de tamaños de instancia. No es una promesa mágica, pero sí un resultado bastante plausible cuando se combinan ahorro por hora, mejor utilización de CPU y reducción de instancias infrautilizadas.

Mirando todo este recorrido —desde el primer Graviton hasta Graviton5, pasando por familias especializadas como G5g o X8g y por la integración profunda con el ecosistema de contenedores, bases de datos e IA de AWS—, queda bastante claro que los procesadores Graviton son ya la base estratégica de cómputo de AWS. Para cualquier organización que quiera contener costes, ganar rendimiento y preparar su infraestructura para agentes de IA, analítica avanzada y workloads modernos, tiene cada vez menos sentido ignorar Arm en la nube y no, al menos, probar qué pueden ofrecerle las instancias basadas en Graviton5 y el resto de la familia.