- Intel ha intentado monetizar sus procesadores Xeon con SDSi e Intel On Demand, bloqueando aceleradores físicos tras licencias de pago en los chips Sapphire Rapids.

- El modelo convierte al hardware en una especie de “DLC” de CPU, con funciones críticas de seguridad, análisis y redes que solo se activan previo pago, generando fuerte rechazo.

- Estos cambios llegan en un contexto de vulnerabilidades de hardware, parches que reducen rendimiento, pérdidas millonarias, despidos masivos y pérdida de liderazgo frente a NVIDIA y AMD.

- La suma de presión financiera, errores estratégicos y polémicas comerciales ha deteriorado la imagen de Intel y complica la aceptación futura de modelos de silicio definido por software.

Intel lleva años intentando reinventar su modelo de negocio en el mercado de los procesadores, y uno de los experimentos más polémicos ha sido convertir parte del hardware en una especie de DLC de pago. Bajo nombres como Software Defined Silicon (SDSi), Intel Upgrade Service e Intel On Demand, la compañía ha planteado CPUs con capacidades físicas bloqueadas que solo se activan previo paso por caja. La idea ha generado una intensa controversia entre clientes de centros de datos, comunidad de software libre y analistas del sector.

En paralelo a este giro de modelo hacia el “paga por desbloquear”, Intel arrastra problemas serios en varios frentes: vulnerabilidades de seguridad de hardware que impactan en el rendimiento, pérdida de liderazgo tecnológico frente a NVIDIA y AMD, recortes de plantilla masivos, presión bursátil y rumores de operaciones corporativas tan sonadas como una hipotética oferta de compra por parte de Qualcomm. El resultado es una tormenta perfecta que ayuda a entender por qué el intento de monetizar el silicio por software ha sido recibido con tanta desconfianza, especialmente en un contexto marcado por la creciente importancia de la inteligencia artificial.

Qué es Software Defined Silicon (SDSi) y cómo desemboca en Intel On Demand

La base de todo el modelo es Software Defined Silicon (SDSi), un enfoque por el que el chip llega físicamente con todas o muchas de sus capacidades, pero solo una parte de ellas está activa de fábrica. El resto de funciones queda deshabilitada hasta que el cliente paga una licencia adicional que, vía software y certificados, desbloquea esos bloques de hardware dormidos. Es el equivalente directo a comprar una CPU “recortada” y, más tarde, pagar por activar núcleos o aceleradores que ya estaban ahí desde el primer día.

Para hacer viable este modelo, Intel impulsó un controlador específico en Linux orientado a SDSi. Ese driver se integró en el kernel Linux 5.18 y posteriormente recibió una actualización importante que no solo cambió parte de su funcionamiento, sino también su nombre comercial y de cara a documentación: pasó a denominarse Intel On Demand, una marca mucho más directa que subraya la idea de activar funciones “bajo demanda”.

Conviene remarcar que Intel On Demand no estaba pensado para PCs domésticos ni estaciones de trabajo de usuario final. El plan inicial se centraba en el ecosistema de servidores, en concreto en los procesadores Intel Xeon Scalable de cuarta generación, de nombre en clave Sapphire Rapids. Estos chips, orientados a centros de datos, llegaban plagados de aceleradores especializados cuya activación completa o parcial se vincularía a este esquema de pago.

En la práctica, el diseño de SDSi e Intel On Demand hace que el hardware se convierta en una plataforma parcialmente bloqueada, donde la diferenciación de producto y de precio ya no depende tanto de qué se fabrica físicamente, sino de qué se habilita por software en cada CPU concreta. Para Intel, esto promete una gran flexibilidad comercial; para muchos clientes, se parece peligrosamente a pagar dos veces por lo mismo.

Intel Xeon Sapphire Rapids: aceleradores ocultos tras un muro de pago

Los Xeon Sapphire Rapids, presentados oficialmente el 10 de enero de 2023, eran la plataforma elegida por Intel para estrenar a lo grande el ecosistema On Demand. Estas CPUs de servidor integran un repertorio amplio de aceleradores de propósito específico que, sobre el papel, ofrecen importantes mejoras de rendimiento en cargas de trabajo muy concretas: inteligencia artificial, análisis de datos en memoria, compresión, cifrado, redes, etc.

Entre los bloques de hardware más destacados se encuentran:

• AMX (Advanced Matrix Extensions): extensiones centradas en acelerar operaciones matriciales, muy útiles para IA y machine learning.

• DLB (Dynamic Load Balancer): mejora la distribución de tráfico y carga en determinadas tareas de red y almacenamiento.

• IAA (In-Memory Analytics Accelerator): pensada para acelerar análisis de datos en memoria, típicos de bases de datos en-memory y analítica avanzada.

• DSA (Data Streaming Accelerator): hardware dedicado a mover datos de forma eficiente entre memoria y dispositivos, aliviando a la CPU.

• QAT (QuickAssist Technology): acelera criptografía, compresión y otros servicios relacionados con seguridad y redes.

Bajo el paraguas de Intel On Demand, estas unidades pasaban a estar divididas en “paquetes de valor” a los que el cliente podía acceder mediante licencias. Intel llegó a perfilar tres grandes bloques comerciales:

- Actualizaciones de seguridad, donde entran las extensiones Intel Software Guard Extensions (SGX) y tecnologías asociadas a enclaves seguros y protección de memoria.

- Comunicación y almacenamiento, con aceleradores como Intel QuickAssist, Intel Dynamic Load Balancer e Intel Data Streaming Accelerator, enfocados a mejorar la eficiencia en redes y en movimiento de datos.

- Paquete de análisis, que combina Intel In-Memory Analytics Accelerator e Intel Data Streaming Accelerator para acelerar escenarios de big data, bases de datos en memoria y analítica avanzada.

La clave es que estas capacidades están físicamente presentes en el silicio desde el primer minuto, pero permanecen bloqueadas en muchos SKU si el cliente no adquiere la licencia correspondiente. Desde la perspectiva de un responsable de centro de datos, esto coloca al hardware en una posición ambigua: compran un procesador “capado” por diseño, para luego ir pasando por caja si en algún momento quieren aprovechar todo su potencial.

A cambio, Intel defendía que este modelo permitía un nivel de personalización muy fino: en teoría, un operador podría lanzar su plataforma con un conjunto mínimo de funciones activas y, si ve que ciertos aceleradores empiezan a ser útiles, pagar por habilitarlos sin tener que sustituir físicamente CPUs ni parar máquinas. Menos CAPEX inicial, más gasto operacional distribuido a lo largo del ciclo de vida del servidor.

Cómo funciona Intel On Demand a nivel de software y administración

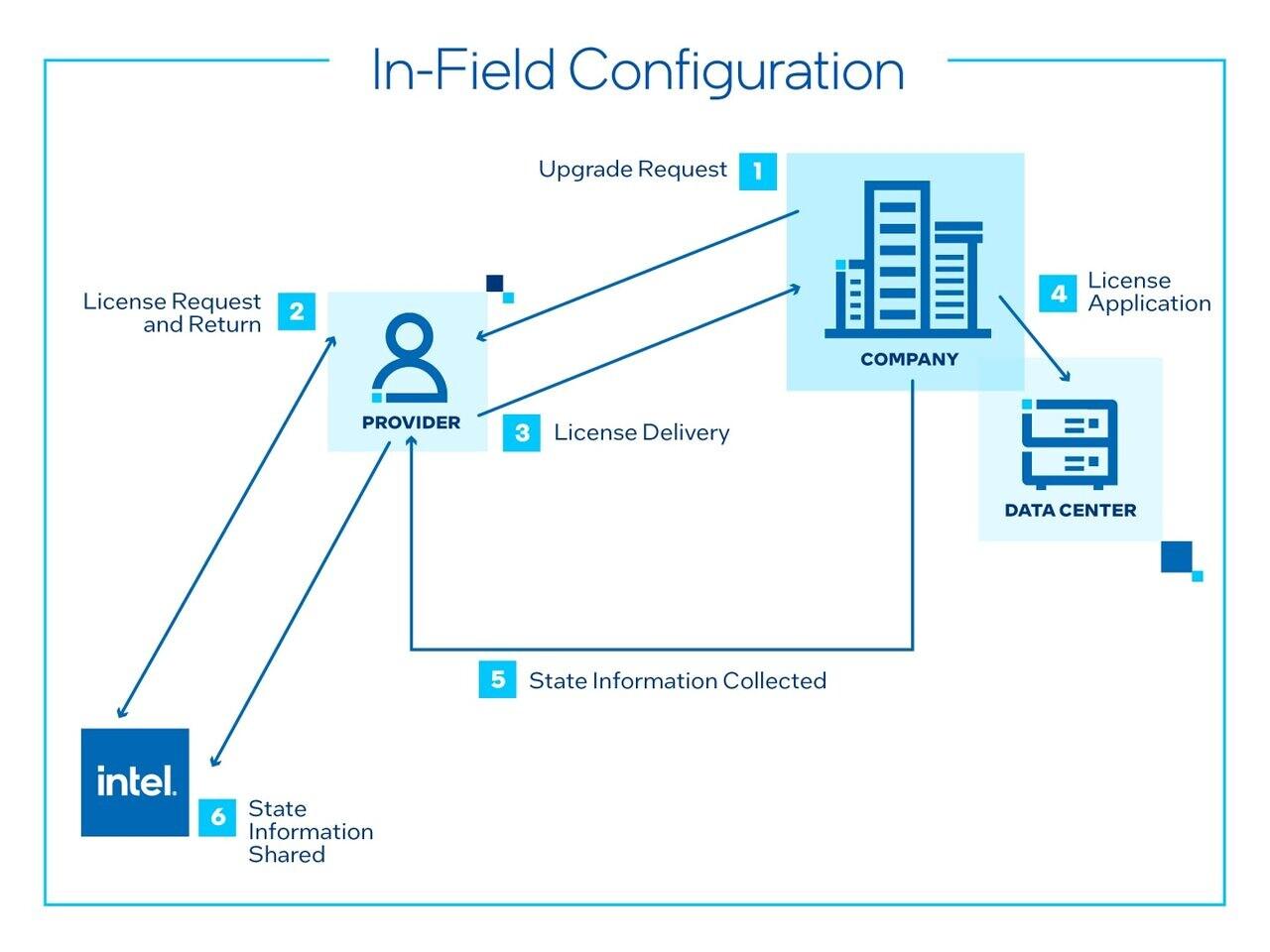

El salto de SDSi al ecosistema On Demand vino acompañado de cambios relevantes en el controlador de Linux y en la forma de exponer información al administrador del sistema. El driver, renombrado a Intel On Demand en el kernel, introdujo una serie de capacidades nuevas orientadas precisamente a gestionar este rompecabezas de funciones activadas y desactivadas en cada CPU.

Entre las principales modificaciones y características del controlador destacan:

- Capacidad para enumerar qué características y funciones están físicamente presentes en un modelo de CPU concreto, lo que facilita saber qué se podría activar llegado el caso.

- Visibilidad de las funciones deshabilitadas, de forma que el administrador pueda evaluar qué se está “perdiendo” al no contratar determinadas licencias.

- Herramientas para activar esas funciones mediante certificados On Demand, integradas con la infraestructura de sysfs de Linux para permitir automatizaciones.

- Mecanismos para identificar el controlador y las características asociadas sin cambiar los nombres de archivo expuestos al espacio de usuario, minimizando la ruptura de scripts o herramientas heredadas.

- Un sistema de limpieza de atributos que oculta archivos de sysfs cuando ciertas características son incompatibles entre sí, evitando combinaciones que puedan romper el sistema.

- Soporte explícito para nuevos GUID utilizados para identificar la disposición interna de registros y bloques de funciones.

- Capacidad para leer certificados On Demand desde sysfs, lo que permite a herramientas de auditoría y monitorización comprobar el estado de licencias.

- Cambios en las herramientas para que puedan descubrir y leer los registros On Demand, base para paneles de gestión o sistemas de inventario.

Desde el punto de vista operativo, esto significa que un administrador puede detectar qué aceleradores están físicamente ahí, cuáles están activos y cuáles se podrían activar pagando. Además, puede medir el uso de las funciones ya habilitadas para valorar si compensa o no ampliar licencias. Sobre el papel, el modelo tiene lógica empresarial; en la práctica, muchos responsables de TI lo perciben como un paso más hacia un hardware “en alquiler” disfrazado de compra.

También se planteó que el controlador On Demand se integrara en las ramas estables de Linux a partir de diciembre de 2022, preparando el terreno para la llegada al mercado de los Sapphire Rapids en enero. De este modo, las principales distribuciones empresariales podrían incorporar soporte nativo para el sistema de licencias desde muy temprano.

¿Un procesador como un DLC? Semejanzas con el modelo de los videojuegos

La analogía que más se ha repetido en la comunidad técnica es que Intel ha llevado la lógica de los DLC de los videojuegos al hardware. Igual que un juego puede salir al mercado con parte del contenido bloqueado a la espera de que el usuario pague por expansiones, aquí el procesador llega con buena parte de sus capacidades durmiendo la siesta dentro del chip.

En la práctica, si un cliente quiere exprimir al máximo su CPU, tiene que abonar un extra por cada “paquete” de funciones que vaya necesitando. Para colmo, el hecho de que las unidades de aceleración físicamente existan desde el día uno lleva a muchos a preguntarse si no se está incurriendo en una especie de “impuesto encubierto” sobre el mismo silicio: el coste de fabricación es el mismo para Intel, pero se factura más de una vez contra el cliente.

Esta percepción se agrava cuando se compara con modelos alternativos, como el de AMD en el mismo segmento, donde la segmentación suele hacerse a nivel de SKU (diferentes modelos de CPU con distintas configuraciones de núcleos y aceleradores, pero sin bloques “apagados” a la espera de licencia en el mismo chip). La sensación de algunos operadores es que el modelo On Demand reduce su libertad de elección y les ata más a la plataforma Intel.

Además, existe el temor a que esta filosofía salte del centro de datos al mercado doméstico. Si la idea funcionara bien a nivel de servidores, nada impediría a Intel (u otros fabricantes) ofrecer CPUs de escritorio con núcleos extra, caché adicional o instrucciones avanzadas bloqueadas tras un pago en su tienda online. En un contexto donde ya se pagan cientos o miles de euros por un procesador, la reacción del consumidor medio ante un “pase de temporada” para su CPU podría ser explosiva.

Por ahora, Intel ha insistido en que no tiene planes inmediatos de aplicar este modelo a procesadores domésticos, pero la semilla de la desconfianza está plantada. Y, dado el precio que alcanzan algunas CPUs de gama alta, muchos usuarios consideran que la simple posibilidad ya es motivo de preocupación.

El contexto de debilidad de Intel: pérdidas, despidos y rivales disparados

Para entender por qué el fracaso reputacional de Intel Upgrade Service / SDSi / On Demand ha sido tan sonado, hay que mirar el cuadro completo. Intel ya no es el gigante incontestado de hace dos décadas, sino una empresa que acumula tropiezos estratégicos y financieros en un mercado que se ha movido muy rápido hacia la movilidad, la nube y, más recientemente, la inteligencia artificial.

Solo en el segundo trimestre de 2024, Intel registró pérdidas por valor de 1.600 millones de dólares y una caída interanual de ingresos del 1%. A esto hay que sumarle la suspensión del dividendo a sus accionistas desde finales de 2023, algo que a ojos del mercado es un síntoma claro de dificultades.

En paralelo, el valor de sus acciones se ha desplomado hasta un 30% en algunos momentos recientes, moviéndose en la zona de los 24 dólares por título, niveles comparables a los de 2011. Mientras tanto, NVIDIA se ha revalorizado más de un 200% en lo que va de año, apoyada en la brutal demanda de sus GPUs para IA, y AMD ha más que duplicado sus ingresos en centros de datos gracias a sus procesadores EPYC y aceleradores de IA.

En este escenario, Intel ha pasado de ser percibida como un coloso intocable a verse como un “dinosaurio destronado”. Los rumores de que Qualcomm habría tanteado una oferta de absorción, y el interés de fondos como Apollo Global Management en inyectar miles de millones en la compañía, no han hecho sino alimentar la sensación de que el histórico fabricante de chips está atrapado entre la presión de sus rivales y la necesidad de reposicionarse a toda prisa.

La consecuencia interna de esta situación son planes de recorte de plantilla muy agresivos. Se habla de alrededor de un 15% de los empleados, unos 15.000 despidos, como parte de un objetivo global de reducir 10.000 millones de dólares en costes. Estos ajustes buscan proteger márgenes, pero también afectan al clima interno y a la capacidad de la empresa para ejecutar proyectos complejos sin titubeos.

Errores estratégicos de largo recorrido: de los móviles a la IA… y NVIDIA

Los problemas actuales de Intel no son solo coyunturales, sino el resultado de decisiones estratégicas fallidas a lo largo de años. Uno de los reproches más habituales es que la empresa perdió el tren de la telefonía móvil, incapaz de competir con actores como Qualcomm o Mediatek en diseños eficientes y escalables para smartphones y tablets.

Mientras tanto, otros jugadores apostaron por externalizar la fabricación y apoyarse en fundiciones punteras como TSMC, mientras que Intel se aferró durante demasiado tiempo a su modelo de fabricación propia. Lejos de traducirse en una ventaja competitiva sostenida, esto derivó en enormes inversiones en fábricas que no siempre han dado el retorno esperado y que ahora pesan como una losa en las cuentas.

La compañía también ha sido lenta en adaptarse a la ola de la inteligencia artificial. Mientras NVIDIA construía un ecosistema completo alrededor de CUDA y sus GPUs, Intel ha ido dando palos de ciego entre distintas apuestas de hardware y software, sin conseguir consolidar una plataforma que entusiasme al mercado de la misma manera.

El caso más llamativo de “oportunidad perdida” es quizá la anécdota, reconocida por el propio Pat Gelsinger, de que en 2005 el consejo de Intel se planteó comprar NVIDIA por 20.000 millones de dólares. En aquel momento, la operación se desestimó por considerarse demasiado arriesgada y onerosa. Visto desde 2024, cuando NVIDIA vale más de 30 veces Intel y ha llegado a superar en capitalización bursátil a gigantes como Apple o Microsoft, la decisión se antoja un error histórico de proporciones épicas.

Mientras tanto, proyectos muy ambiciosos como la creación de nuevas fábricas en Europa o la atracción de grandes clientes como Apple a su negocio de foundry no han terminado de cuajar. Incluso lanzamientos técnicos muy publicitados, como Meteor Lake, han sido criticados por no estar a la altura de las promesas iniciales en rendimiento y eficiencia.

Problemas de seguridad en el hardware de Intel y su impacto real en el rendimiento

Al margen del modelo de negocio de On Demand, Intel también ha sufrido sonoros golpes en el frente de la seguridad. A finales de 2023, surgió un importante fallo en el firmware de ciertas familias de procesadores que permitía a atacantes potenciales tomar el control completo de un equipo. Entre los chips afectados figuraban varias generaciones de Intel Core (presentes en millones de PCs y portátiles) y también procesadores Xeon destinados a servidores.

Poco después, investigaciones como las publicadas por The Register sacaron a la luz vulnerabilidades de diseño que llevaban una década en el hardware de Intel. Estos fallos, de naturaleza estructural, permiten a un atacante acceder al kernel del sistema y, desde ahí, obtener contraseñas y otros datos sensibles. El problema es especialmente grave porque no depende del sistema operativo: afecta indistintamente a Windows, Linux o macOS, siempre que el hardware subyacente sea uno de los modelos de Intel vulnerables.

La solución a este tipo de agujeros de seguridad no es trivial. Normalmente pasa por aplicar parches al kernel o microcódigo que mitigan el problema, pero que introducen una penalización de rendimiento nada despreciable. En algunos escenarios, se ha estimado que la potencia puede caer entre un 5% y un 30%, dependiendo del tipo de carga de trabajo y de lo dependiente que sea de operaciones sensibles a las mitigaciones.

En el ámbito de los centros de datos, esta combinación de parches de seguridad que lastran el rendimiento y un modelo de negocio que intenta cobrar por desbloquear aceleradores ha sentado especialmente mal. Operadores que gestionan miles de servidores ven cómo, por un lado, necesitan actualizar urgentemente para no exponer a sus clientes a ataques, y por otro lado se les propone pagar licencias adicionales para recuperar parte de la ventaja de rendimiento vía aceleradores dedicados.

Intel, por su parte, ha intentado rebajar el tono de alarma con comunicados oficiales en los que subraya que estos exploits, en su opinión, no permiten corromper o eliminar datos, y que el impacto en rendimiento para el usuario medio no debería ser significativo. También ha insistido en que no se trata de un bug exclusivo de sus procesadores, sino de clases de ataques que pueden afectar a dispositivos de diversos fabricantes y arquitecturas.