- Axion, CPU Arm de Google, aporta más rendimiento y eficiencia en la nube sin reescrituras masivas.

- Clústeres mixtos x86+Arm con Titanium, Hyperdisk y orquestación avanzada optimizan costes.

- Google ya ejecuta servicios como BigQuery y Spanner en Axion y acelera la migración con IA.

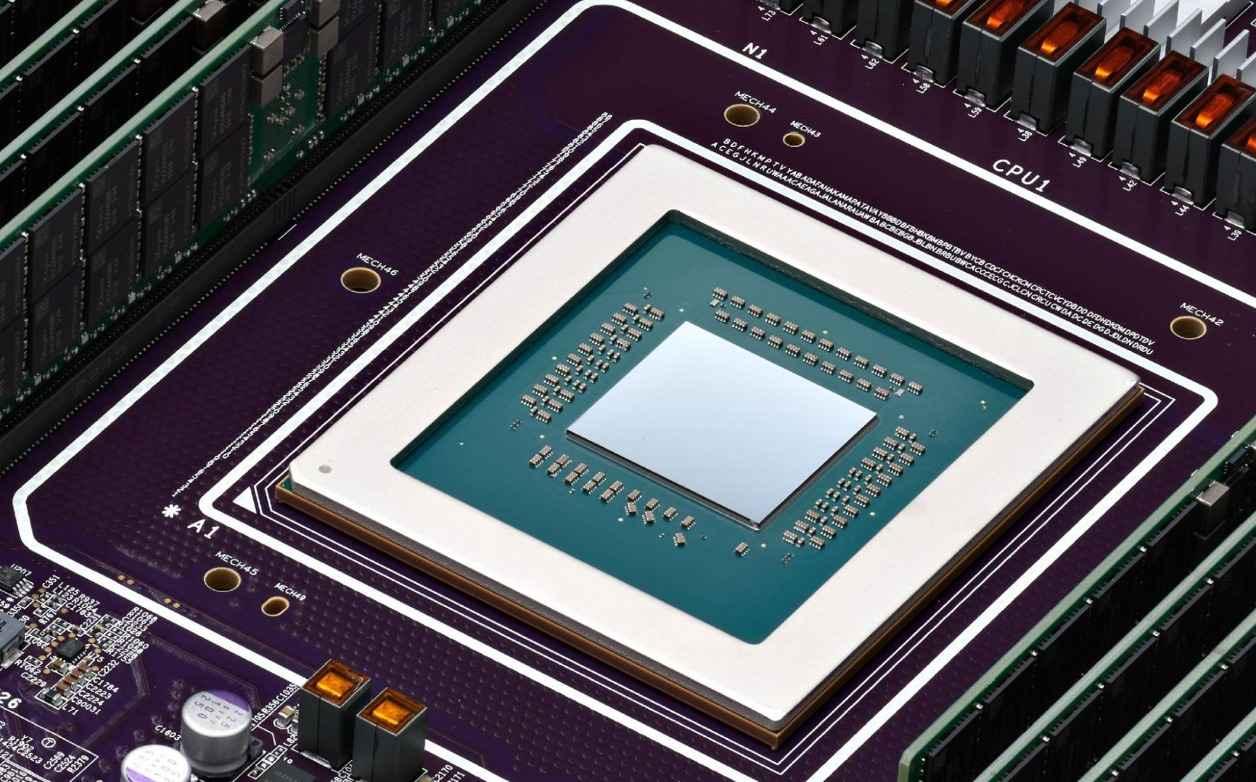

Google ha movido ficha con Axion, su familia de CPU personalizadas basadas en Arm para centros de datos, y el impacto va mucho más allá de un cambio de silicio: afecta a rendimiento, eficiencia, seguridad, costes y a cómo se despliegan aplicaciones a escala. En un contexto donde la IA, los datos y los microservicios marcan el paso, la estrategia no es solo técnica; también es operativa y de negocio.

La compañía está integrando Axion en producción junto a servidores x86, habilitando clústeres de múltiples arquitecturas que conviven en servicios propios (como BigQuery, Spanner o YouTube Ads) y en Google Cloud. Con cifras ambiciosas —hasta un 30% más de rendimiento frente a instancias Arm comparables y hasta un 50% sobre x86, además de hasta un 60% de mejora en eficiencia energética—, se abre una etapa en la que la elección de CPU se alinea con la carga, el coste y la sostenibilidad.

Qué es Axion y por qué ahora

Axion es la primera CPU de Google para el data center diseñada sobre Arm, construida sobre Arm Neoverse V2 y la arquitectura Armv9. Su propósito es dar servicio a cargas de uso general y de datos, así como a trabajos de IA basados en CPU, reduciendo la dependencia de proveedores tradicionales y encajando con la tendencia del sector hacia infraestructuras optimizadas.

Google afirma que Axion estará disponible para clientes de Google Cloud y, de hecho, ya lo utiliza internamente en BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine y la plataforma publicitaria de YouTube. La promesa clave es que los clientes puedan mover aplicaciones a Arm con cambios mínimos gracias a estándares e interoperabilidad pensados para la nube.

Una pieza distintiva es Titanium, un sistema de microcontroladores de silicio personalizado que descarga operaciones de plataforma (red, seguridad) y el procesamiento de E/S de almacenamiento hacia Hyperdisk. Con estas tareas fuera del camino, las CPU Axion pueden dedicar más recursos al cómputo de las cargas del usuario, mejorando latencia y throughput.

El movimiento se apoya en un ecosistema Arm que ya está maduro en la nube: Android, Kubernetes, TensorFlow o Go han recibido optimizaciones para Arm, y Google ha contribuido a estándares como SystemReady VE, que facilitan que sistemas operativos y paquetes habituales se ejecuten en servidores y máquinas virtuales Arm sin fricciones.

Arquitectura, seguridad y diseño del sistema

Dentro del diseño, diversas fuentes internas mencionan que Axion se fabrica en 5 nm y que combina núcleos de alto rendimiento y de eficiencia (con referencias a configuraciones con hasta 128 núcleos y frecuencias de hasta 3.8 GHz en núcleos de rendimiento), alineado con la hoja de ruta Armv9. La meta: maximizar el rendimiento por vatio y el paralelismo en cargas multi-hilo.

En vectorización y procesamiento multimedia/científico, Armv9 aporta instrucciones SVE2, con escalado SIMD flexible para acelerar inferencia de ML, analítica y procesamiento de datos. Los toolchains modernos (Clang/LLVM, GCC) generan binarios nativos ARM64, reduciendo o eliminando la necesidad de emulación para los contenedores y mejorando así el rendimiento real.

El plano de seguridad de Axion es otro pilar: PAC (Pointer Authentication) y Memory Tagging Extension ayudan a mitigar clases de ataques como overflow o use-after-free, añadiendo mitigaciones a nivel de hardware. La plataforma integra arranque verificado (Secure Boot) y soporte TPM 2.0, además de cifrado AES-256 en tránsito y en reposo, con módulos que cumplen estándares como FIPS 140-2.

La red y el almacenamiento se han pensado para dar servicio a clústeres heterogéneos con backbones de alta velocidad (hasta 400 Gbps), conmutación de baja latencia y el filesystem distribuido Colossus actuando como capa de abstracción. En la práctica, estas piezas reducen el “peaje” entre nodos x86 y Arm, manteniendo consistencia y disponibilidad.

Rendimiento y eficiencia: números y comparativas

Según datos compartidos por Google, Axion logra hasta un 30% más de rendimiento frente a instancias Arm de uso general líderes en la nube y hasta un 50% más de rendimiento que instancias x86 comparables de generación actual. Todo ello con hasta un 60% de mejora en eficiencia energética frente a x86, una palanca clave para costes y objetivos de sostenibilidad.

En métricas de negocio, en documentos recientes se ha citado que mover cargas a Axion puede traducirse en hasta un 65% de rendimiento por precio frente a x86 para determinadas cargas internas, lo que explica parte del empuje para migrar aplicaciones de producción a Arm dentro de Google.

Para ubicar diferencias, el ecosistema x86 aporta AVX-512 en vectorización y un legado enorme de software; Arm ofrece SVE2, eficiencia superior y un rendimiento multihilo muy competitivo. La combinación en un mismo clúster permite asignar trabajos legacy a x86 y cargas modernas o altamente paralelizables a Arm.

Más allá de benchmarks sintéticos, el cambio se nota en trabajos reales de uso general (servidores web, microservicios), bases de datos open source, cachés en memoria, analítica de datos y tareas de IA basadas en CPU: compilar código, preprocesar datos, ejecutar inferencias ligeras y coordinar pipelines de ML.

Clústeres multi-arquitectura: cómo conviven x86 y Arm

El gran salto no es solo el chip, es la operación. Google ejecuta clústeres con nodos x86 y Arm bajo un plano de control unificado inspirado en Borg (precursor de Kubernetes). El programador asigna cargas en función de coste, latencia, CPU disponible y, por supuesto, compatibilidad binaria.

En Kubernetes, la heterogeneidad se resuelve con afinidades de nodo y selectores, de modo que los pods destinados a Arm se planifican en nodos compatibles. Los manifests pueden incluir constraints por arquitectura y recursos, y la observabilidad (Prometheus, Grafana) se adapta para leer métricas en entornos mixtos.

Para facilitar despliegues, se contemplan imágenes multi-arquitectura y, cuando no hay binarios nativos, se puede recurrir a QEMU para emulación dinámica. Aun así, la recomendación para producción con carga sostenida es compilar nativo ARM64 para exprimir Axion sin sobrecoste.

El autoescalado aprovecha la diversidad: si un microservicio de IA basado en CPU sube en demanda, el orquestador puede moverlo a nodos Axion y jugar con instancias de coste variable (por ejemplo, spot), manteniendo SLOs y reduciendo factura cuando es posible.

Modelos de precio y servicios: cómo pagar menos sin complicarse

Google Cloud ofrece varias vías para entrar: hay una opción de inicio gratuito para comenzar sin coste y probar servicios, lo que ayuda a validar compatibilidad y rendimiento de forma segura.

El modelo más habitual es pago por uso (pay-as-you-go): pagas solo por lo que consumes, sin pagos adelantados ni penalizaciones por cancelación. Los precios cambian según configuración, uso y región, y Google remite a su documentación para el detalle.

En cómputo, se citan instancias c4a-highcpu con un precio de partida en torno a 0.03787 USD por hora, con opciones de ahorro que pueden alcanzar porcentajes elevados (p. ej., tramos de hasta el 55% y hasta el 91% en determinados compromisos o modalidades).

En almacenamiento, hay varias familias con precios desde el primer GB por mes: Persistent Disk a partir de 0.048 USD/GB/mes, Hyperdisk desde 0.125 USD/GB/mes y SSD local desde 0.08 USD/GB/mes. Hyperdisk desacopla rendimiento del tamaño de la instancia y se puede aprovisionar de forma dinámica en tiempo real.

En red, el nivel Standard usa Internet pública para el tráfico entre tus servicios y usuarios. Las entradas son gratuitas y las salidas son gratis hasta 200 GB/mes. El nivel Premium enruta sobre la red troncal de Google y parte desde 0.08 USD por GB de salida (las entradas siguen sin coste).

IA, ciberseguridad y tecnologías distribuidas

En inteligencia artificial, Axion acelera inferencias y tareas de entrenamiento ligadas a CPU gracias a SVE2 y a bibliotecas optimizadas (ONNX Runtime sobre Neon, toolchains nativos ARM64). En entornos de grandes modelos, puede reducir latencia en paso de datos, preprocesado y orquestación.

En seguridad, la diversidad arquitectónica añade defensa en profundidad: un incidente en x86 no implica necesariamente exposición en nodos Arm, especialmente con segmentaciones VPC, RBAC y controles de identidad. PAC y MTE suman mitigaciones a bajo nivel, y el cumplimiento se apoya en cifrado AES-256 y certificaciones de módulos criptográficos.

Para blockchain y sistemas distribuidos, la eficiencia energética de Arm y su relación rendimiento/vatio favorecen validadores y nodos completos. En pruebas internas se han visto mejoras de throughput en transacciones de smart contracts compilados para ARM64, algo que impacta tanto en costes como en sostenibilidad.

En regulatorio, Google referencia GDPR, HIPAA y NIST SP 800-53 como marcos sobre los que articula controles; herramientas como Binary Authorization verifican firmas de contenedores antes del despliegue, y la trazabilidad facilita auditorías en entornos híbridos.

La migración masiva interna: 30.000 paquetes y una IA llamada CogniPort

Google ha movido alrededor de 30.000 paquetes de producción hacia Arm y planifica completar la conversión para que sus cargas internas se ejecuten tanto en Axion como en x86. Servicios como YouTube, Gmail y BigQuery ya funcionan sobre ambas arquitecturas.

En el preprint «Instruction Set Migration at Warehouse Scale» y publicaciones técnicas se detalla el proceso: los equipos esperaban problemas de punto flotante, concurrencia y dependencias específicas, pero la realidad fue más manejable gracias a compiladores modernos y sanitizadores.

Las primeras migraciones (F1, Spanner, Bigtable) tiraron de ingeniería metódica: sprints semanales, ajustes de sistemas de build/release y refactor de pruebas acopladas a suposiciones x86. El cuello de botella más habitual estuvo en test suites envejecidas y pipelines de despliegue.

Para escalar, Google desarrolló CogniPort, una IA que genera commits y corrige compilaciones o pruebas. En condiciones concretas logra arreglos automáticos en torno al 30% de los casos, especialmente en pruebas frágiles, condicionales por plataforma y problemas de representación de datos.

El objetivo es que Borg pueda programar cargas según coste y rendimiento entre servidores Arm y x86. Si Axion reduce coste por unidad de trabajo y mejora la eficiencia, el planificador inclinará la balanza hacia Arm cuando tenga sentido sin sacrificar SLOs.

Comparativa técnica x86 vs Arm en la nube

En núcleos individuales, x86 suele ofrecer gran rendimiento single-thread gracias a frecuencias elevadas y amplia caché; Arm compensa con mayor densidad de núcleos y eficiencia superior, ofreciendo un multihilo muy sólido para microservicios y analítica distribuida.

En instrucciones vectoriales, x86 aporta AVX-512 en escenarios HPC/ML específicos, mientras que Arm SVE2 escala anchos SIMD y saca partido a pipelines muy paralelos. La elección depende del perfil de workload y de si se optimiza a librerías nativas de cada ISA.

En seguridad de hardware, x86 cuenta con SGX para enclaves, mientras que Arm destaca con PAC/MTE para robustecer memoria y punteros. Al convivir en la misma malla de servicios, la superficie de ataque se diversifica, lo que complica la explotación sistemática.

En compatibilidad, x86 goza de un ecosistema legacy muy asentado; Arm crece rápido en contenedores y Linux, y los artefactos multi-arch, más QEMU cuando no hay binario nativo, suavizan el aterrizaje.

Casos de uso en industria y patrones de adopción

Empresas intensivas en datos en tiempo real —como Uber o Spotify— han evaluado o movido cargas hacia Arm por coste y eficiencia, especialmente en servicios elásticos y pipelines de streaming que se benefician de CPUs densas y de alto paralelismo.

En ciberseguridad, algunos proveedores (por ejemplo, simulaciones de amenazas) aprovechan la heterogeneidad para reducir la evasión basada en fingerprints de hardware. Cambiar de ISA complica a los atacantes y aporta señales adicionales en detección de anomalías.

En IA distribuida, el aprendizaje federado y los recomendadores de baja latencia sacan partido del mix de CPU eficiente, red de alta velocidad y almacenamiento desacoplado. Frameworks como Flower se alinean bien con clústeres híbridos.

Para equipos DevOps, Google documenta rutas de migración y gcloud CLI con soporte para imágenes Arm, además de compatibilidad preliminar en “Migrate to Virtual Machines” para mover instancias a la nueva arquitectura con fricción reducida.

Herramientas, buenas prácticas y operación diaria

La recomendación para plataformas con microservicios es añadir pruebas multi-arquitectura en CI/CD (Jenkins, GitHub Actions) para detectar incompatibilidades temprano. Matrices por arquitectura/OS reducen sorpresas en producción.

El profiling con perf en Linux y trazas en eBPF ayuda a identificar servicios candidatos para Arm (alto paralelismo, hotspots de CPU) y a medir beneficio real. Incluir KPIs de coste/latencia/consumo eléctrico en los dashboards guía decisiones de scheduling.

Para IA basada en CPU, bibliotecas como Arm Compute Library y toolchains LLVM/GCC actualizados desbloquean optimizaciones. En contenedores, usar multi-arch manifests y etiquetar imágenes adecuadamente evita tirones en el scheduler.

En cumplimiento y cadena de suministro, fortalecer Binary Authorization, SBOM y firmas de contenedores garantiza que la diversidad de arquitecturas no abra brechas. Escáneres y políticas de admisión deben incluir reglas por arquitectura.

La supervisión continua con Falco u otros motores de seguridad en tiempo real añade una capa dinámica para detectar anomalías en nodos heterogéneos, manteniendo una postura coherente entre x86 y Arm.

Con Axion, Google está marcando una dirección clara: chips Arm personalizados, offloads como Titanium, redes troncales premium y un enfoque pragmático de multi-arquitectura que mezcla lo mejor del ecosistema x86 con la eficiencia de Arm. Al poner los números sobre la mesa —rendimiento, coste, energía— y divulgar métodos (como la IA CogniPort y las guías de migración), el mensaje para equipos técnicos es nítido: hay un camino realista para aprovechar Arm a gran escala sin reescribirlo todo y con herramientas que acortan el viaje.