- AWS apuesta por agentes de IA autónomos soportados en Agent Core, frontier agents y la nueva familia de modelos multimodales Amazon Nova 2.

- Nova Forge, Nova Act, RFT en Bedrock y SageMaker AI simplifican la creación de modelos y agentes personalizados ajustados a cada negocio.

- Trainium3, Graviton5 y las AI Factories refuerzan la infraestructura para IA a gran escala, combinando rendimiento, eficiencia energética y soberanía de datos.

- Casos de clientes como Sony, Adobe, Lyft o Nasdaq prueban el potencial práctico de la estrategia agentic de AWS en entornos reales.

AWS re:Invent 2025 ha sido el punto de inflexión en el que Amazon Web Services ha pasado de hablar de asistentes de IA a apostar sin complejos por agentes autónomos, nuevos modelos fundacionales y un hardware propio cada vez más ambicioso. A lo largo de cinco intensos días en Las Vegas, la compañía ha dejado claro que su objetivo ya no es solo vender infraestructura en la nube, sino redefinir cómo se construye software y cómo trabajan los equipos técnicos y de negocio.

Con miles de asistentes in situ y acceso online a keynotes y sesiones técnicas, la edición de este año ha girado en torno a tres grandes ejes: la nueva familia de modelos Amazon Nova 2, la plataforma agentic (Agent Core, Nova Forge, Nova Act y los nuevos frontier agents) y una capa de infraestructura reforzada con chips como Trainium3 y Graviton5, además de las AI Factories que llevan la nube de IA al propio centro de datos del cliente.

El giro estratégico: de asistentes a agentes de IA autónomos

Matt Garman, nuevo CEO de AWS, abrió la keynote marcando tono y cifras: 132.000 millones de dólares de facturación anual, un crecimiento del 20 % interanual y más de 22.000 millones añadidos en solo un año, más que la facturación total de más de la mitad de las empresas del Fortune 500. Sobre esa escala, el mensaje central fue claro: la próxima década en la nube estará dominada por agentes de IA que trabajarán de forma autónoma dentro de las organizaciones.

Según Garman, la primera ola de proyectos de IA se ha quedado en asistentes y chatbots útiles pero limitados. El “verdadero valor” llega cuando esos asistentes se convierten en agentes capaces de planificar, ejecutar tareas complejas, tomar decisiones dentro de unos límites y operar durante horas o días sin supervisión constante. AWS anticipa un futuro con miles de millones de agentes repartidos por cada empresa, embebidos en procesos de negocio de todo tipo.

Este cambio de enfoque se apoya en una infraestructura masiva: S3 gestiona ya más de 500 billones de objetos, con cientos de exabytes almacenados y picos de 200 millones de peticiones por segundo; más de la mitad de la CPU añadida a AWS procede de procesadores Graviton por tercer año seguido; y Bedrock ya sirve inferencias de IA a más de 100.000 compañías, muchas de ellas consumiendo más de un billón de tokens cada una.

Para respaldar la ambición en IA, AWS ha desplegado ya más de un millón de chips Trainium en producción y ha ampliado su capacidad de centros de datos en 3,8 gigavatios adicionales en un solo año, apoyado en una red privada de unos 9 millones de kilómetros de fibra óptica. No es solo una exhibición de músculo técnico: es la base sobre la que AWS quiere construir el stack completo de IA, desde el silicio hasta las aplicaciones orientadas a negocio.

Escala, seguridad y ecosistema: el contexto en el que se asienta la nueva IA

Antes de entrar en detalle sobre los anuncios de IA, AWS refuerza su narrativa clásica en tres frentes: alcance global, seguridad por diseño y un ecosistema de partners y startups que se ha consolidado como el más amplio del sector cloud.

En cuanto a huella geográfica, AWS cuenta ya con 38 regiones, 120 zonas de disponibilidad y nuevos planes de expansión, conectados por una red propia tan extensa que, en palabras de Garman, permitiría ir de la Tierra a la Luna y volver unas once veces. Esta infraestructura se presenta como requisito previo para que los agentes de IA funcionen con baja latencia y alta disponibilidad en cualquier mercado.

La seguridad se mantiene como “prioridad uno” dentro del discurso oficial. AWS presume de soportar cargas tan sensibles como los sistemas de inteligencia de Estados Unidos, la migración de los mercados de Nasdaq o la transformación digital de grandes farmacéuticas como Pfizer. Estos casos de uso, lejos de ser meros logos, se utilizan como prueba de que los agentes de IA pueden desplegarse en sectores fuertemente regulados sin renunciar al cumplimiento normativo.

El tercer pilar es el ecosistema: integradores, ISV, SaaS y startups juegan un papel clave. AWS subraya que más unicornios se han levantado sobre su nube que sobre cualquier otra plataforma y que más de la mitad de las startups financiadas por los fondos de capital riesgo más relevantes corren en su infraestructura. El mensaje de fondo es que la innovación en modelos fundacionales y agentes de IA se está incubando dentro de AWS, no en sus márgenes.

Este contexto es importante para entender por qué la compañía está dispuesta a invertir tanto en agentes: si la siguiente ola de productividad se canaliza a través de plataformas agentic, AWS quiere ser la capa donde se orquesten esos agentes, se entrenen los modelos subyacentes y se gobiernen los datos y las políticas.

Frontier agents: Kiro, Security Agent y DevOps Agent

Una de las grandes estrellas del evento han sido los nuevos frontier agents de AWS, una familia de agentes de IA más sofisticados y autónomos, diseñados para operar sin supervisión continua, gestionar múltiples tareas en paralelo y cooperar entre sí para lograr objetivos de alto nivel.

Estos frontier agents comparten tres rasgos fundamentales: autonomía operativa, escalabilidad y capacidad de trabajo prolongado. Basta con indicar un objetivo y los agentes se encargan de descomponerlo, planificar la ejecución, coordinarse y avanzar incluso durante días, manteniendo siempre un mecanismo de supervisión humana mediante propuestas de cambios y pull requests.

Los tres primeros frontier agents anunciados, disponibles en versión de prueba, son Kiro Autonomous Agent, AWS Security Agent y AWS DevOps Agent. Todos ellos están orientados a transformar el ciclo de vida del desarrollo de software, desde la ideación y el diseño hasta la operación y la seguridad en producción.

Con este movimiento, AWS pretende que los equipos de ingeniería pasen de “pedirle cosas puntuales a un asistente” a delegar proyectos completos a agentes que entienden el contexto, el código y los sistemas, de modo que las personas se centren en decisiones de alto impacto y gobierno de producto.

Kiro Autonomous Agent: un compañero de desarrollo que no se cansa

Kiro Autonomous Agent es el frontier agent especializado en desarrollo de software. Su objetivo es mantener el trabajo avanzando de forma constante mientras los desarrolladores se concentran en tareas críticas de diseño, arquitectura o interacción con negocio, evitando que queden atrapados en tareas repetitivas de mantenimiento.

Este agente conserva un contexto persistente entre sesiones y aprende de los pull requests, revisiones y feedback que recibe. Puede encargarse de labores como clasificar y priorizar bugs, mejorar la cobertura de tests o realizar cambios coordinados que afectan a varios repositorios con una sola iniciativa.

El flujo habitual consiste en que los desarrolladores le planteen preguntas, describan tareas o asignen ítems del backlog directamente desde GitHub. A partir de ahí, Kiro decide cómo acometer el trabajo, proponiendo parches en forma de ediciones sugeridas y pull requests para que el equipo humano revise y valide antes de fusionar.

Kiro se concibe como un recurso compartido de todo el equipo, que va construyendo una comprensión colectiva del código, los productos y los estándares internos. Se integra con herramientas como Jira, GitHub o Slack, y con los pipelines CI/CD del equipo, manteniendo el contexto a medida que cambian las prioridades o evolucionan los proyectos.

Cada revisión de código, cada ticket resuelto y cada decisión arquitectónica alimentan el conocimiento del agente, de forma que su utilidad crece con el tiempo. En la práctica, actúa como un desarrollador virtual siempre disponible, que ejecuta tareas de fondo y ayuda a reducir drásticamente el tiempo desde la idea hasta el valor en producción.

AWS Security Agent: seguridad integrada desde el diseño

AWS Security Agent se centra en incorporar buenas prácticas de seguridad a lo largo de todo el ciclo de vida del software, tanto en entornos 100 % AWS como en escenarios multicloud e híbridos. El objetivo es evitar que la seguridad quede relegada a una fase tardía o a auditorías periódicas.

Este agente revisa documentos de arquitectura, especificaciones de diseño y pull requests comparándolos con los requisitos de seguridad de la organización y con catálogos de vulnerabilidades comunes. En lugar de depender de checklists genéricas, permite codificar una vez los estándares internos y verificarlos sistemáticamente en cada aplicación.

Una de sus aportaciones más disruptivas es transformar las pruebas de penetración en un servicio bajo demanda, alineado con el ritmo real de despliegues. Donde antes los pentests eran procesos lentos, manuales y costosos, ahora pueden ampliarse a un mayor número de aplicaciones y entornos con mucha más frecuencia.

Cuando descubre problemas, AWS Security Agent devuelve hallazgos validados con propuestas de remediación y fragmentos de código listos para implementar, acelerando la corrección y reduciendo la fricción entre equipos de seguridad y desarrollo.

Además, se puede escalar horizontalmente el número de instancias del agente para acompañar picos de despliegue. De este modo, los equipos no tienen que elegir entre velocidad y seguridad: el agente verifica continuamente desde la fase de diseño hasta la de entrega, ayudando a prevenir vulnerabilidades desde el origen.

AWS DevOps Agent: fiabilidad y observabilidad siempre activas

AWS DevOps Agent apunta a mejorar la operación diaria de las aplicaciones en entornos AWS, multicloud e híbridos, con menos alertas ruidosas y más información accionable para los equipos on-call.

Este agente se encarga de un triaje permanente de incidentes, ofreciendo guías de resolución, correlacionando síntomas con causas probables y sugiriendo cambios que mejoran la fiabilidad y el rendimiento. Cuando se produce un incidente, responde al instante y utiliza su conocimiento de la aplicación y de las relaciones entre componentes para localizar la raíz del problema.

DevOps Agent alimenta su comprensión con datos de herramientas de observabilidad, runbooks, repositorios de código y pipelines CI/CD. A partir de ahí, genera un mapa de recursos de la aplicación, relaciona telemetría, cambios de código y despliegues, y ayuda a reducir el tiempo medio de resolución (MTTR).

Además de operar de forma reactiva, el agente analiza patrones en incidentes históricos para sugerir mejoras continuas en cuatro áreas: observabilidad, optimización de infraestructura, calidad de los pipelines de despliegue y resiliencia de las aplicaciones frente a fallos.

Este enfoque permite exprimir el valor oculto en la montaña de datos operativos que ya generan las empresas, y convertirlo en recomendaciones concretas que aumentan la estabilidad y acortan los tiempos de recuperación después de un problema.

La familia de modelos frontier Nova 2: Lite, Pro, Sonic y Omni

Sobre estos agentes se asienta la nueva generación de modelos Amazon Nova 2, pensada para cubrir desde tareas cotidianas de razonamiento hasta experiencias multimodales y conversacionales en tiempo real. AWS amplía así su catálogo con cuatro modelos principales: Nova 2 Lite, Pro, Sonic y Omni.

Nova 2 Lite es el modelo de razonamiento rápido para uso diario. Está diseñado para procesar texto, imágenes y vídeo y devolver salidas en texto, con la particularidad de que los usuarios pueden regular cuánto “razonamiento paso a paso” aplica antes de responder. Esto permite ajustar el equilibrio entre profundidad de análisis, coste y latencia.

Este modelo es ideal para chatbots de atención al cliente, automatización de procesos de negocio, procesamiento de documentos y generación de código. También puede ofrecer respuestas fundamentadas y precisas a partir de grandes volúmenes de información y orquestar flujos de trabajo agentic de varios pasos sin necesidad de modelos más pesados.

Nova 2 Pro se posiciona como el modelo de razonamiento avanzado, incorporando soporte de voz además de texto, imagen y vídeo. Está especialmente indicado para tareas exigentes como codificación agentic, planificación de largo recorrido, resolución de problemas complejos o análisis de múltiples documentos y fuentes.

Pro destaca en razonamiento sobre vídeo, seguimiento de instrucciones complejas, matemáticas avanzadas y tareas de ingeniería de software. Además, puede actuar como “profesor” para modelos más pequeños, transfiriéndoles capacidades a través de técnicas de distilación para casos de uso específicos.

Tanto Lite como Pro incorporan grounding en la web y capacidad de ejecución de código, de modo que pueden consultar información actualizada online y ejecutar fragmentos de código directamente para resolver tareas técnicas o de análisis de datos.

Nova 2 Sonic se centra en la interacción voz a voz en tiempo real. Unifica comprensión y generación tanto de audio como de texto para ofrecer una experiencia conversacional muy cercana al diálogo humano, con soporte multilingüe ampliado, voces expresivas y una ventana de contexto de hasta un millón de tokens.

Este modelo puede gestionar tareas de forma asíncrona, lo que permite mantener conversaciones naturales con cambios de tema mientras otras acciones se están ejecutando en segundo plano. Se integra de forma nativa con Amazon Connect, proveedores de telefonía y frameworks de IA conversacional, convirtiéndose en una pieza clave para contact centers, asistentes de voz y experiencias interactivas.

Por último, Nova 2 Omni es el modelo multimodal de razonamiento y generación capaz de procesar texto, imágenes, vídeo y voz y devolver tanto texto como imágenes. Soporta contextos extremadamente amplios (centenares de páginas, horas de audio, vídeos largos) y puede analizar simultáneamente catálogos de productos, testimonios, guías de estilo y bibliotecas de vídeo.

Omni muestra resultados sobresalientes en benchmarks públicos de razonamiento multimodal y puede generar imágenes de alta calidad alineadas con el contenido y el contexto, lo que lo convierte en una opción muy potente para marketing, documentación técnica ilustrada o análisis de contenidos complejos.

Nova Forge y Nova Act: personalización abierta y flotas de agentes

Para que cada empresa pueda adaptar los modelos Nova a su realidad, AWS presenta Nova Forge, un servicio de entrenamiento abierto que permite crear variantes optimizadas de los modelos Nova (“Novellas”) combinando datos propietarios con los datasets curados por Amazon.

La clave de Nova Forge es que da acceso a checkpoints exclusivos de los modelos Nova (preentrenados, en fases intermedias y posentrenados), permitiendo inyectar datos específicos de la organización en distintas etapas del proceso de entrenamiento. Así, una compañía puede incorporar su histórico de diseños, errores, restricciones regulatorias o casos de uso en el propio preentrenamiento, no solo en el fine-tuning final.

El resultado es un modelo que conserva la capacidad de razonamiento general de Nova pero entiende con profundidad el dominio de negocio de la empresa. Nova Forge ya permite crear Novellas desde hoy, y los usuarios de la plataforma tendrán acceso anticipado a modelos como Nova 2 Pro y Nova 2 Omni para sus proyectos personalizados.

Además, Nova Forge ofrece opciones avanzadas de entrenamiento: se pueden emplear entornos de aprendizaje por refuerzo propios, generar modelos más pequeños y rápidos a partir de ejemplos creados con modelos mayores, y aprovechar un paquete de herramientas de IA responsable para implementar controles de seguridad, filtros de contenido y mecanismos de auditoría.

En paralelo, AWS lanza Nova Act como servicio gestionado para crear y desplegar agentes basados en navegador. Impulsado por un Nova 2 Lite adaptado a este contexto, Nova Act permite diseñar y controlar flotas de agentes que realizan tareas en interfaces web, como formularios complejos, flujos de backoffice o integraciones con herramientas SaaS que no ofrecen APIs completas.

Personalización avanzada con Amazon Bedrock RFT y SageMaker AI

La personalización de modelos es otro de los frentes donde AWS pisa el acelerador. En Amazon Bedrock, la gran novedad es Reinforcement Fine Tuning (RFT), una capacidad que simplifica los flujos de ajuste de modelos mediante aprendizaje por refuerzo guiado por funciones de recompensa.

Con RFT, los desarrolladores eligen un modelo base, lo conectan a sus registros de invocación o cargan un dataset y definen una función de recompensa que puede basarse en reglas, plantillas predefinidas o incluso en otros modelos de IA. Bedrock se encarga de orquestar todo el proceso de ajuste de extremo a extremo.

Según AWS, esta técnica consigue mejoras medias del 66 % en precisión respecto al modelo base, lo que permite obtener resultados de alta calidad con modelos más pequeños, rápidos y baratos en lugar de depender únicamente de gigantes muy costosos.

En su lanzamiento, RFT es compatible con Amazon Nova 2 Lite y progresivamente se ampliará a más modelos dentro del catálogo de Bedrock, incluyendo opciones de terceros como Gemma, MiniMax M2, Nemotron de NVIDIA o los nuevos modelos de Mistral.

Por su parte, SageMaker AI incorpora personalización de modelos sin servidor, permitiendo completar en días lo que antes llevaba semanas o meses. Los usuarios pueden optar por dos experiencias: una modalidad “agéntica” en vista previa, donde un agente guía todo el proceso descrito en lenguaje natural, y un modo auto-dirigido para quienes quieren un control granular sobre técnicas y parámetros.

Ambos enfoques dan acceso a técnicas de vanguardia como RLHF (aprendizaje por refuerzo a partir de feedback), fine-tuning supervisado y optimización directa de preferencias, pero sin la carga de gestionar infraestructura ni clusters de entrenamiento complejos.

Agent Core: el “sistema operativo” de la era de los agentes

Si la infraestructura y los modelos son la base, Agent Core es la capa donde se orquesta el comportamiento de los agentes. AWS lo presenta como la plataforma agentic más avanzada para construir, desplegar y operar agentes a escala, con foco en la seguridad, la observabilidad y la gobernanza.

Agent Core integra un runtime serverless aislado por sesión, una memoria de corto y largo plazo para que los agentes aprendan con el uso, un gateway para descubrir herramientas y datos, un sistema de identidad y permisos, y componentes fundamentales como un intérprete de código seguro y un navegador gestionado.

La plataforma es modular y abierta: puede trabajar con frameworks externos como LangChain o Crew AI y con modelos alojados tanto dentro como fuera de Bedrock. La jugada de AWS es posicionar Agent Core como el “sistema operativo” para agentes, independientemente del LLM subyacente.

Para demostrar su aplicabilidad, AWS cita casos como Nasdaq, que evita construir su propia infraestructura de agentes y se concentra en la lógica de negocio; Bristol-Myers Squibb, que reduce de 4-6 semanas a menos de una hora la evaluación de 10.000 compuestos; o Workday, que incorpora un agente de planificación y recorta aproximadamente un 30 % del tiempo dedicado a análisis rutinario.

El gran reto de los agentes, admite la compañía, es la imprevisibilidad y el control. Para mitigarlo, Agent Core añade dos bloques clave: Policy y Evaluations. Policy permite expresar en lenguaje natural las reglas de lo que un agente puede y no puede hacer; esas reglas se traducen a Cedar, el lenguaje de autorización de AWS, y se evalúan en milisegundos antes de ejecutar acciones o acceder a datos.

Evaluations automatiza la evaluación continua de calidad, con 13 evaluadores preconstruidos que cubren dimensiones como corrección, utilidad, seguridad, adecuación a marca o buen uso de herramientas. Los resultados se integran con CloudWatch para que las métricas de comportamiento de los agentes se vean junto a las métricas operativas tradicionales.

Infraestructura para IA: Trainium3, Graviton5 y AI Factories

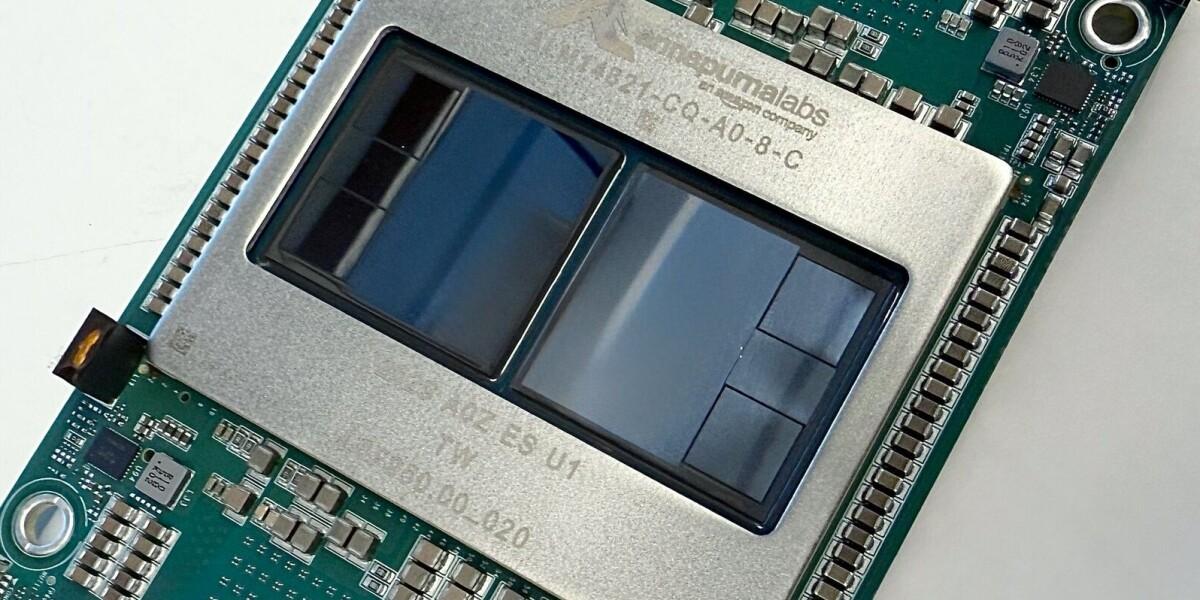

Detrás de toda esta capa de software hay un despliegue de hardware propio cada vez más agresivo. El protagonista en entrenamiento de IA es el nuevo chip Trainium3, acompañado por el sistema Trainium3 UltraServer, ambos fabricados en tecnología de 3 nanómetros y conectados mediante la red interna de alta velocidad de AWS.

Trainium3 ofrece más de cuatro veces la velocidad y cuatro veces la memoria respecto a la generación anterior, junto con una mejora de eficiencia energética de alrededor del 40 %. En un contexto donde el consumo de energía de los centros de datos de IA se dispara, este salto se convierte en un argumento clave para grandes entrenamientos.

Los UltraServers pueden escalar hasta configuraciones con alrededor de un millón de chips Trainium3, diez veces más que la capacidad previa, agrupando miles de servidores con 144 chips cada uno. Clientes como Anthropic, LLM Karakuri, SplashMusic o Decart ya han utilizado esta plataforma para reducir costes de inferencia y acelerar entrenamientos de modelos de gran tamaño.

Mirando al futuro, AWS ha confirmado que Trainium4 está en desarrollo y será compatible con NVLink Fusion, la tecnología de interconexión de Nvidia. Esto permitirá combinar GPU de Nvidia con la infraestructura de AWS, orientándose a desarrolladores que trabajan con CUDA y desean desplegar sus cargas en un entorno híbrido de alto rendimiento.

Paralelamente, el chip Graviton5 se presenta como la nueva generación de CPU generalistas, con hasta 192 núcleos, menor latencia en la comunicación entre cores (reducción en torno al 33 %) y mayor ancho de banda. AWS lo posiciona como el procesador más eficiente y potente que ha lanzado hasta la fecha para cargas de propósito general, contenedores y microservicios.

Para los clientes que necesitan soberanía de datos o regulaciones estrictas, AWS introduce AI Factories: despliegues dedicados de infraestructura de IA en centros de datos del propio cliente, operados como si fueran una región privada de AWS, con acceso tanto a Trainium como a GPU de Nvidia. Esta opción busca evitar que casos de uso sensibles se vayan a infraestructuras on-prem desconectadas de la nube.

Servicios cloud, costes y red: EKS, OpenSearch, DNS global y ahorro en bases de datos

Más allá de la IA, re:Invent 2025 también deja un buen puñado de mejoras en servicios cloud clásicos, orientadas a simplificar la operación y a reducir costes para clientes que escalan sus cargas masivamente.

En contenedores, Amazon EKS estrena nuevas capacidades de orquestación, seguridad y gestión de recursos que permiten operar clusters Kubernetes con menos esfuerzo operativo, delegando más tareas de gestión en el plano de control administrado de AWS.

En el área de búsqueda y analítica, Amazon OpenSearch Service incorpora aceleración con GPU para determinadas cargas, lo que mejora el rendimiento de consultas complejas, análisis de logs y motores de búsqueda de gran escala.

En red, aparece Amazon Route 53 Global Resolver en vista previa, un sistema DNS global para entornos híbridos que utiliza resolución anycast, simplificando la gestión de nombres y manteniendo controles de seguridad consistentes tanto en la nube como on-prem.

En almacenamiento, AWS anuncia mejoras en tablas S3 y mecanismos avanzados de replicación, orientados a reducir la latencia de acceso a datos críticos y a mejorar la resistencia frente a fallos entre regiones.

En el terreno de precios, destacan los Database Savings Plans, que permiten comprometerse a un uso constante de servicios de bases de datos durante un año a cambio de descuentos que pueden llegar aproximadamente al 35 %. Muchos clientes ven esta modalidad como un avance significativo para controlar el gasto en bases de datos gestionadas.

Agentes “de la casa”: Amazon Qwik, Amazon Connect y AWS Transform

AWS no solo ofrece herramientas para que otros creen agentes, también presenta sus propios agentes listos para usar en ámbitos corporativos clave: productividad de empleados, atención al cliente y modernización de aplicaciones legadas.

Amazon Qwik se propone como agente corporativo transversal para empleados. Combina capacidades de business intelligence, investigación profunda con citaciones y automatización de tareas diarias mediante “quick flows”. Integrando datos estructurados (BI, bases de datos) con fuentes como Microsoft 365, Jira, ServiceNow, Salesforce o repositorios en SharePoint, Google Drive y Box, Qwik aspira a convertirse en la ventanilla única para el trabajo del conocimiento dentro de la empresa.

Según AWS, cientos de miles de empleados de Amazon ya lo utilizan internamente y algunos equipos han reducido ciertas tareas a una décima parte del tiempo original, como el equipo fiscal, que consolida datos de auditoría y normativa para seguir cambios regulatorios sin escribir una sola línea de código.

En atención al cliente, Amazon Connect se reivindica como plataforma de contact center en la nube con más de 1.000 millones de dólares de run rate anual y decenas de miles de clientes. Con esta edición, Connect incorpora 29 nuevas funciones centradas en agentes autónomos, asistencia en tiempo real y analítica predictiva, reforzando la apuesta por experiencias de cliente automatizadas y personalizadas.

La pieza que completa el puzzle es AWS Transform, un servicio concebido para modernizar aplicaciones legadas y migrar entornos como mainframes, VMware o .NET a la nube. Ahora, con Transform Custom, las organizaciones pueden crear agentes de transformación de código para prácticamente cualquier tecnología, incluso aquella que solo existe dentro de la propia empresa.

Garman citó ejemplos como migraciones de Angular a React, scripts de VBA a Python o de shell scripts a Rust, con proyectos que pasan de dos semanas a tres días gracias al uso intensivo de agentes en el análisis y refactorización de código.