- Los cúbits permiten superposición y entrelazamiento, lo que multiplica exponencialmente el espacio de estados frente a los bits clásicos.

- El hardware cuántico requiere temperaturas cercanas al cero absoluto y es extremadamente sensible a la decoherencia y al ruido.

- Un ordenador clásico es imprescindible para controlar los cúbits, compilar algoritmos cuánticos, medir resultados y corregir errores.

- Computación clásica y cuántica son complementarias: la primera domina tareas generales y la segunda ciertos problemas complejos muy específicos.

Los ordenadores cuánticos se han convertido en uno de los temas más llamativos de la tecnología actual, pero cuando uno se acerca a cómo funcionan descubre enseguida que no se parecen en nada al PC o al móvil que usamos todos los días. No solo trabajan con qubits en lugar de bits, sino que además necesitan temperaturas cercanas al cero absoluto, equipos de refrigeración enormes y, muy importante, siempre van de la mano de un ordenador clásico que les sirve de cerebro de control y apoyo.

Puede sonar paradójico, pero un procesador cuántico por sí solo es poco más que un experimento de laboratorio. Para que haga algo útil hace falta que un sistema clásico se encargue de preparar los qubits, controlar las puertas cuánticas, corregir errores, recoger resultados y traducir todo ese lío de probabilidades al lenguaje binario de siempre. A lo largo de este artículo vamos a desgranar con calma qué es un cúbit, por qué el hardware cuántico necesita frío extremo, qué papel juegan la superposición, el entrelazamiento y la decoherencia, qué tipo de problemas se pretende resolver y, sobre todo, por qué sin un ordenador normal al lado todo esto no funciona.

Qué es un cúbit y en qué se diferencia de un bit clásico

En la informática de toda la vida, la unidad mínima de información es el bit, que solo puede estar en uno de dos estados mutuamente excluyentes: 0 o 1. Agrupando bits en bytes, palabras de 16, 32 o 64 bits y estructuras mayores, los ordenadores clásicos representan texto, imágenes, vídeos o lo que haga falta utilizando únicamente combinaciones de ceros y unos.

En ese contexto binario, un conjunto de n bits puede codificar hasta 2^n posibles configuraciones distintas, pero en cada instante la máquina se encuentra en una única de esas configuraciones. Es decir, el estado interno de la memoria o de los registros de la CPU es determinista: una combinación concreta de 0 y 1 que cambia paso a paso según las puertas lógicas clásicas que se van ejecutando.

En ese contexto binario, un conjunto de n bits puede codificar hasta 2^n posibles configuraciones distintas, pero en cada instante la máquina se encuentra en una única de esas configuraciones. Es decir, el estado interno de la memoria o de los registros de la CPU es determinista: una combinación concreta de 0 y 1 que cambia paso a paso según las puertas lógicas clásicas que se van ejecutando.

En computación cuántica la película cambia por completo. El cúbit, o qubit, es la unidad de información cuántica y no está limitado a ser solo 0 o solo 1. Un cúbit puede encontrarse en una superposición de los estados |0⟩ y |1⟩ al mismo tiempo, con un cierto peso (amplitud de probabilidad) asociado a cada uno. Eso significa que, antes de medirlo, el cúbit no «elige» entre 0 y 1, sino que participa de ambos con distinta probabilidad.

Cuando pasamos de un cúbit a n cúbits, el estado del sistema deja de describirse como una simple lista de n valores y se convierte en un objeto matemático que combina todas las posibles cadenas de n ceros y unos. Cada una tiene asociada su propia probabilidad y el conjunto forma un estado cuántico de tamaño 2^n. Por eso se dice que un registro de n cúbits codifica mucha más información potencial que n bits clásicos.

Esta diferencia tiene una consecuencia brutal: si en un ordenador tradicional añadir un bit incrementa la capacidad de codificación de manera lineal, en un procesador cuántico añadir un cúbit hace que el espacio de estados posibles se duplique de golpe (de 2^n a 2^(n+1)). Ese crecimiento exponencial es el origen del potencial de la computación cuántica… y también de su complejidad.

Estados cuánticos, espín y puertas lógicas cuánticas

Detrás de un cúbit real hay un sistema físico concreto: puede ser el espín de un electrón, el estado energético de un ión atrapado, niveles de energía en circuitos superconductores o incluso modos de luz en un circuito fotónico. El estado cuántico se describe matemáticamente mediante vectores y amplitudes complejas, pero para entender la idea general basta con quedarse con que hablamos de probabilidades y superposición.

El principio de superposición nos dice que un sistema cuántico puede estar simultáneamente en varios estados posibles, cada uno ponderado por una probabilidad. Cuando trasladamos esto a un procesador cuántico, un único estado interno combina todas las colecciones posibles de n ceros y unos. Las probabilidades cambian cuando aplicamos puertas cuánticas, que son las operaciones básicas de cálculo en este tipo de máquinas.

En un ordenador clásico trabajamos con puertas AND, OR, NOT, NAND, NOR, XOR o XNOR, que se implementan con transistores y calculan salidas binarias claras a partir de entradas binarias. Estas puertas son suficientes para construir sumadores, comparadores, multiplexores, registros y, en general, cualquier circuito lógico digital que te puedas imaginar.

En computación cuántica también se usan puertas, pero su naturaleza es distinta. Puertas como Hadamard, Pauli-X, CNOT, Toffoli o SWAP se representan como matrices unitarias que actúan sobre el vector de estado cuántico. Al multiplicar la matriz de la puerta por el vector de estado, se obtiene un nuevo estado donde han cambiado las probabilidades de cada configuración posible de los cúbits.

Un algoritmo cuántico no es más que una secuencia ordenada de puertas lógicas cuánticas aplicada a un conjunto de cúbits preparados en un estado inicial, normalmente bien controlado. La cadena de operaciones modifica el estado del sistema hasta que, llegado un punto, realizamos una medición y el resultado se colapsa a una configuración clásica concreta de 0 y 1 que el ordenador normal puede interpretar.

Superposición, entrelazamiento y decoherencia: las reglas del juego cuántico

La superposición no viene sola. Otra propiedad clave de los sistemas cuánticos es el entrelazamiento, una correlación profunda entre cúbits que no tiene equivalente directo en la física clásica. Cuando dos o más cúbits están entrelazados, su estado ya no se puede describir por separado; forman parte de un único sistema cuántico global.

Si mides uno de los cúbits entrelazados, el resultado condiciona instantáneamente el estado del resto, da igual que estén separados unos centímetros o a años luz. Esa correlación instantánea fue precisamente lo que hizo que Einstein hablase de una “acción fantasmagórica a distancia”, aunque hoy sabemos que no permite enviar información más rápido que la luz y está perfectamente encajada en la teoría cuántica.

En el contexto de los ordenadores cuánticos, el entrelazamiento es un recurso fundamental que permite que determinados algoritmos exploren el espacio de soluciones de forma mucho más eficiente que cualquier máquina clásica conocida. Sin entrelazamiento, muchos de los supuestos beneficios de la computación cuántica se desvanecen.

El problema es que tanto la superposición como el entrelazamiento son extremadamente frágiles. Cualquier interacción no controlada con el entorno —vibraciones, campos electromagnéticos, radiación, calor— hace que el sistema pierda su carácter cuántico y empiece a comportarse como un sistema clásico. A este proceso se le llama decoherencia cuántica.

Cuando aparece la decoherencia, las amplitudes de probabilidad que describen el estado del sistema se «desordenan» y la máquina pierde sus ventajas cuánticas. Los cúbits dejan de comportarse como superposiciones coherentes y pasan a parecerse a bits ruidosos, arruinando el cálculo. Por eso la lucha contra la decoherencia es el gran caballo de batalla del hardware cuántico actual.

Por qué los ordenadores cuánticos necesitan frío extremo

Una de las cosas que más llama la atención al ver un ordenador cuántico real es su aspecto: nada que ver con una torre de PC. Suelen ser estructuras cilíndricas llenas de cables, placas y “pisos” metálicos, suspendidas dentro de grandes cámaras y rodeadas de equipos de refrigeración masivos. Todo este despliegue existe para mantener a raya el ruido térmico y otras perturbaciones ambientales.

Para limitar al máximo la decoherencia, muchos de los diseños actuales usan cúbits superconductores. Estos aprovechan materiales que, a temperaturas extremadamente bajas, conducen la electricidad sin resistencia y permiten manipular estados cuánticos con cierta estabilidad. El precio a pagar es tener que enfriar el chip hasta temperaturas del orden de milikelvin.

Los ordenadores cuánticos de empresas como IBM, Google o Intel trabajan en rangos en torno a los 20 milikelvin, muy cerca de los -273 °C, es decir, a una fracción de grado del cero absoluto (0 K). Llegar ahí exige complejos refrigeradores de dilución, capas de aislamiento térmico, blindajes magnéticos y un diseño extremadamente cuidadoso de cada conexión que llega hasta el chip de cúbits.

En este entorno casi congelado, la energía interna del sistema se reduce al mínimo y muchas fuentes de ruido se atenúan drásticamente. Aun así, incluso en el cero absoluto ideal seguiría existiendo la llamada energía del punto cero, una energía residual impuesta por la propia mecánica cuántica, así que el reto nunca desaparece del todo.

Todo ese «armario» criogénico es el responsable del aspecto tan extraño que tienen los ordenadores cuánticos en las fotos. En realidad, el procesador cuántico es un chip diminuto alojado en el nivel más frío del montaje; el resto son sistemas de soporte necesarios para que los cúbits sobrevivan el tiempo suficiente como para realizar unas cuantas operaciones útiles.

Por qué un ordenador cuántico necesita un ordenador normal para funcionar

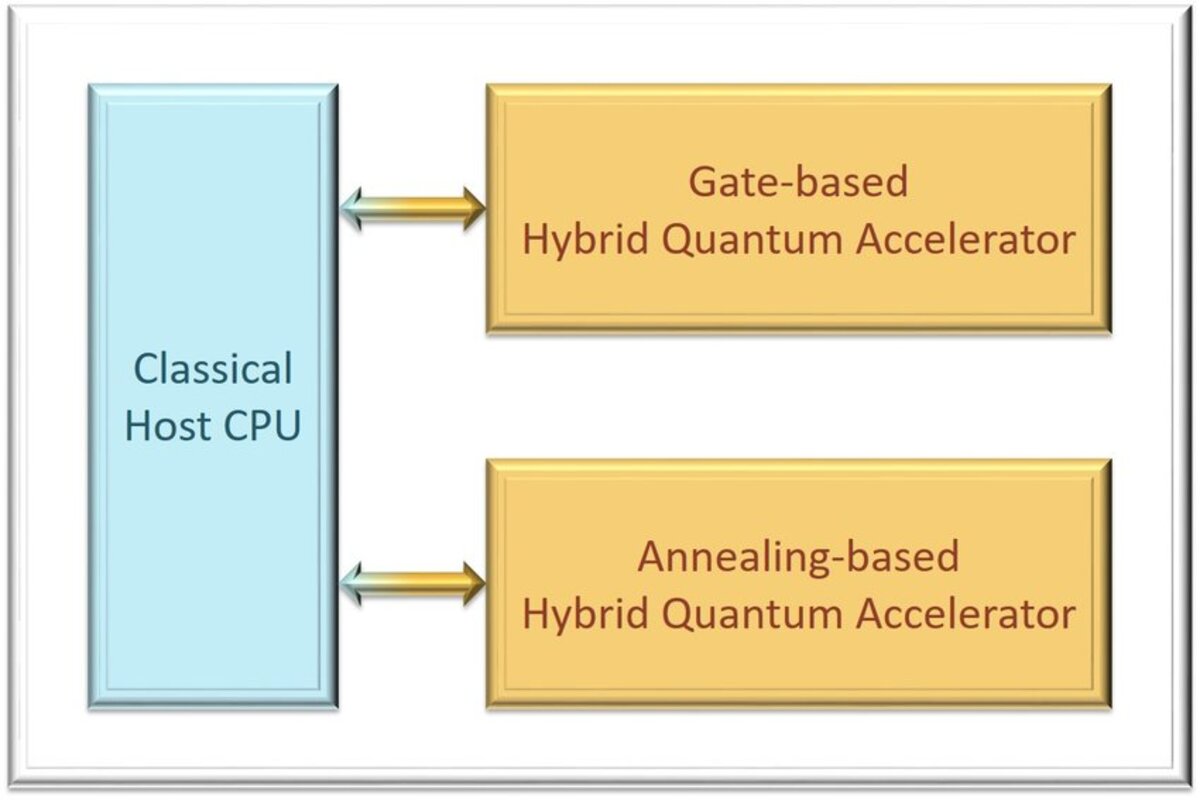

Con ese panorama, resulta fácil ver que un procesador cuántico no es un sistema autónomo. Para que funcione se necesita una arquitectura híbrida donde un ordenador clásico actúa como cerebro de control que coordina todo lo que ocurre en el chip de cúbits. Sin esa parte clásica, el dispositivo cuántico sería incapaz de hacer nada práctico.

En primer lugar, es el ordenador clásico el que calcula y genera las señales de control —pulsos de microondas, campos eléctricos, secuencias de timing— que se envían a los cúbits para implementar las puertas lógicas cuánticas deseadas. Estas señales deben ser extremadamente precisas en tiempo, frecuencia y amplitud, y su planificación se hace mediante software clásico y electrónica de control tradicional.

En segundo lugar, la programación cuántica no se hace directamente “hablando” con los cúbits, sino que el usuario escribe código en un lenguaje de alto nivel (como Qiskit, Cirq o similares) en un entorno clásico. Ese código se compila y se traduce a un conjunto de puertas cuánticas elementales, optimizadas para el hardware concreto disponible. Todo ese proceso de compilación y optimización es clásico, igual que pasa cuando programas para una CPU normal.

En tercer lugar, la lectura de los resultados también se realiza a través de electrónica clásica. Cuando se mide un cúbit, el estado cuántico colapsa y lo que obtenemos son señales analógicas que hay que digitalizar e interpretar. El ordenador clásico se encarga de repetir el experimento muchas veces, recoger las estadísticas y reconstruir la distribución de probabilidades de las salidas, porque un solo disparo no basta para extraer información fiable en la mayoría de algoritmos.

Por último, el tratamiento posterior de los datos —corrección de errores, posprocesado, análisis de resultados, visualización— vuelve a ser puramente clásico. En la práctica, el ordenador cuántico actúa como un coprocesador extremadamente especializado que se invoca para determinadas partes del cálculo, mientras que todo lo demás (interfaz de usuario, almacenamiento, comunicaciones, lógica de aplicación) se ejecuta en ordenadores normales.

Qué problemas esperan resolver los ordenadores cuánticos

A pesar de todas las complicaciones técnicas, el interés por la computación cuántica se debe a que, en ciertos ámbitos concretos, puede ofrecer una ventaja exponencial frente a los ordenadores clásicos. No se trata de que vaya a sustituir al portátil para navegar por internet, sino de que puede marcar la diferencia en cálculos que hoy en día son prácticamente imposibles.

Un ejemplo claro es la simulación de sistemas cuánticos como moléculas, materiales complejos o procesos químicos. Un superordenador clásico puede intentar simular una molécula sencilla, pero en cuanto el número de electrones y de interacciones crece un poco, el número de configuraciones posibles explotará y ni con miles de procesadores es viable explorar todo el espacio de estados con métodos convencionales.

Los algoritmos cuánticos permiten representar estos sistemas de una forma mucho más natural, aprovechando precisamente que el procesador cuántico obedece las mismas reglas que la materia que queremos modelar. En lugar de calcular cada posibilidad por fuerza bruta, el ordenador cuántico puede imitar directamente el comportamiento del sistema físico, lo que puede acelerar enormemente el descubrimiento de nuevos fármacos, catalizadores o materiales.

Otro ámbito clásico es la criptografía. Algunos esquemas actuales, como muchos basados en RSA, se apoyan en que factorizar grandes números enteros en sus primos es inviable con ordenadores clásicos en un tiempo razonable. El algoritmo de Shor, sin embargo, demuestra teóricamente que un ordenador cuántico suficientemente grande podría factorizar números gigantes de forma eficiente, poniendo en jaque parte de la criptografía moderna.

Más allá de química y criptografía, se investiga en aplicaciones para optimización, inteligencia artificial, aprendizaje automático y problemas de búsqueda compleja, donde la capacidad de explorar muchas configuraciones de forma paralela puede proporcionar una ventaja significativa. A día de hoy, sin embargo, los algoritmos maduros son aún pocos y muchos resultados se obtienen en simuladores cuánticos que corren, una vez más, en ordenadores clásicos.

Qué es la supremacía cuántica y qué se ha logrado hasta ahora

Cuando se habla de «supremacía cuántica» se hace referencia al momento en que un ordenador cuántico es capaz de resolver en la práctica una tarea concreta más rápido que cualquier superordenador clásico disponible, de tal manera que el tiempo que necesitaría una máquina clásica se considera inasumible.

Google anunció hace unos años que su procesador Sycamore, con 53 cúbits superconductores, había logrado en unos 200 segundos una tarea relacionada con la generación de números pseudoaleatorios que, según sus cálculos, un superordenador clásico tardaría miles de años en reproducir con métodos directos. En su experimento, el estado del procesador tiene un tamaño efectivo de 2^53 configuraciones posibles, algo fuera del alcance de una simulación ingenua.

Los investigadores utilizaron un generador de números pseudoaleatorios precisamente porque se trata de un problema sin una estructura simple aprovechable para hacer atajos clásicos agresivos. Es decir, buscaban algo que obligase realmente al superordenador a recorrer un espacio de estados enorme sin demasiadas trampas, maximizando así la ventaja potencial del hardware cuántico.

Para comprobar que Sycamore estaba funcionando correctamente recurrieron a una técnica llamada prueba de entropía cruzada, que compara la frecuencia experimental de las salidas del ordenador cuántico con la distribución de probabilidades calculada mediante simulación clásica para tamaños más pequeños. De esta forma podían validar que el procesador no estaba devolviendo basura aleatoria, sino siguiendo la distribución esperada.

En paralelo, un equipo chino liderado por Jian-Wei Pan alcanzó un hito similar utilizando un enfoque completamente distinto: un sistema óptico cuántico donde los fotones se mueven a través de un circuito complejo y generan distribuciones de probabilidad muy difíciles de simular. Estas experiencias muestran que la supremacía cuántica no es exclusiva de una única tecnología y que existen caminos muy variados para llegar a máquinas cuánticas útiles.

Retos técnicos: cúbits de calidad, corrección de errores y escalabilidad

Los prototipos actuales trabajan normalmente con pocas decenas de cúbits físicos y sufren tasas de error relativamente altas. Para que un ordenador cuántico sea claramente superior a los mejores superordenadores clásicos en problemas de interés práctico, expertos como James Clarke (Intel) estiman que hará falta del orden de mil cúbits de buena calidad, probablemente organizados en estructuras de corrección de errores.

La corrección de errores cuánticos es uno de los problemas más duros del campo. Los cúbits son sensibles a perturbaciones mínimas y el espacio de estados es tan enorme que detectar y corregir fallos sin destruir la información cuántica es extremadamente complicado. Se están proponiendo códigos cuánticos y esquemas que agrupan muchos cúbits físicos para formar un solo cúbit lógico más robusto, a costa de una gran sobrecarga de recursos.

Además, controlar con precisión un número creciente de cúbits requiere desarrollar electrónica y arquitectura específicas: generadores de pulsos, matrices de conmutación, procesadores de control cuántico, compiladores que tengan en cuenta las limitaciones físicas del hardware y el acoplamiento entre cúbits, etc. A medida que sube el número de cúbits, el cableado, la refrigeración y la sincronización se vuelven mucho más complicados.

Todo esto refuerza aún más la dependencia de los ordenadores cuánticos respecto a sistemas clásicos. No solo el procesador cuántico no puede trabajar sin una máquina tradicional que lo dirija, sino que el diseño de nuevas arquitecturas, la búsqueda de algoritmos eficientes y la propia experimentación se apoyan constantemente en simulaciones y herramientas que corren en superordenadores clásicos.

Aunque nombres como IBM, Intel, Google, Honeywell o Microsoft encabezan los titulares, también hay centros de supercomputación nacionales que empiezan a integrar procesadores cuánticos como aceleradores especializados dentro de sus infraestructuras, tratándolos como un recurso más dentro de un ecosistema de cómputo heterogéneo.

Relación entre computación clásica y cuántica: complementarias, no rivales

Con todo lo anterior sobre la mesa, se entiende mejor por qué casi nadie en la comunidad científica seria piensa que el ordenador cuántico vaya a sustituir al ordenador clásico en el día a día. Lo razonable es que ambos tipos de computación coexistan y se complementen, aprovechando cada uno sus puntos fuertes.

La computación clásica seguirá siendo imbatible en tareas generales: sistemas operativos, interfaces gráficas, navegación web, gestión de bases de datos, videojuegos, ofimática, redes sociales y, en general, todo lo que no requiera explorar espacios de estados astronómicos. Es un terreno donde las arquitecturas binarias y los procesadores multi-núcleo actuales ya son extremadamente eficientes.

La computación cuántica, por su lado, se reservará para problemas muy concretos en los que su capacidad para manejar superposición y entrelazamiento pueda reducir tiempos de cálculo de años a horas. En la práctica funcionará como un servicio remoto o un acelerador al que un programa clásico delega ciertas partes del trabajo, de forma parecida a cómo hoy una CPU envía tareas gráficas a una GPU.

De hecho, incluso a corto plazo, los dispositivos cuánticos con unas decenas o un centenar de cúbits pueden resultar muy valiosos como bancos de pruebas para nuevos algoritmos y técnicas de corrección de errores, aunque todavía no resuelvan problemas de impacto directo para el usuario final. Los plazos que manejan muchos expertos sitúan un uso realmente transformador de la computación cuántica a escala de más de una década.

Mientras tanto, seguiremos viendo avances graduales en número de cúbits, calidad de los mismos, reducción de errores y mejoras en la integración con infraestructuras clásicas. En paralelo, se está impulsando el desarrollo de criptografía postcuántica para anticiparse al día en que existan máquinas capaces de romper ciertos esquemas actuales de cifrado, de modo que nuestros datos sigan estando protegidos.

Tras todo este recorrido se entiende mucho mejor por qué los ordenadores cuánticos necesitan sí o sí un ordenador normal a su lado: el hardware cuántico es un coprocesador extremadamente delicado que hay que enfriar casi al cero absoluto, controlar con una electrónica clásica complejísima, programar desde lenguajes que se ejecutan en PCs corrientes y validar mediante simulaciones clásicas, de manera que la computación cuántica y la clásica avanzan unidas como dos caras de la misma moneda tecnológica.