- ClusterMAX 2.0 es un estándar que evalúa nubes de IA en cinco ejes críticos: seguridad, almacenamiento, orquestación, fiabilidad y disponibilidad real de GPU.

- CoreWeave es el único proveedor con rating Platinum ClusterMAX™, gracias a su enfoque en seguridad específica GPU/InfiniBand, almacenamiento de alto rendimiento y orquestación Slurm sobre Kubernetes.

- Métricas como MFU y goodput determinan el coste efectivo de entrenar modelos de IA, y estructuras bien diseñadas pueden mejorar notablemente la eficiencia frente a nubes generalistas.

- La combinación de clústeres de GPU avanzados, GPUs NVIDIA modernas y herramientas como Slurm y Kubernetes configura la base de las infraestructuras de IA de nueva generación.

La carrera por crear la mejor infraestructura de nube para inteligencia artificial ya no va solo de acumular TFLOPs ni de presumir del último modelo de GPU. Ahora el foco está en quién es capaz de servir clústeres masivos de GPU con alta eficiencia, aislar bien a los clientes, orquestar miles de nodos sin dramas y mantener la estabilidad cuando se dispara la demanda. En ese escenario, el estándar ClusterMAX 2.0 se ha convertido en una referencia para separar el humo de las nubes que realmente rinden.

Dentro de este marco de evaluación, CoreWeave se ha colocado en el escaparate al lograr la distinción Platinum ClusterMAX™, el nivel más alto del sistema de rating definido por SemiAnalysis. Este sello no solo reconoce que tienen GPUs punteras; indica que su plataforma está diseñada de arriba abajo para entrenar y desplegar modelos de IA a gran escala con buena utilización, seguridad ajustada a entornos GPU/InfiniBand y una operación robusta donde los fallos se gestionan sin drama.

Qué es el estándar ClusterMAX 2.0 y por qué se ha vuelto tan relevante

ClusterMAX™ es un marco de evaluación de nubes orientado a IA y HPC que valora si un proveedor es capaz de soportar cargas de entrenamiento e inferencia masivas de forma fiable. No se limita a contar cuántas GPUs hay en los racks, sino que analiza si el proveedor domina las piezas clave del puzzle: seguridad, almacenamiento, orquestación, fiabilidad y disponibilidad de recursos a gran escala.

La versión ClusterMAX 2.0 refina esa metodología incorporando tanto pruebas independientes como la experiencia real de clientes que trabajan con clústeres enormes. El objetivo es ver si, en la práctica, la infraestructura mantiene altos niveles de utilización de GPU, gestiona fallos de hardware y red sin tirar entrenamientos a la basura y ofrece garantías de aislamiento entre inquilinos, algo crítico en entornos multiempresa.

El nivel Platino solo se otorga a proveedores que destacan de forma consistente en todas las dimensiones evaluadas: desde políticas de seguridad muy finas hasta la calidad de los servicios gestionados de Slurm y Kubernetes, pasando por la madurez del almacenamiento y el soporte de clústeres con las GPUs más nuevas. No vale con tener tarjetas Blackwell en catálogo si luego no hay stock, el almacenamiento se ahoga o el scheduler hace aguas.

De hecho, esta clasificación pone el acento en algo que a menudo se pasa por alto: en un entorno de IA a gran escala, la métrica clave no es solo el coste por hora de GPU, sino la capacidad de arrancar entrenos rápido, sostenerlos durante semanas y conseguir una alta Model FLOP Utilization (MFU), es decir, que los FLOPs teóricos de la GPU se traduzcan en trabajo útil, sin que el cluster esté medio parado esperando datos o sincronizaciones.

Dimensiones que mide ClusterMAX™: seguridad, almacenamiento, orquestación, fiabilidad y disponibilidad

Uno de los puntos fuertes del estándar ClusterMAX 2.0 es que aborda la infraestructura de IA como un sistema completo, no como un conjunto de piezas sueltas. Por eso agrupa su evaluación en cinco grandes frentes que, juntos, determinan si un proveedor es realmente apto para entrenamientos de gran escala.

En el eje de seguridad, se examinan aspectos como el aislamiento de redes (por ejemplo, VPC dedicadas), el pentesting específico en capas GPU/InfiniBand y la capacidad de detectar amenazas en tiempo real. La razón es sencilla: cuando pasas de entornos monolíticos a clústeres compartidos y multi-inquilino conectados por redes de muy baja latencia, el modelo de amenaza cambia por completo.

En almacenamiento, el foco está en si el subsistema de datos puede seguir el ritmo de GPUs de última generación. Tecnologías como CAIOS y LOTA se valoran por su rendimiento y escalabilidad, porque en un entrenamiento distribuido a gran escala el cuello de botella suele estar en los I/O: si el sistema de ficheros no entrega los datos a tiempo, el MFU se desploma y el coste efectivo por época se dispara.

La parte de orquestación analiza la madurez de las soluciones basadas en Slurm y Kubernetes. ClusterMAX no se conforma con ver si hay un K8s genérico; se fija en si existen integraciones específicas como SUNK (Slurm on Kubernetes) y servicios como el CoreWeave Kubernetes Service (CKS), que mezclan lo mejor del mundo HPC y cloud-native para gestionar jobs distribuidos con afinidad GPU/InfiniBand, gang scheduling, colas avanzadas y servicios auxiliares.

En cuanto a fiabilidad y disponibilidad, el estándar valora características como los health checks activos y pasivos, la reparación automática de nodos, la facilidad para recuperar entrenos tras fallos y, muy importante, la capacidad de ofrecer clústeres basados en GPUs de última generación (como GB200 o GB300 de NVIDIA, con CPU Grace + GPU Blackwell) de forma real y no solo en una nota de prensa.

CoreWeave y el nivel Platinum: en qué se diferencia del resto

Según la evaluación ClusterMAX 2.0 de SemiAnalysis, CoreWeave es, a día de hoy, el único proveedor que cumple con los requisitos del nivel Platinum. Esto no significa que el resto de nubes sean malas, sino que CoreWeave ha conseguido juntar en una sola plataforma una serie de elementos que, juntos, marcan la diferencia cuando hablamos de IA masiva.

En el apartado de seguridad, el informe destaca el enfoque específico sobre entornos GPU/InfiniBand: hay pentesting orientado a estas capas, políticas finas de segmentación en VPC y sistemas de detección de amenazas en tiempo real adaptados a tráfico de alto rendimiento. No se trata solo de pasar un checklist de compliance, sino de reforzar los puntos flacos que aparecen cuando se comparten redes de baja latencia entre varios tenants.

En almacenamiento, los sistemas CAIOS y LOTA reciben una mención específica por su capacidad para sostener altas tasas de lectura/escritura con muchos nodos en paralelo sin que el rendimiento se venga abajo. Esto es clave para mantener una Model FLOP Utilization (MFU) alta y evitar que las GPUs estén esperando a que el sistema de ficheros “despierte”.

La orquestación es otro de los puntos donde CoreWeave brilla, gracias a su combinación de SUNK (Slurm on Kubernetes) y el servicio CKS. Esta capa permite a los equipos que ya están acostumbrados a Slurm seguir usando su tooling y sus scripts, pero encima se benefician de toda la parte cloud-native de Kubernetes: despliegue de servicios auxiliares, observabilidad, seguridad, autoscaling de componentes no críticos de entrenamiento, etc.

En fiabilidad, la plataforma implementa health checks avanzados y automatizaciones para reemplazo de nodos defectuosos y recuperación frente a fallos. Cuando se está entrenando un modelo durante semanas con cientos de GPUs, la auto-curación pesa tanto como el uptime del datacenter, porque cualquier bug, tarjeta que se cae o enlace que falla puede tirar abajo un job entero si no hay mecanismos de resiliencia.

Por último, en el capítulo de disponibilidad, CoreWeave no solo anuncia soporte para GPUs como GB200 y GB300, sino que ha demostrado despliegues reales a escala con estos aceleradores. Esto indica que tienen capacidad de cómputo puntera aprovisionada y accesible para clientes, algo que, a menudo, los hiperescaladores tardan en poder ofrecer sin colas largas o restricciones fuertes.

MFU y goodput: las métricas que mandan en la factura de IA

Cuando hablamos de eficiencia en infraestructuras de IA, dos conceptos salen continuamente: MFU (Model FLOP Utilization) y goodput. Son métricas menos “marketineras” que los TFLOPs pero mucho más cercanas a la forma en la que se calcula, de verdad, el coste total de entrenar un modelo grande.

La MFU mide el porcentaje de los FLOPs teóricos de una GPU que se usan en operaciones útiles del modelo, dejando fuera tiempos muertos por culpa del I/O, sincronizaciones entre nodos o burbujas en el pipeline. Un clúster mal diseñado puede tener GPUs de gama alta y, aun así, quedarse en MFUs mediocres porque el almacenamiento o la interconexión no dan para más.

El goodput, por su parte, es una métrica de trabajo útil frente a recursos consumidos, abarcando la eficiencia de extremo a extremo: desde cómo se cargan los datos hasta cómo se gestionan reintentos, checkpoints y fallos. Un goodput del 96 % indica que casi todo lo que se paga en GPU/hora se traduce en progreso real de entrenamiento, sin pérdidas excesivas por caídas o esperas.

CoreWeave afirma que su infraestructura permite alcanzar hasta un 20 % más de MFU y cerca de un 96 % de goodput en determinados escenarios. Esto se puede traducir en semanas de entrenamiento ahorradas o, si lo miramos desde el CFO, en millones de dólares menos en la factura de cómputo. Ahora bien, estas cifras son orientativas, porque dependen del modelo, el tamaño, la topología de cluster, el framework usado y la higiene del pipeline.

Para cualquier equipo de IA serio, la recomendación lógica es realizar POC con sus propios workloads, con KPIs claros de MFU y goodput, antes de tomar decisiones a largo plazo. El estándar ClusterMAX™ puede servir como brújula inicial, pero el test definitivo siempre son los jobs reales en producción.

Slurm sobre Kubernetes (SUNK): puente entre HPC clásico y cloud-native

En muchos laboratorios y empresas con tradición en HPC, la herramienta estándar para gestionar colas y recursos es Slurm. En paralelo, el mundo cloud se ha organizado en torno a Kubernetes como capa de orquestación para contenedores y servicios. El enfoque de CoreWeave con SUNK (Slurm on Kubernetes) intenta combinar ambos mundos sin obligar a los equipos a cambiarlo todo.

Por un lado, Slurm se sigue utilizando para lo que mejor sabe hacer: programar jobs distribuidos con afinidades muy finas (GPU, InfiniBand, nodos concretos), aplicar gang scheduling (todos los recursos a la vez o ninguno), y mantener políticas de colas tipo HPC con prioridades, reservas y límites por usuario o proyecto.

Por otro, Kubernetes entra como capa para servicios auxiliares y el plano de control: monitorización, logging, componentes de MLOps, APIs internas, herramientas de experiment tracking tipo Weights & Biases, pipelines CI/CD, etc. Esta separación permite que el plano de entrenamiento no se vea lastrado por microservicios, pero al mismo tiempo facilita operar con una mentalidad cloud-native.

El valor práctico de SUNK es claro para equipos de investigación o MLOps que ya dominan Slurm y no quieren reescribir su tooling para pasar a un scheduler nuevo. La capa gestionada de CoreWeave actúa como atajo operativo, permitiendo mover cargas HPC tradicionales a la nube sin volver a reinventar la rueda.

Seguridad y cumplimiento en clústeres de GPU: mucho más que un checklist

A medida que las empresas migran entrenos sensibles a la nube, la seguridad específica de entornos GPU/InfiniBand se vuelve un tema crítico. El informe relacionado con ClusterMAX 2.0 pone el foco en prácticas como el pentesting especializado en redes de baja latencia y en el refuerzo del aislamiento entre tenants que comparten infraestructura física.

En estos entornos, los controles de segmentación a nivel de VPC, la telemetría en tiempo real y las políticas estrictas de acceso se sitúan al mismo nivel de importancia que el cifrado en reposo o el SSO en los paneles de gestión. Cuando varios clientes comparten clusters masivos con InfiniBand o NVLink, cualquier mala práctica en la separación puede convertirse en un vector de ataque poco evidente para equipos que vienen del mundo más clásico web o enterprise.

ClusterMAX™ valora que exista una postura de seguridad coherente en todos los niveles: desde el diseño del datacenter hasta la gestión de claves (KMS), pasando por auditorías externas y pruebas recurrentes. En el caso de CoreWeave, la combinación de controles endurecidos, pentesting orientado a infra de IA y monitoreo continuo es uno de los factores que le han ayudado a situarse en el rango Platino.

Comparativa: nubes especializadas frente a hiperescaladores generalistas

El hecho de que CoreWeave haya obtenido el Platinum ClusterMAX™ no implica que AWS, Azure o Google Cloud queden fuera de juego. Lo que revela es que hay espacio para nubes especializadas en IA que priorizan la optimización de principio a fin (GPU, red, almacenamiento, scheduler) frente a la amplitud de catálogo y la presencia global.

En muchos casos de uso, una nube especializada puede ofrecer mejor MFU, goodput y tiempos de arranque que un hiperescalador genérico, especialmente en entrenamientos de gran escala y inferencia de alto rendimiento. La razón es que toda la infraestructura está diseñada alrededor de las necesidades de IA, sin la inercia de tener que soportar miles de servicios distintos.

Por el otro lado, los hiperescaladores siguen destacando por su escala global, ecosistema de servicios de datos, analítica, seguridad avanzada y herramientas DevOps. Muchos acuerdos marco empresariales, integración con sistemas corporativos y presencia en múltiples regiones hacen que, en la práctica, la elección de proveedor no sea binaria.

Lo que se está viendo en cada vez más organizaciones es una aproximación multicloud: mantener los datos y ciertos servicios en un hiperescalador, mientras que los entrenos de IA más pesados se derivan a una nube especializada cuando hace falta capacidad de cómputo de última generación, mejor MFU o colas más cortas para conseguir GPUs punteras.

Qué deberían evaluar los equipos de IA y MLOps al elegir infraestructura

Para equipos técnicos que se plantean dónde entrenar sus modelos, el estándar ClusterMAX 2.0 sirve como guía para identificar los factores que de verdad mueven la aguja. Más allá del precio por hora de GPU, hay varias preguntas que conviene hacerse al comparar proveedores.

La primera es el tiempo de cola frente a los SLA de entrega: no importa que una GPU salga barata si el entrenamiento arranca con días de retraso o se interrumpe de forma recurrente. Conviene mirar cuántos reinicios, caídas e incidencias se asumen de media en un proyecto típico.

Otro aspecto clave es la topología de red y las tecnologías de interconexión ofrecidas: InfiniBand, NVLink o Ethernet de muy alta velocidad. Es esencial pedir datos sobre ancho de banda y latencia sostenidos para tamaños de modelo y número de nodos similares a los que se quiere utilizar.

En el plano del almacenamiento de alto rendimiento, hay que verificar si sistemas como CAIOS/LOTA (o sus equivalentes en otros proveedores) se ajustan al patrón de I/O del pipeline: lectura distribuida de datos, checkpoints frecuentes, shuffles, etc. Un diseño pobre del subsistema de almacenamiento hunde la MFU aunque la red y la GPU sean excelentes.

También importa mucho la orquestación: si el tooling del equipo depende de Slurm, tiene sentido comprobar el grado de madurez de soluciones tipo SUNK: plugins, comportamiento ante colas saturadas, políticas de pre-empción, aislamiento entre jobs, etc. Y, por supuesto, las garantías de seguridad, como detalle de pentests, VPC dedicadas, integración con KMS y auditorías de terceros.

Por último, interesa conocer los roadmaps de GPUs futuras, como GB200 o GB300, y los acuerdos de disponibilidad que el proveedor está dispuesto a firmar. Para muchos proyectos, contar con acceso temprano y garantizado a estas generaciones de aceleradores pesará tanto como cualquier métrica de FLOPs teóricos.

Más allá del hierro: ecosistema, capital y servicios alrededor de la infraestructura

Un elemento que suele pasar desapercibido en los análisis puramente técnicos es el ecosistema construido alrededor de la infraestructura. En el caso de CoreWeave, la compañía no se limita a alquilar GPU: también invierte en startups a través de CoreWeave Ventures e integra herramientas de terceros que facilitan el trabajo diario de los equipos de IA.

Dentro de ese ecosistema se encuentran soluciones como Weights & Biases para el seguimiento de experimentos, OpenPipe para RL y optimización de modelos, o proyectos como Marimo, orientado a hacer más cómodo el desarrollo de modelos en Python. Además, se ha reforzado la parte de ingeniería aplicada con movimientos como la adquisición de Monolith AI, centrada en IA para física e ingeniería.

Para un laboratorio de investigación o una scale-up, disponer de cómputo potente, herramientas integradas y soporte especializado dentro del mismo ecosistema puede acelerar mucho la entrega de valor. En grandes corporaciones, en cambio, suelen pesar más el SLA formal, las garantías de seguridad y el coste total de propiedad (TCO) de todo el ciclo de vida del modelo.

Clústeres de GPU: arquitectura, componentes y papel de Nvidia

Todo el debate sobre ClusterMAX 2.0 y nubes de IA se apoya en un concepto técnico de base: el clúster de GPU. En esencia, se trata de un conjunto de nodos que integran varias tarjetas gráficas interconectadas mediante enlaces de alta velocidad como InfiniBand o NVLink, de forma que puedan funcionar como un único recurso lógico de cómputo.

Los componentes básicos de estos clústeres incluyen las propias GPU (generalmente de NVIDIA o AMD), CPU que orchestren las tareas que no son adecuadas para GPU, redes internas de baja latencia, sistemas de almacenamiento de alto rendimiento, una infraestructura de refrigeración seria y, por supuesto, la pila de software adecuada: sistemas operativos (Linux es el más habitual), drivers, bibliotecas como CUDA o cuDNN y frameworks de ML/DL tipo TensorFlow o PyTorch.

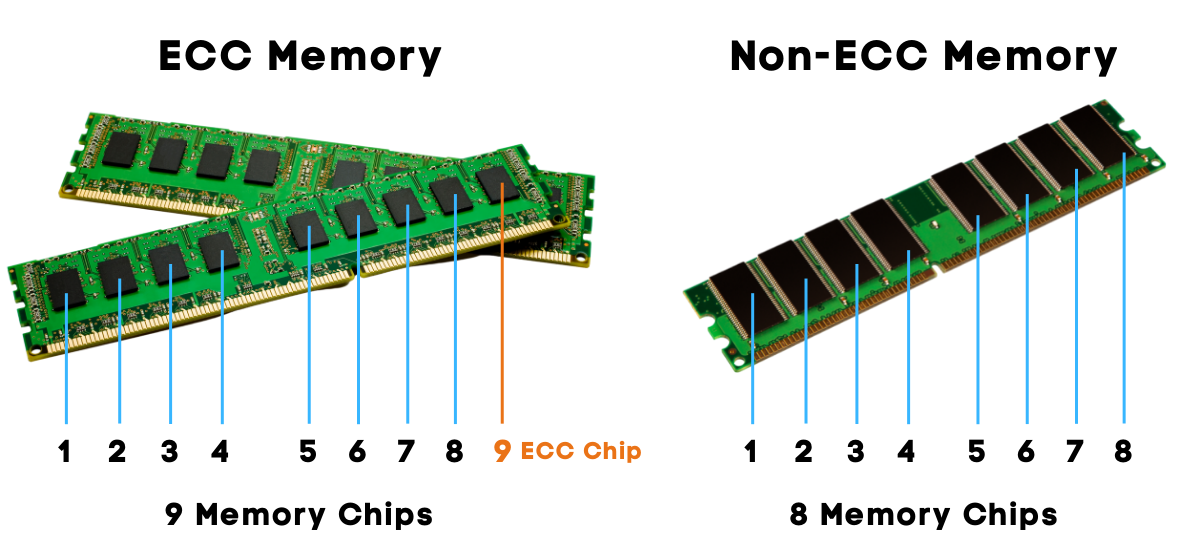

En este contexto, las arquitecturas de NVIDIA juegan un papel destacado. GPUs como la NVIDIA A40, basadas en la arquitectura Ampere, ofrecen 10 752 núcleos CUDA, 48 GB de memoria GDDR6, 336 núcleos Tensor y 84 núcleos RT, con un ancho de banda de memoria de unos 696 GB/s y soporte de memoria ECC. Este tipo de tarjetas está pensada para cargas intensivas en ciencia de datos, IA, aprendizaje profundo, renderizado e inferencia, y suele encontrarse en nodos de clúster orientados a entornos profesionales.

Cuanto más grande y complejo es el clúster, más importante se vuelve el diseño de interconexiones como InfiniBand o NVLink, que reducen la latencia y aumentan las tasas de transferencia de datos entre GPUs y nodos. Este tipo de tecnologías son fundamentales para que las simulaciones científicas, los modelos de IA gigantes y las cargas HPC no se queden atascados por problemas de red.

Buenas prácticas de gestión y software para clústeres de GPU

Para sacar partido a clústeres de GPU grandes, no basta con tener buen hardware; hay que gestionarlos con cabeza. Aquí entran en juego tanto las buenas prácticas de operación como el uso de software de gestión de clústeres más o menos especializado.

En cuanto a operación, es básico contar con sistemas de monitorización de utilización de GPU, memoria y estado del sistema, balancear las cargas de forma que no haya tarjetas saturadas y otras muertas de risa, automatizar las tareas de mantenimiento y vigilar la eficiencia de la comunicación entre nodos, sobre todo cuando se usa InfiniBand.

En la capa de software, soluciones como Slurm siguen siendo un estándar de facto en entornos HPC e IA distribuidos, gracias a su capacidad para programar trabajos, repartir recursos y tolerar fallos. En paralelo, herramientas como Kubernetes se han vuelto muy populares para gestionar servicios y, cada vez más, para manejar cargas de trabajo de GPU en contenedores.

Además, es clave mantener actualizados los drivers de GPU y configurar correctamente el toolkit CUDA, aprovechando herramientas de profiling como NVIDIA Nsight o CUDA Profiler para detectar cuellos de botella y ajustar parámetros como la capacidad de cómputo o el uso de memoria. Una configuración descuidada puede tirar por tierra las ventajas de contar con hardware de gama alta.

Todo este ecosistema de estándares como ClusterMAX 2.0, nubes especializadas tipo CoreWeave, GPUs de última generación y herramientas de orquestación como Slurm y Kubernetes está redefiniendo cómo se construyen y operan las infraestructuras para IA. Entender cómo encajan la seguridad, el almacenamiento, la orquestación, la fiabilidad, la disponibilidad y métricas como MFU o goodput permite a los equipos de IA y MLOps tomar decisiones más informadas, ajustar mejor sus presupuestos de cómputo y exprimir al máximo cada hora de GPU contratada.