- Vera Rubin integra CPU Vera + 2 GPU Rubin en un superchip con hasta 100 PFLOPS y memoria de alta velocidad.

- Hoja de ruta: Blackwell Ultra (2025), Vera Rubin NVL144 (Q2 2026) y Rubin Ultra NVL576 (H2 2027).

- Escalado a rack con NVLink6/7 y CX9: desde 50 PFLOPS FP4 por nodo a 15 ExaFLOPS FP4 en Rubin Ultra.

Si llevas tiempo oyendo campanas sobre Vera Rubin y te preguntas exactamente qué es, aquí va la respuesta corta: es el superchip con el que NVIDIA pretende redefinir la computación científica y la IA en centros de datos. La respuesta larga es mucho más jugosa, porque hablamos de un módulo que une CPU y GPU en un mismo paquete, nuevas memorias de gran ancho de banda, interconexiones ultrarrápidas y un calendario que ya marca en rojo 2026 y 2027.

No es una simple actualización: Vera Rubin es la apuesta estratégica de NVIDIA para cargas masivas como modelos de lenguaje, simulaciones climáticas o astrofísica, con un diseño pensado para escalar en racks completos. Además, el nombre rinde tributo a la astrónoma Vera Rubin, pionera en el estudio de la materia oscura, un guiño de la compañía al vínculo entre ciencia básica y progreso tecnológico.

¿Qué es NVIDIA Vera Rubin exactamente?

En su configuración estrella, el módulo integra una CPU Vera y dos GPU Rubin en un único superchip. La CPU Vera emplea 88 núcleos personalizados basados en Arm Neoverse, mientras que las GPU Rubin utilizan pilas de memoria HBM de última generación. El objetivo es claro: agrupar cómputo general y aceleración de IA/HPC con latencias mínimas y un presupuesto energético más eficiente que el de configuraciones distribuidas.

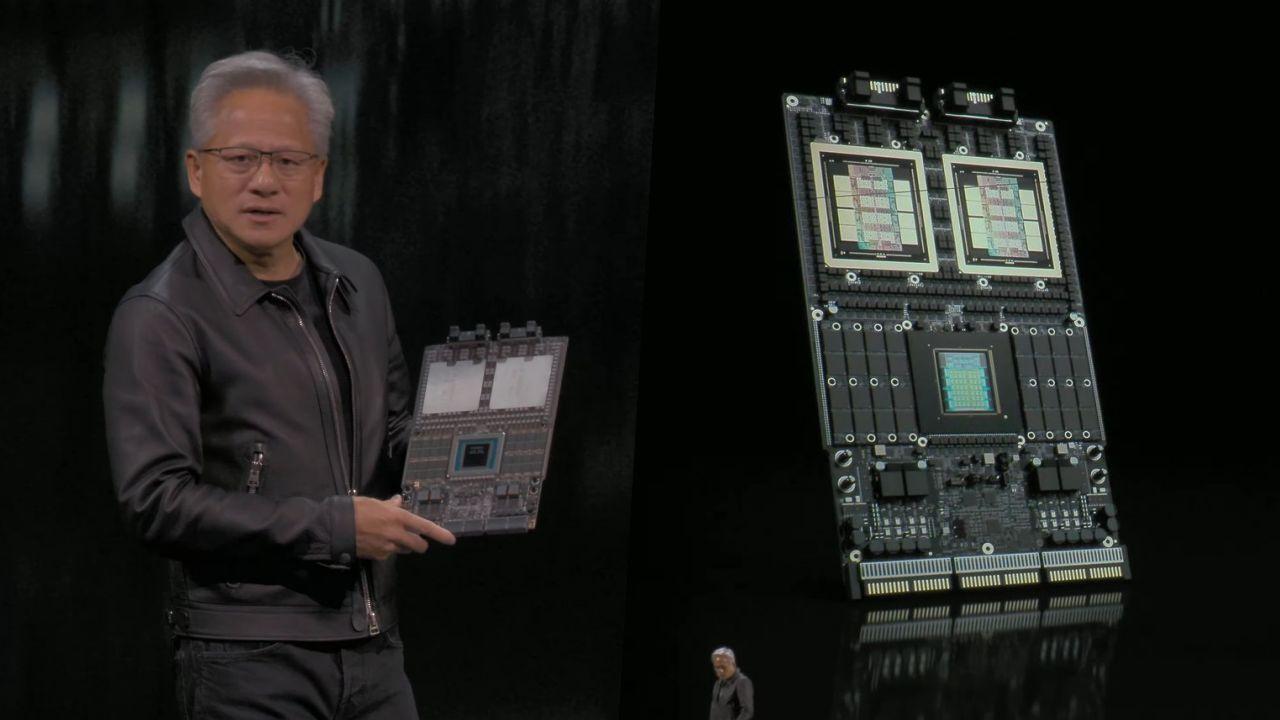

El diseño físico mostrado públicamente revela detalles poco habituales en servidores tradicionales: un acoplamiento tipo ranura sin cables que simplifica el ensamblaje y el flujo de aire, y zócalos de memoria a ambos lados de la CPU para módulos LPCAMM2/SODIMM2. Junto a las GPU, se observan múltiples posiciones para HBM, lo que permite un enorme caudal de datos cuando el módulo trabaja a plena carga.

Al hablar de antecedentes, en los primeros compases se describió el enfoque de Grace‑Blackwell como un paradigma de cómputo unificado (CPU Grace + GPU Blackwell) con promesas de hasta 30 veces más rendimiento en simulación científica y entrenamiento de IA frente a generaciones previas. Hoy, la foto actual de Vera Rubin es la combinación de CPU Vera + 2 GPU Rubin, un paso más allá que mantiene la idea de convergencia pero con una nueva generación de GPU y una CPU propia.

Calendario: de Blackwell Ultra a Rubin Ultra

NVIDIA ha marcado una hoja de ruta muy clara para evitar cuellos de botella en la demanda de IA. En primer lugar, Blackwell Ultra (GB300) llegará en el segundo semestre de 2025 con 20 PF para IA por GPU y un salto de memoria por GPU desde 192 hasta 288 GB, elevando también el ancho de banda. En despliegues DGX GB300 Superpod se habla de 288 CPUs, 576 GPUs y hasta 11,5 exaFLOPS en FP4, junto a 240–300 TB de memoria agregada.

A continuación entra en escena Vera Rubin: NVIDIA sitúa su disponibilidad en el segundo trimestre de 2026, con el paquete NVL144 como primera gran entrega para centros a gigaescala. La propia compañía detalla que este salto debe suponer más del doble de rendimiento en inferencia FP4 frente a Blackwell Ultra en clusters comparables, poniendo el foco en agentes de IA con razonamiento y planificación iterativa.

Para cerrar el trío, Rubin Ultra quedaría fijado para la segunda mitad de 2027. Esta iteración escalará aún más la memoria y la comunicación interna entre GPUs, con configuraciones que doblan el número de chips Rubin en cada módulo y un rack NVL576 de nueva generación pensado para máxima densidad.

Arquitectura y diseño del superchip

El módulo «Vera Rubin» mostrado por Jensen Huang exhibe tres pilares técnicos: CPU Vera de 88 núcleos Arm, dos matrices de GPU Rubin y un subsistema de memoria mixto. La CPU se flanquea por zócalos para memoria de baja latencia (LPCAMM2/SODIMM2), mientras que las GPU apilan HBM en torno al sustrato del paquete. Esta distribución busca maximizar el ancho de banda efectivo y reducir las pérdidas por cableado.

Uno de los cambios más llamativos es la conexión sin cables mediante ranuras entre el superchip y la base del chasis. Con ello, NVIDIA persigue simplificar el diseño mecánico, acortar recorridos eléctricos y facilitar el mantenimiento en grandes granjas. En paralelo, el diseño prepara el terreno para racks verticales tipo blade con mayores densidades.

A nivel de memoria, se han manejado varias configuraciones: en demostraciones y diapositivas se mencionan hasta 32 módulos LPDDR para la CPU Vera y 8 pilas HBM para las GPU Rubin. Según contexto y generación (Rubin frente a Rubin Ultra), los materiales públicos alternan entre HBM3/HBM3E y HBM4/HBM4e, como se detalla más abajo en la sección de matices.

Rendimiento, memoria e interconexiones

Las cifras que NVIDIA ha puesto sobre la mesa perfilan el posicionamiento de la plataforma. En módulo, el objetivo es alcanzar hasta 100 PFLOPS de cómputo de IA, alimentados por una combinación de memoria de alta velocidad que, en configuraciones completas, apunta a 2 TB totales dentro del superchip.

Donde la cosa se vuelve realmente interesante es en el ecosistema de interconexión. NVIDIA está renovando NVLink y los enlaces de red de nueva generación para que el salto no se quede en la GPU: en Rubin se habla de NVLink6 con el doble de velocidad frente a su antecesor y de un enlace CX9 con mejoras x2 respecto a CX8, mientras que Rubin Ultra eleva la apuesta con NVLink7 y relaciones de mejora que llegan a x12 en determinados caminos de datos.

Al aterrizar números concretos, las comunicaciones se mueven en ligas muy por encima del estándar de mercado: para Rubin se han citado hasta 260 TB/s vía NVLink en el módulo y 28,8 TB/s con CX9 entre racks, mientras que Rubin Ultra evolucionará a 1,5 PB/s por NVLink7 y 115,2 TB/s entre racks a través de CX9 en el diseño Kyber NVL576.

- Memoria por GPU: Blackwell Ultra sube a 288 GB; Rubin mantiene 288 GB con mayor ancho de banda efectivo; Rubin Ultra introduce HBM4e y saltos adicionales.

- Precisión y métricas: foco en FP4 para inferencia masiva y FP8 para entrenamiento, con escalas de PFLOPS/ExaFLOPS a nivel de rack.

- Ancho de banda agregado: racks NVL de nueva generación citan hasta 4,6 PB/s de HBM4e en Rubin Ultra.

Plataformas NVL y escalado en centros de datos

NVIDIA estructura su despliegue en soluciones preintegradas NVL para acelerar el time-to-value. La primera parada es Vera Rubin NVL144, que la compañía sitúa para el segundo semestre de 2026. En documentación pública se recogen dos cifras para su techo en inferencia FP4: 50 PFLOPS por nodo y, a escala de despliegue, valores de rendimiento que alcanzan 3,6 unidades en la misma métrica citadas como ExaFLOPS por unas fuentes y como PFLOPS por otras. Dada la escala del sistema, la lectura coherente es la de exaFLOPS, pero más abajo se matiza la disparidad.

Para NVL144 también se mencionan 288 GB de HBM por GPU y la CPU Vera con 88 cores/176 hilos. En entrenamiento, se han citado cifras de 1,2 ExaFLOPS FP8 en determinadas configuraciones de rack, junto con un aumento del ancho de banda de memoria de 8 a 13 TB/s en Rubin frente a su predecesor directo.

El siguiente peldaño será Rubin Ultra NVL576 en la segunda mitad de 2027, un monstruo de densidad con 4 GPU Rubin Ultra por módulo y un rack que ofrece hasta 15 ExaFLOPS FP4 para inferencia. A nivel de memoria, las especificaciones públicas hablan de 1 TB HBM4e por módulo y, a escala de rack, de 365 TB de HBM4e a 4,6 PB/s, además de un salto de x12 en velocidad con NVLink7 y x8 con CX9 (115,2 TB/s) frente a generaciones previas.

Todo ello encaja en el nuevo diseño de rack Kyber NVL576, con blades verticales y mejoras térmicas para subir la densidad por armario sin comprometer fiabilidad. NVIDIA ha comunicado que Kyber se mantendrá hasta la generación “Feynman”, dejando claro que el chasis forma parte inseparable de la propuesta de rendimiento.

Adopción temprana y casos de uso

Entre los primeros interesados figuran instituciones como el Swiss National Supercomputing Centre y el Los Alamos National Laboratory, con planes que abarcan simulaciones climáticas, astrofísica y entrenamiento de modelos de lenguaje a gran escala. Son cargas donde el ancho de banda de memoria y las interconexiones marcan la diferencia tanto como los TFLOPS puros.

El contexto explica por qué NVIDIA empuja para 2026–2027: tras el boom de la IA generativa, la demanda de GPU para IA superó con creces la de gaming y disparó sus ingresos. Mientras gigantes tecnológicos aceleraban para competir con startups como OpenAI (con ChatGPT en la cresta de la ola) o corregían tropiezos iniciales —Google Bard fue el ejemplo más sonado—, NVIDIA reorientó su hoja de ruta priorizando aceleración para entrenamiento e inferencia.

Las cifras financieras lo subrayan: la compañía ha destacado ingresos multimillonarios asociados a Blackwell y comunicó que sus cuatro principales clientes sumaron 1,1 millones de GPUs en lo que va de 2025. Jensen Huang, por su parte, ha llegado a afirmar que la industria necesitará 100 veces más potencia de cómputo de lo que se estimaba apenas un año antes para atender el crecimiento de la IA.

Ecosistema: red, DPUs y switches

Vera Rubin no viaja solo. NVIDIA ha anunciado actualizaciones de su DPU BlueField‑5, el NVLink 8 Switch y componentes de red como Spectrum7 204T (CPO) y Ethernet CX10. La idea es que las tuberías de datos a nivel de clúster no se conviertan en el cuello de botella de unos chips que, de por sí, ya mueven datos a velocidades descomunales.

También se han detallado vías de integración en plataformas DGX/GB y modos de despliegue flexibles: desde módulos individuales B300 hasta blades de ocho GPU por servidor o racks de 72 procesadores, manteniendo la posibilidad de crecer por etapas sin renunciar a la topología óptima de interconexión.

Nomenclatura y hoja de ruta futura

Si te suena lo de “Ada Lovelace”, “Turing” o “Ampere”, no es casualidad. NVIDIA bautiza sus arquitecturas con nombres de científicos célebres: Lovelace para la familia RTX 40, y a su estela Hopper y Blackwell para IA. En esta tradición, Vera Rubin reconoce a la astrónoma cuya obra fue clave para evidenciar la materia oscura.

En el mundo de consumo se barajó que la familia GeForce RTX 60 estrenaría «Rubin» en 2025, aunque la práctica de NVIDIA de espaciar lanzamientos y las prioridades del mercado de IA invitan a pensar en desplazamientos hacia 2026. Mirando más allá, la compañía ya ha adelantado que su próxima arquitectura de GPU se llamará Feynman y aparece en el calendario para 2028, manteniendo una cadencia de dos generaciones de GPU por cada generación de CPU (la CPU Vera se mantendría con Feynman).

Matices importantes: cifras y memoria

Al revisar materiales públicos verás variaciones que conviene encajar. Por ejemplo, el techo de Vera Rubin NVL144 aparece como 3,6 ExaFLOPS FP4 en unas fuentes y 3,6 PFLOPS en otras. Dado el tamaño del sistema y su posición en la gama, todo apunta a que “Exa” es la unidad correcta, y que la versión en PFLOPS responde a un desliz o a un contexto de nodo parcial, no de rack.

Lo mismo con la memoria: hay textos que adjudican a Rubin HBM4 desde el principio, mientras que otros precisan HBM3/HBM3E para Rubin y reservan HBM4/4e para Rubin Ultra. La lectura conservadora es que los primeros despliegues de Rubin arrancarán con HBM3E de alto rendimiento y que HBM4(e) será protagonista en Rubin Ultra y en configuraciones tope de gama posteriores, sin descartar variantes intermedias en función de la cadena de suministro.

En cuanto a la herencia de Grace‑Blackwell y su promesa de hasta x30 en ciencia e IA, encaja como referencia de salto generacional previa al combo CPU Vera + GPU Rubin. Es decir, Vera Rubin no parte de cero: recoge el guante de esa convergencia CPU+GPU y la lleva a un nivel superior con una CPU diseñada ex profeso y GPUs Rubin mejor acopladas al conjunto.

¿Para qué cargas sirve mejor?

Vera Rubin está orientado a escenarios donde el cuello de botella es el movimiento de datos y la latencia de comunicación entre chips: entrenar y desplegar modelos de lenguaje gigantes, IA física para simulación de mundos y robots, generación de vídeo de alta calidad a escala, o modelado climático y astrofísico con mallas finas. En esas tareas, NVLink6/7, CX9 y HBM marcan tanta o más diferencia que los TFLOPS brutos.

Para los equipos de plataforma, otro punto clave es el consumo energético por unidad de rendimiento y el espacio ocupado en el centro de datos. El enfoque «todo en un módulo» y el nuevo chasis Kyber apuntan a recortar ambos, lo que abre la puerta a densidades por rack que antes exigían redes y sistemas de refrigeración más complejos.

En suma, NVIDIA posiciona Vera Rubin como una evolución natural tras Blackwell Ultra: más memoria efectiva, enlaces mucho más rápidos y una CPU propia que saca partido a la unificación física del sistema.

Con una agenda que encadena GB300 (2025), Vera Rubin (2026) y Rubin Ultra (2027), y un horizonte ya bautizado como Feynman (2028), la compañía coloca las piezas de su puzzle de IA a varios años vista. Entre tanto, la comunidad científica y la industria dispondrán de un superchip diseñado para exprimir la convergencia CPU+GPU, con hasta 100 PFLOPS por módulo, memoria de varios terabytes por sistema y racks que empujan el listón de los exaFLOPS a la siguiente década.