- La memoria holográfica experimental almacena datos en 3D mediante patrones de interferencia láser, logrando densidades teóricas de terabytes por centímetro cúbico.

- Nuevos materiales como fotopolímeros con nanopartículas magnéticas y proteínas microbianas fotosensibles buscan abaratar y estabilizar estos sistemas.

- Aplicaciones potenciales abarcan centros de datos, archivo a largo plazo, defensa y sensores avanzados, aunque persisten retos de coste y estandarización.

- El concepto holográfico también inspira modelos del cerebro, donde la memoria y la visión se interpretan como procesos basados en patrones de ondas distribuidos.

La memoria holográfica experimental lleva décadas rondando el mundo de la ciencia ficción, pero en los últimos años se ha convertido en un campo de investigación muy serio en universidades, laboratorios y grandes empresas tecnológicas. No solo aspira a multiplicar la capacidad de almacenamiento, sino también a cambiar la forma en la que entendemos la memoria digital, el procesamiento de la información e incluso el funcionamiento del propio cerebro.

Hoy en día convivimos con discos duros, SSD, memorias flash y medios ópticos, todos basados en almacenar bits sobre superficies bidimensionales. La memoria holográfica, sin embargo, juega en otra liga: graba datos en todo el volumen de un material y puede leer enormes bloques de información de forma paralela usando luz láser. A partir de los estudios más recientes y de distintos enfoques experimentales, vamos a desgranar qué es, cómo funciona, qué avances se han logrado y hacia dónde apunta esta tecnología.

Qué es realmente la memoria holográfica

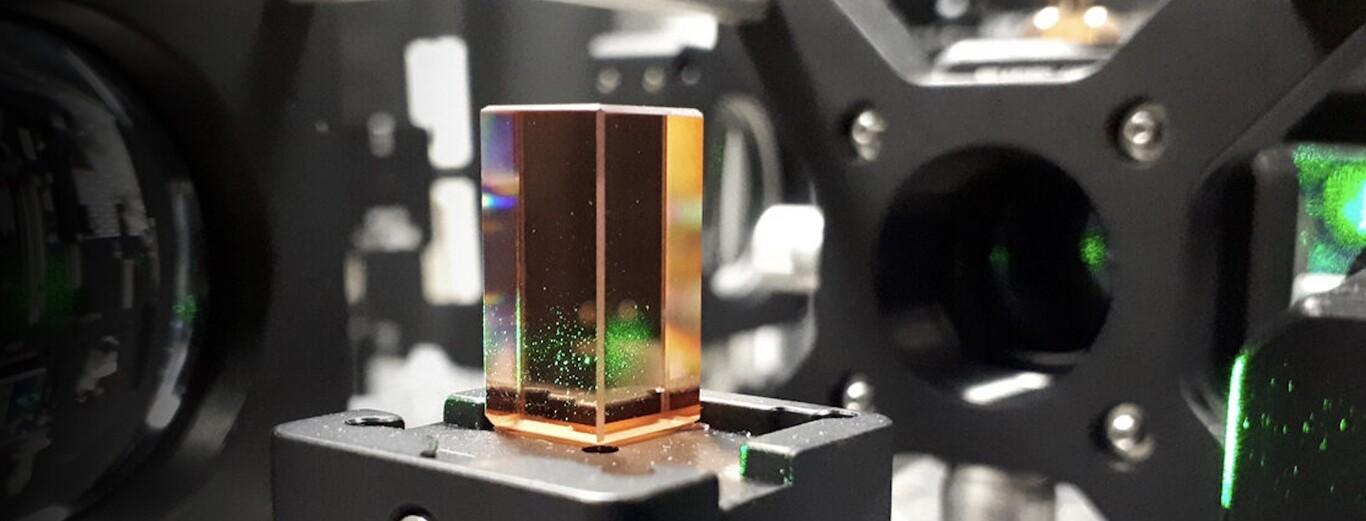

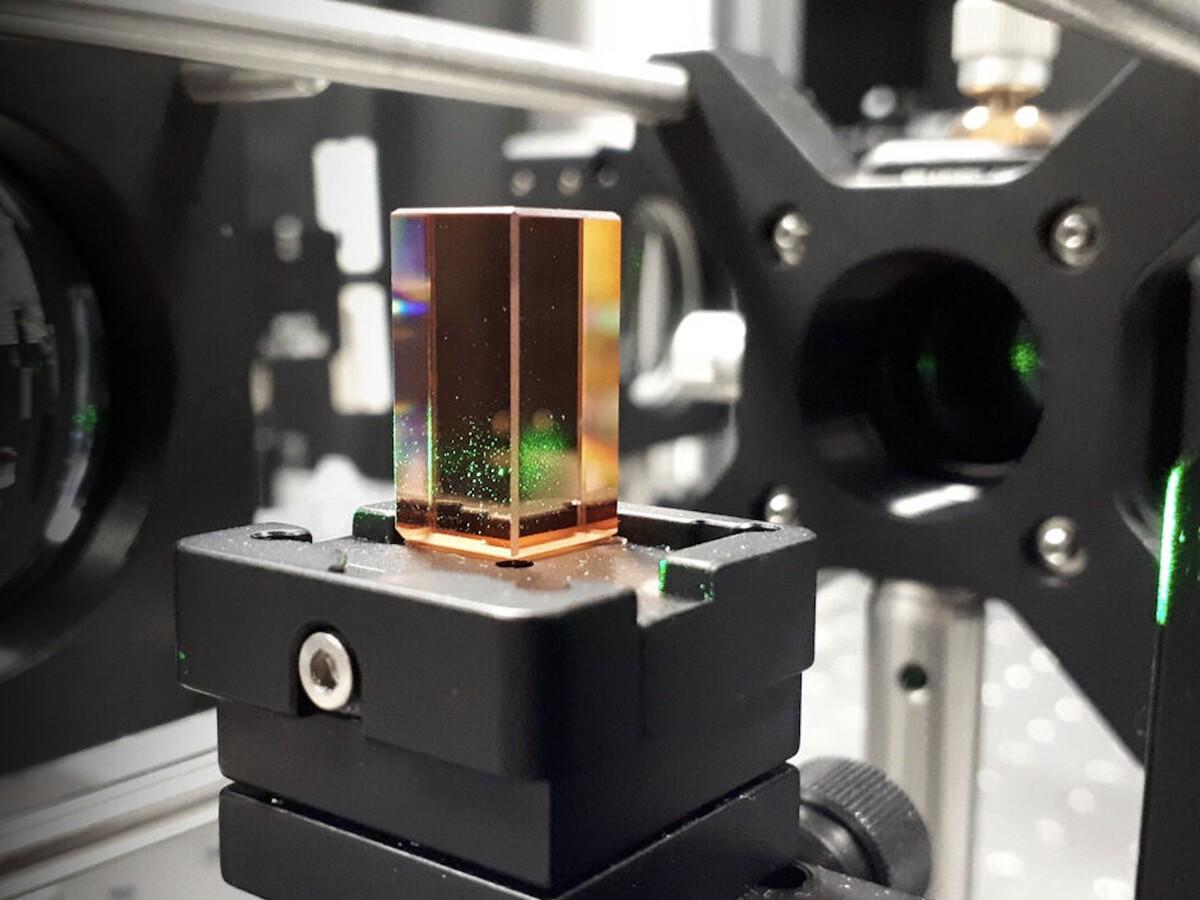

Cuando hablamos de memoria holográfica nos referimos a un sistema de almacenamiento que utiliza láseres para registrar y recuperar información en tres dimensiones dentro de un medio fotosensible, normalmente un cristal, un polímero o un nanocompuesto especial. A diferencia de los dispositivos clásicos, donde los bits se guardan en capas magnéticas o eléctricas sobre una superficie, aquí se aprovecha todo el volumen del material, lo que abre la puerta a densidades brutales de datos.

El principio físico que hay detrás se basa en la interferencia de ondas de luz. Un láser se divide en dos haces: uno se modula con la información que queremos grabar (haz de objeto) y el otro actúa como referencia. Cuando ambos se cruzan dentro del material fotosensible generan un patrón de interferencia muy complejo, una especie de “huella tridimensional” que queda fijada como holograma.

Para leer esos datos, basta con iluminar de nuevo el material con el haz de referencia original. La luz reconstruye el haz de objeto y, con la ayuda de sensores o cámaras, podemos recuperar la información codificada. Lo potente de este enfoque es que, en lugar de leer bit a bit de forma secuencial, se pueden recuperar grandes bloques de datos de una sola vez.

En los laboratorios se ha demostrado que es posible almacenar múltiples hologramas en la misma región física cambiando el ángulo del haz de referencia, su longitud de onda o la posición dentro del volumen. Eso significa que, literalmente, se pueden “apilar” distintos conjuntos de datos en el mismo espacio del soporte.

Avances en materiales: nanocompuestos y proteínas microbianas

Uno de los frentes más activos de la memoria holográfica experimental es el desarrollo de nuevos materiales fotosensibles. Un grupo de la Universidad Tecnológica de Dublín, por ejemplo, está estudiando fotopolímeros que incorporan nanopartículas magnéticas. Estos nanocompuestos permiten registrar información holográfica y, al mismo tiempo, aprovechar propiedades magnéticas o magnetoópticas para mejorar el control del proceso.

Estos fotopolímeros dopados con nanopartículas resultan muy atractivos para la industria porque son más fáciles de manipular que los cristales clásicos y se prestan bien a procesos de fabricación en masa. Ofrecen auto-procesamiento (el propio material ajusta su estructura al ser iluminado), alta sensibilidad espectral y un coste potencialmente bajo si se llega a producir a gran escala.

Gracias a estos materiales se abren puertas no solo para el almacenamiento de datos, sino también para interferometría holográfica, sensores, concentradores solares holográficos y toda una familia de dispositivos ópticos avanzados. La clave está en que estas matrices poliméricas pueden albergar partículas magnéticas de tamaño nanométrico, de modo que en el futuro podrían integrarse conceptos de almacenamiento magneto-óptico en soportes de pequeño tamaño y gran capacidad.

En otro extremo del espectro, algunos grupos han explorado opciones bastante rompedoras, como el uso de proteínas microbianas fotosensibles. Un ejemplo curioso es la bacteriorodopsina, una proteína producida por el microorganismo Halobacterium salinarum cuando hay poco oxígeno. Esta molécula es extremadamente sensible a la luz y puede cambiar de estado de forma estable, lo que la convierte en candidata para almacenar hologramas a bajo coste.

La gran ventaja de estos sistemas biológicos es que las proteínas podrían producirse en cantidades industriales mediante ingeniería genética, reduciendo el precio del soporte. El reto está en conseguir que los estados fotográficos sean estables durante años y que el proceso de escritura y borrado sea suficientemente rápido y repetible para aplicaciones reales.

Cómo se codifica y se lee la información en un holograma

La mecánica básica del almacenamiento holográfico es sencilla de describir, pero muy delicada de implementar. Primero, la información digital se organiza en forma de matriz de bits que se traduce en un patrón de luz y oscuridad, similar a una diapositiva o un “page data” bidimensional. Ese patrón se introduce en el haz de objeto mediante un modulador espacial de luz.

El haz de referencia, estable y bien controlado, se cruza con el haz de objeto dentro del volumen fotosensible. El resultado es un patrón de interferencia tridimensional que depende de la fase, la amplitud y el ángulo de ambos haces. Ese patrón altera de forma microscópica el índice de refracción del material o su estructura interna, quedando “congelado” como holograma.

Una de las maravillas de la holografía es que cada pequeña porción del material contiene información de la imagen completa. Si cortásemos una placa holográfica en varios fragmentos, cada trozo seguiría reproduciendo la imagen entera, aunque con menor definición. Esta propiedad explica la enorme robustez frente a daños físicos parciales y la capacidad teórica para distribuir información a lo largo de todo el volumen.

Además, se pueden grabar múltiples hologramas en el mismo sitio variando parámetros como el ángulo del haz de referencia o su longitud de onda. Luego, para recuperar un conjunto de datos concreto, se ilumina el material con el mismo ángulo o la misma frecuencia que se usó al grabar, haciendo que aparezca solo el holograma deseado. Es algo así como cambiar de “canal” dentro del mismo trozo de cristal.

Este enfoque permite almacenar cantidades masivas de información: estudios teóricos muestran que en unos pocos centímetros cúbicos de material se pueden guardar decenas de terabytes, siempre que se dominen bien los fenómenos de interferencia, difracción y ruido óptico que aparecen cuando se saturan los soportes.

Memoria holográfica magnónica: ondas de spin y almacenamiento 3D

Más allá de la óptica pura, hay líneas de trabajo que combinan magnetismo y holografía. Un ejemplo llamativo viene de la Universidad de California en Riverside, donde un equipo ha desarrollado el concepto de Magnonic Holographic Memory. En lugar de usar luz visible, se apoyan en ondas de spin (magnones), es decir, excitaciones colectivas del estado magnético de un material.

La idea es mantener la electrónica convencional para la lógica, pero utilizar estas ondas de spin de longitud de onda muy corta como soporte de la información almacenada. Al poder trabajar con escalas en torno a los cien nanómetros, el margen para concentrar datos es enorme. La inspiración holográfica viene del hecho de que las interferencias entre ondas de spin permiten codificar y leer información en tres dimensiones.

Según las estimaciones del equipo, si se consigue refinar la técnica y llegar a ondas de spin del orden de cien nanómetros, se podría alcanzar una densidad cercana a 1 terabyte por centímetro cuadrado. En la práctica, eso supondría multiplicar por más de treinta la capacidad de muchos discos duros portátiles actuales en el mismo espacio.

En los prototipos iniciales, el grupo ha trabajado con circuitos de apenas dos bits, manejando ondas de unos 10 micrómetros de longitud, todavía muy por encima del objetivo. Aun así, estos experimentos sirven como prueba de concepto de que el enfoque magnónico-holográfico es viable y podría aplicarse a tareas muy pesadas computacionalmente, como el reconocimiento facial o el análisis masivo de patrones.

Algunos expertos, como investigadores del MIT, señalan sin embargo que el riesgo de estas líneas de trabajo es que la tecnología clásica evolucione tan rápido que, cuando las soluciones holográficas estén maduras, podrían resultar económicamente poco competitivas frente a memorias más tradicionales pero enormemente optimizadas.

El salto al almacenamiento masivo: de Microsoft a los centros de datos

En el terreno empresarial, compañías como Microsoft exploran cómo aprovechar el almacenamiento holográfico y óptico avanzado para sus centros de datos en la nube. La motivación es clara: hace falta guardar cantidades astronómicas de información en espacios reducidos, con buena velocidad de acceso y costes asumibles.

Hasta ahora, el equilibrio se ha mantenido combinando discos duros (baratos pero lentos) y memorias flash (rápidas pero más caras). Sin embargo, el crecimiento constante de los datos obliga a buscar tecnologías que permitan ir más allá de los límites físicos y de miniaturización de las memorias actuales.

En este contexto entra en juego la idea de almacenar datos en pequeños cubos de cristal holográficos. El concepto de Microsoft es utilizar láseres para escribir información codificada como patrones tridimensionales dentro del cristal, y leerla después proyectando un haz y capturando la luz resultante con una cámara de alta resolución, algo parecido a un código QR 3D pero muchísimo más denso.

Una de las grandes ventajas de este método es que, al ser un sistema verdaderamente tridimensional, basta con cambiar ligeramente el ángulo de lectura para acceder a conjuntos completamente distintos de datos, como si estuviéramos “pasando de página” dentro del mismo bloque físico de cristal.

Además, se han propuesto técnicas para borrar y reescribir los hologramas mediante luz ultravioleta, lo que podría convertir estos soportes en memorias regrabables, algo esencial si se pretende usarlos en entornos donde los datos cambian con frecuencia. Proyectos relacionados como Project Silica, también de Microsoft, han explorado el almacenamiento en cristal de forma no regrabable, más orientado a archivo frío de muy largo plazo.

Ventajas clave del almacenamiento holográfico frente a las memorias clásicas

Las promesas de la memoria holográfica son llamativas, y no solo en lo relativo a capacidad. Entre los beneficios teóricos más citados destacan varios puntos que, si se materializan a nivel comercial, podrían cambiar el panorama del almacenamiento.

En primer lugar, la densidad de datos por unidad de volumen es potencialmente enorme. Se habla de capacidades de 1 terabyte por centímetro cúbico o incluso mucho más, dependiendo del material y de la calidad óptica del sistema. En algunos estudios se ha calculado que una superficie de película holográfica de unos pocos centímetros cuadrados podría contener información equivalente a decenas de biblias.

En segundo lugar, la lectura y escritura se realizan de forma masivamente paralela. En vez de mover un cabezal mecánico a través de pistas o de leer celdas individuales, se puede acceder a bloques completos de datos en milisegundos mediante un único disparo de láser y la captura de una imagen completa, lo que se traduce en tasas de transferencia muy elevadas.

También destaca la robustez a largo plazo. Los soportes holográficos, especialmente los cristalinos o algunos polímeros estables, pueden mantener la información durante décadas sin degradación apreciable, siempre que se almacenen en condiciones adecuadas. Esto los hace muy interesantes para archivos históricos, colecciones audiovisuales, documentación legal o científica que deba perdurar.

Finalmente, al carecer de partes móviles y no depender de fenómenos de desgaste eléctrico como en las celdas flash, se espera una buena resistencia frente a golpes, radiación o variaciones de temperatura. La principal vulnerabilidad está en la óptica de lectura y en la estabilidad del láser, más que en el propio medio de almacenamiento.

Limitaciones, costes y barreras para la adopción masiva

Todo lo anterior suena muy seductor, pero la realidad es que la memoria holográfica experimental todavía arrastra varios problemas serios que frenan su salto al mercado de consumo. El primero de ellos es el coste global del sistema: no basta con que el material fotosensible sea asequible, también hay que incluir ópticas de precisión, láseres estables, cámaras rápidas y electrónica de control muy fina.

Otro freno importante es la miniaturización. Integrar estos sistemas en formatos compactos, como tarjetas o unidades portátiles, implica condensar todo el banco óptico en dispositivos muy pequeños y robustos, algo que hoy por hoy sigue siendo complicado y caro. Por eso, la mayoría de prototipos se plantean más para centros de datos o aplicaciones industriales que para el usuario doméstico.

La falta de estándares de formato y compatibilidad es otro escollo. Mientras que en el mundo de los discos o de las memorias flash todo está estandarizado (interfaces, protocolos, formatos de archivo), en el terreno holográfico cada grupo de investigación trabaja con su propio esquema de codificación y lectura. Sin normas claras resulta difícil que los fabricantes se animen a invertir fuerte.

A esto se suma un factor más mundano: la competencia feroz de las tecnologías consolidadas. Discos duros y SSD siguen reduciendo su coste por gigabyte año tras año, y la ingeniería sobre memorias flash (3D NAND, QLC, PLC, etc.) exprime al máximo su capacidad. Si el almacenamiento holográfico llega tarde o demasiado caro, podría quedar relegado a nichos muy específicos.

Por si fuera poco, en muchos casos la tecnología se mueve todavía en el terreno de prototipos de laboratorio, con volúmenes pequeños de datos y sistemas poco robustos, lo que obliga a seguir refinando materiales, ópticas, algoritmos de corrección de errores y procesos de fabricación antes de pensar en una producción masiva.